NVIDIAが解説するディープラーニングの基礎(後編):CNN/RNNやフレームワーク概要まで(1/5 ページ)

エヌビディアは2018年4月24日、ディープラーニングに関するセミナー「NVIDIA Deep Learning Seminar 2018」を東京都内で開催した。本稿では、セッション「これから始める人のためのディープラーニング基礎講座」から、各種ニューラルネットワークやその応用例、ディープラーニングフレームワークの概要について紹介する。

エヌビディアは2018年4月24日、同年3月26日から29日まで米国カリフォルニア州シリコンバレーで開催された年次イベント「GTC 2018」の発表から、特にディープラーニングに関する内容を日本語で紹介するセミナー「NVIDIA Deep Learning Seminar 2018」を東京都内で開催した。

本稿では前編記事に続き、同セミナー最初のセッション「これから始める人のためのディープラーニング基礎講座」で同社ディープラーニングソリューションアーキテクトの山崎和博氏が語った内容から、各種ニューラルネットワークやその応用例、ディープラーニングフレームワークの概要について紹介する(前編記事:NVIDIAが解説するディープラーニングの基礎(前編))。

畳み込みニューラルネットワーク(CNN)

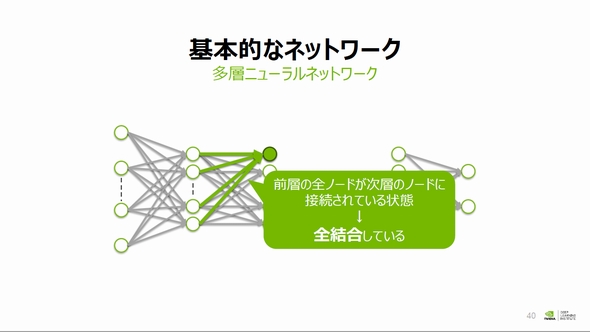

前編で扱ったニューラルネットワークは、前層にある全ノード(パーセプトロン)が次層のノードに全て接続されており、信号は入力から出力まで一方向に流れる。これを「全結合」な順伝播型多層ニューラルネットワークと定義される。

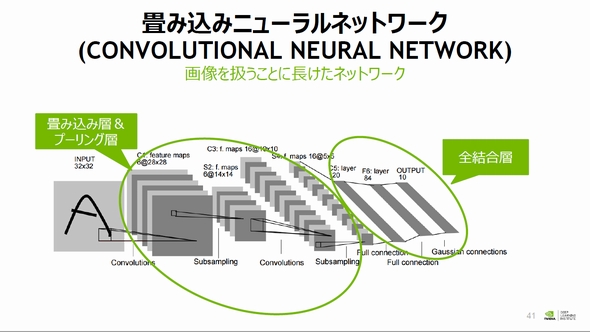

一方で、画像や2次元的な構造を持つデータについて機械学習を行う場合、「畳み込みニューラルネットワーク(CNN:Convolutional neural network)」が用いられることが多い。このCNNは隠れ層の一部または全部で、局所ノードのみ結合する「畳み込み層(コンボリューションカーネル)」や「プーリング層」を含む構造を持つ。

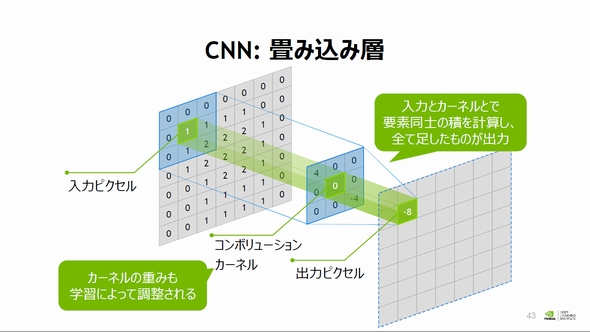

畳み込み層は畳み込み演算と呼ばれる処理を行っており、入力データの任意の範囲に対して畳み込み層の重み係数を乗算し、これらを全て足したものを出力する(積和演算)。また、プーリング層は畳み込み層の後方に通常では設定され、データを圧縮する効果を持つ。これにより、学習コストの低減や過学習の防止、データのズレやノイズへの耐性を上げることができるという。

Copyright © ITmedia, Inc. All Rights Reserved.