Googleが「TPU 3.0」を発表、1ポッドで100PFLOPS:Google I/Oを開催(2/3 ページ)

Googleは、米国カリフォルニア州サンノゼで開催した開発者向け年次ベント「Google I/O」(2018年5月8〜10日)で、AI(人工知能)向けアクセラレータチップ「Tensor Processing Unit(TPU)」の新世代「TPU 3.0」を発表した。

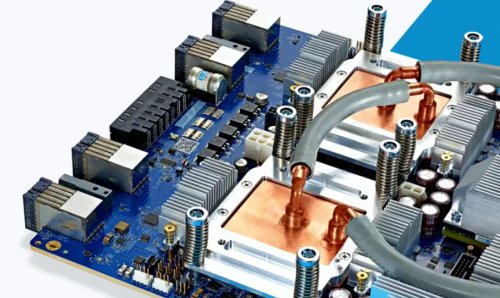

液冷システムの導入へ

GoogleのPichai氏は、「TPU 3.0は、処理能力が前世代と比べて8倍の100ペタFLOPS以上に向上し、Googleのデータセンター向けプロセッサとして初めて液体冷却システムを導入する」と説明した。

Googleは、TPU 3.0チップと、TPU 3.0チップベースのシステムに関しては、詳細を明らかにしていない。それよりも、クラウドサービスとして提供されているシステムとしてはまだ初期の段階にある、TPU 2.0システムの使い方について重要視しているようだ。

Googleが、TPU 3.0に関するインタビューを拒んでいることから、TPU 3.0がまだ研究の段階であるということが分かる。同社は現在も、TPU 2.0クラウドサービスが、拡大の一途にありながらも制限的な参照モデルでしか利用できないという点に関して、NVIDIAなどのライバル企業から激しい非難を受けている。

Googleにとって良いニュースとして挙げられるのは、「Cloud TPU」の性能が確実に向上しているという点だ。同社は、画像および音声認識ジョブ全体で、ニューラルネットワークモデルのトレーニングを、数時間から数日間にわたって動作させ、500米ドル未満のコストに抑えることに成功したとする成果を明らかにした。50米ドルを下回るコストを実現できたケースもいくつかあったという。従来のジョブでは、数週間にわたる動作で数千米ドルのコストが生じていたことから、コストを大幅に削減できることになる。

この分野は、動きが非常に速い。Googleは、米スタンフォード大学で最近行われた、エンド・ツー・エンドのディープラーニングベンチマークの競争「DAWNBench」において、Fast.AIが披露したアルゴリズムの中に、Cloud TPUサービスの最新機能を統合している。この技術により、ResNet-50モデルの学習コストを、従来の59米ドルから、25米ドルまで削減することが可能になったという。

Copyright © ITmedia, Inc. All Rights Reserved.