ニュース

シングルプロセッサで200億パラメーターを持つAIモデルを学習:Cerebrasのウエハースケールエンジン(2/3 ページ)

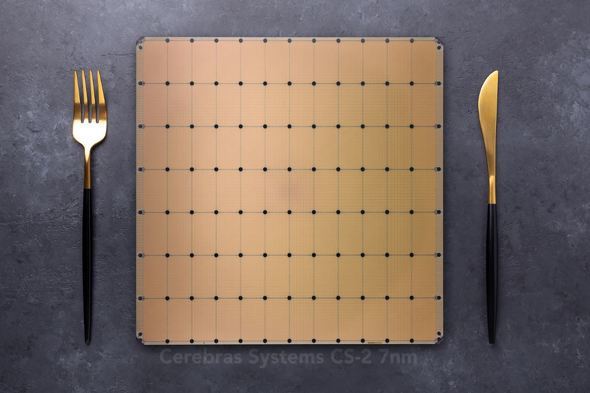

Cerebras Systems(以下、Cerebras)は、第2世代のウエハースケールエンジンの能力を披露し、単一デバイスでトレーニングしたAI(人工知能)モデルとして最大記録を樹立したと発表した。

ウエハーサイズプロセッサの能力

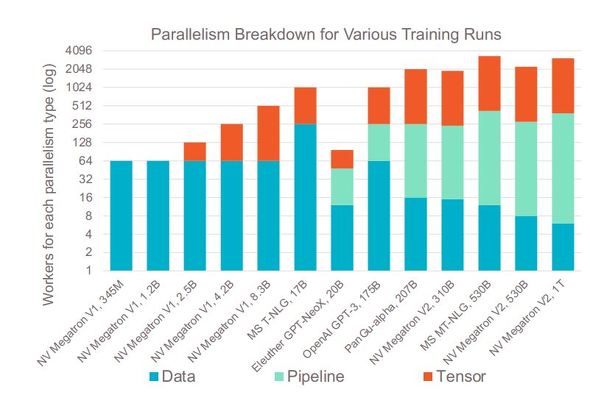

Cerebrasの発表にあるGPT-NeoX 20Bのような巨大モデルは、トレーニングに3種類全ての並列処理が必要になる。

Cerebrasの「CS-2」は、プロセッササイズが非常に大きく(ウエハーサイズの単一チップ上に85万個のコアを集積した巨大プロセッサで、最大のネットワーク層にも十分な大きさ)、メモリと演算が分離されているため、モデルを並列化する必要がない。システムの演算部分のアーキテクチャは同じままで、演算を追加せずにメモリを追加して、より多くのパラメーターをサポートすることができる。

並列処理を利用する必要がないため、マルチプロセッサシステムで実行するためにモデルを手動で分割する時間とリソースを費やす必要がない。さらに、プロセスのカスタムパートがないため、モデルの移植が可能である。複数のパラメーターを持つGPTモデル間の変更は、1つのファイル内で4つの変数を変更するだけでできる。同様に、「GPT-J」と「GPT-Neo」の変更も、キーを数回押すだけでできる。Cerebrasによると、これによって数カ月分のエンジニアリング時間を削減できるという。

Copyright © ITmedia, Inc. All Rights Reserved.