AMDの新GPUは、NVIDIA H100に比肩しうるか?:生成AI市場で競争激化(1/3 ページ)

AMDは2023年6月、NVIDIAのフラグシップGPU「H100」に対抗する製品として、生成AI向けの高性能GPU「MI300X」を発表した。「AIは最大かつ最も戦略的な成長機会」とするAMDだが、新製品によって、市場を先行するNVIDIAに迫ることができるだろうか。

AMDは、米カリフォルニア州サンフランシスコで2023年6月13日(現地時間)に開催したイベント「Data Center and AI Technology Premiere」において、新しいデータセンターCPU/GPU製品をはじめとするAI(人工知能)関連のビジョンを発表した。同社は、AIを実行可能なほぼ全ての製品ポートフォリオを披露し、スーパーコンピュータやハイパースケールの分野における自らの成功を強調した。しかし、誰もが本当に知りたいのは、「AMDの新型GPUは、競合であるNVIDIAのフラグシップGPU『H100』に比肩しうるか」という点だろう。

AIは、「最大かつ最も戦略的な成長機会」

AMDのCEO(最高経営責任者)であるLisa Su氏は、イベント会場において、「AIは、次世代コンピューティングを形成する決定的な技術だ。率直にいうと、AMDにとってAIは、最大かつ最も戦略的な成長機会である」と述べている。

現在H100は、ChatGPTなどの大規模言語モデル(LLM)のトレーニング/推論に対する需要が増大していることを受け、供給不足であることが報じられている。このため、H100に対して信頼性ある競合品を発表するには、またとないチャンスだといえるだろう。

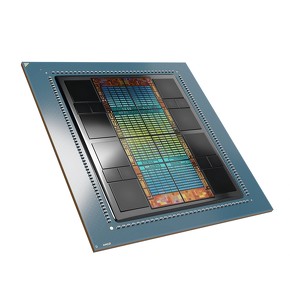

AMDのデータセンターGPUシリーズには、以前に発表された「Instinct MI300A」(以下、MI300A)も含まれる。このMI300Aは、米ローレンスリバモア国立研究所(LLNL:Lawrence Livermore National Laboratory)で稼働予定の2EFLOPS(エクサフロップス)のスパコン「El Capitan」に搭載される。MI300Aは、CPU/GPUチップレットを混在させた13個のチップレットを持つ設計で、HPC向けとしては一般的な組み合わせだ。

Su氏はAMDのイベントの中で、新しい「Instinct MI300X」(以下、MI300X)の詳細について、「MI300Aの3つのCPUチップレットを2つのGPUチップレットに置き換えた、MI300AのGPU専用バージョンである」と発表している。特にLLMや各種AIワークロードを最適化するために、HBM(High Bandwidth Memory)やメモリ帯域幅が追加されているという。

GPUチップレットは、AMDの第3世代アーキテクチャ「CDNA3」が適用され、「Instinct MI250」や旧世代品と比べてAIフレンドリーなデータフォーマットを備えた、新しい計算エンジンを搭載している。

Copyright © ITmedia, Inc. All Rights Reserved.