Xilinx、機械学習の推論に強いFPGAをアピール:「競合比2〜6倍の効率」(1/2 ページ)

Xilinx(ザイリンクス)は2016年12月、データセンター向けのビジネスに関する記者説明会を都内で開催した。

8ビット整数演算での効率

Xilinx(ザイリンクス)は2016年12月8日、東京都内でデータセンター向けビジネスに関する記者説明会を開催し、Xilinx製FPGA製品がデータセンターにおける機械学習(マシンラーニング)の推論プロセスに適したデバイスソリューションであるとアピールした。

機械学習における推論プロセスとは、機械学習によりあらかじめ生成した推論モデルをベースに、未知のデータがどのようなものかを推論し、導き出すこと。機械学習の処理は、多数の学習データから推論モデルを生成する学習プロセスと、推論プロセスの2つに大別される。

大規模なデータセンターを展開するWebサービス事業者などが機械学習を使用する場合、1つの推論モデルを多数のユーザーが使用するケースがほとんどであり、1回の学習に対し、推論を行う回数は膨大になる。そのため、学習プロセスと推論プロセスでは求められる処理能力が異なる。学習プロセスは、膨大な学習データを処理するため、より容量の大きな処理能力と高い精度が求められる。逆に、推論プロセスは、高速性や膨大な数の処理を行うための効率性が求められるのが一般的だ。そのため、学習プロセスに用いられるのは32ビット浮動小数点演算器であるのに対し、推論プロセスでは16ビットや8ビットの整数演算器など比較的シンプルな演算器を並列化させる方が高速、高効率に処理できるとされる。実際、推論処理の高速化を目指したGoogleのカスタムプロセッサ「TPU」やNVIDIAの「Tesla P4」は8ビット整数演算を行うとされる。

競合比での優位性を強調

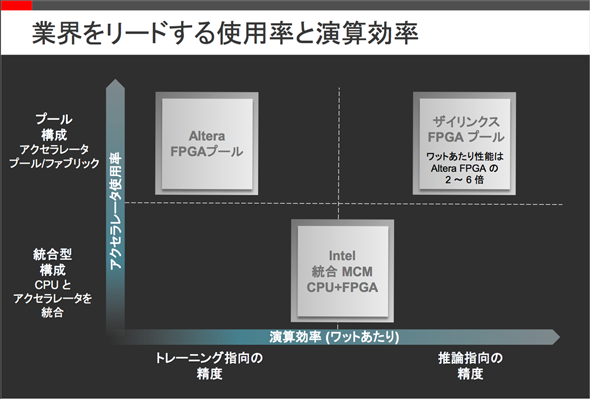

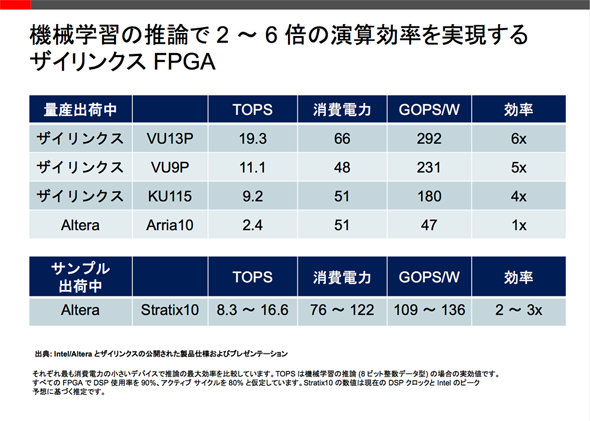

Xilinxは、自社製FPGAが競合のFPGAに比べ、こうした推論プロセスに向く8ビット整数演算処理に向くと主張する。

Xilinxでクラウドコンピューティング担当ストラテジックマーケットデベロップメントディレクタを務めるAndy Walsh氏は、「(16nm世代FPGA製品である)『Virtex UltraScale+/VU13P』の電力当たりの8ビット整数演算処理能力は、(Intel/Altera製20nm世代FPGAである)『Arria10』に比べ6倍優れている。(Intel/Altera製14nm世代FPGAである)『Stratix10』と比べても2倍ほど優れる見込み」とした。

8ビット整数演算での効率が高いとする理由について「競合メーカーは、32ビット浮動小数点演算性能を重視したが、Xilinxはさまざまな議論を経て8ビットで最も効率が高まるように設計、開発したため」(日本法人社長サム・ローガン氏)という。

Copyright © ITmedia, Inc. All Rights Reserved.