自動運転ベンチャーが独自のCNN IPコアを開発した理由:GPU一強の時代は終わりつつある(2/3 ページ)

菱洋エレクトロと自動運転ベンチャーの「AImotive(エーアイモーティブ)」は、AImotiveが開発した独自IP(Intellectual Property)による畳み込みニューラルネットワーク(CNN:Convolutional Neural Network)アクセラレーター「aiWare」と、同社の自動運転ソフトウェア「aiDrive」を搭載したデモ車両を日本で初披露した。

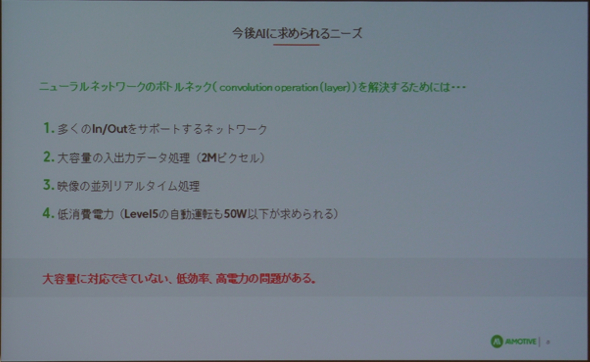

GPUのボトルネック解消を狙う

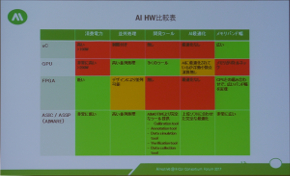

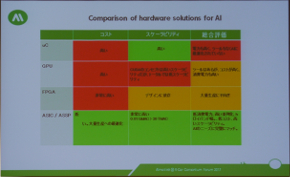

では、なぜaiDriveなどソフトウェアに強みを持つAImotiveは、独自IPのaiWareを開発するのか。AImotive Head of Chip TechnologyのMárton Fehér氏は「CNNでボトルネックとなっているのは、畳み込み演算部となる。しかし、畳み込み演算はあまり複雑な処理ではない」と指摘しつつ、「レベル5自動運転に対応してカメラの解像度と個数が増加すると、GPUを含めた既存のアクセラレーターでは、低レイテンシとスケーラビリティ、低消費電力を両立することは難しい」ためだという。

また旧AdasWorks時代の経験から、同社は2〜3年前よりGPUのボトルネックの大きさと、低い演算性能使用率(低電力効率)を問題視していたことも、aiWare開発のモチベーションとなった。

aiWareの構造と性能比較

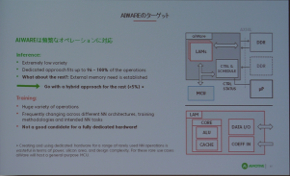

aiWareは、複数のLAM(Layer Access Module)とコントローラーによって構成される、CNNの推論に特化したモジュラー構造のIPだ。主に畳み込みを担当するLAMは、ALU(算術論理演算器)とキャッシュからなるコア、データI/Oなどを含み、LAM自体の規模や個数を、必要なパフォーマンスレベルに応じてスケーラブルに増やすことができるという。また、aiWareによるCNNの実行は、ホストとなる他のMCUやマイクロプロセッサの介在がほとんど必要ないことも特長だ。

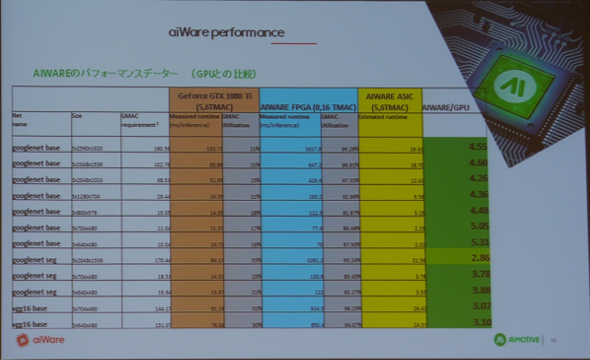

AImoticveではaiWareをFPGAに実装し、さまざまなCNNアーキテクチャやサイズでパフォーマンス試験を実施した。その試験結果から、5.6TMACの演算キャパシティーを持つGPU(NVIDIA GeForce GTX 1080 Ti)と同等のASICにaiWareを実装した場合、aiWareはGPUよりも3〜5倍程度高速にCNNを処理できるという。また、aiWareは演算性能使用率が高いため、電力効率もGPUと比較して優れているとした。

Fehér氏は「aiWare設計において最も貢献したものは、(CNN開発者である)aiDriveチームのフィードバックだ」と語り、自社にCNNのユーザー目線があるからこそGPUを含めた他のCNNアクセラレーターよりも、高効率のIPが開発できたと胸を張る。aiWareは、自動運転への利用が開発初期のモチベーションとなったが、CNNを用いるその他の用途にも活用できるという。

AImotiveは、aiWaveをIPとして提供し、顧客となる半導体ベンダーは提供されたaiWareのRTL(レジスタ転送レベル)を、自社のSoC(System on Chip)設計に組み込むことが可能となる。また、SDK(ソフトウェア開発キット)も同時に提供する予定だとする。評価環境として、aiWareが実装されたFPGA(Intel Arria 10)ボードを既に提供しており、2TMACSの性能を持つテストチップは2018年3月よりリリースするとした。

Copyright © ITmedia, Inc. All Rights Reserved.