ISSCC技術講演の2日目午後ハイライト(その1)、深層学習の高速実行エンジンと超低消費電力のA-D変換器チップ:福田昭のデバイス通信(130) 2月開催予定のISSCC 2018をプレビュー(6)(1/2 ページ)

「ISSCC 2018」2日目午後の技術講演から、見どころを紹介する。SRAMダイとDNN(深層ニューラルネットワーク)推論エンジンを積層した機械学習チップや、消費電力が4.5μWと極めて低い15ビットA-D変換器チップなどの研究論文が発表される。

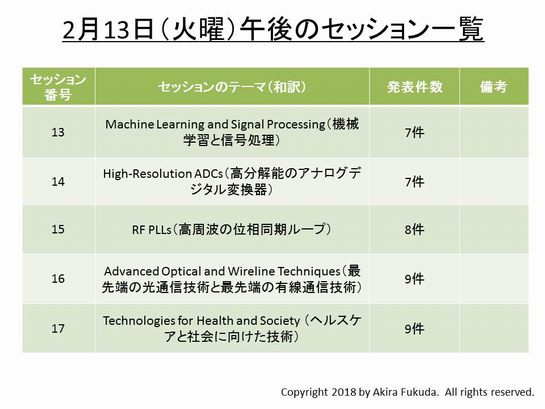

セッション13〜セッション17の5本が同時に進行

2018年(今年)2月に米国サンフランシスコで開催予定の半導体回路技術に関する国際学会、「ISSCC 2018」の概要をシリーズでお届けしている。前回は、メインイベントである技術講演セッションの2日目午前(現地時間で2月13日火曜日午前8時30分開始予定)から、セッション9〜セッション12のハイライトをお届けした。今回と次回は、2日目午後(現地時間で13日火曜日午後1時30分開始予定)の技術講演セッションから、ハイライトをご紹介する。

セッション番号ではセッション13〜セッション17が、2日目の午後に予定されている。すなわち、5本の講演セッションが同時並行で進む。セッション名は、「機械学習と信号処理」(セッション13)、「高分解能のアナログデジタル変換器」(セッション14)、「高周波の位相同期ループ」(セッション15)、「最先端の光通信技術と最先端の有線通信技術」(セッション16)、「ヘルスケアと社会に向けた技術」(セッション17)である。

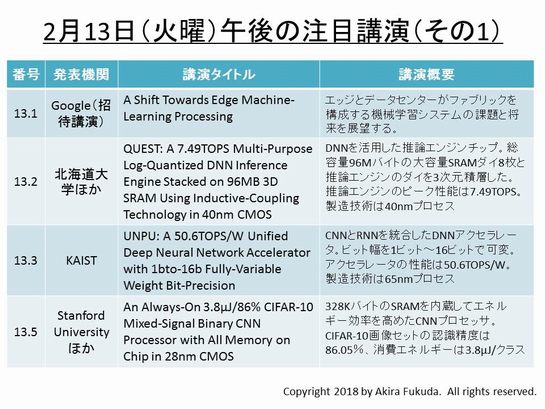

SRAMダイとDNN推論エンジンを積層した高性能機械学習チップ

セッション13の「機械学習と信号処理」では、深層学習(ディープラーニング)による機械学習を高速に実行する回路技術の開発成果が相次いで発表される。はじめにGoogleが招待講演で、エッジ(端末)とデータセンターによって構築する機械学習システムの将来を展望する(講演番号13.1)。エッジが推論だけから学習の機能を備えようとする中で、技術的な課題と解決手法を解説していく。

続いて北海道大学とウルトラメモリ、慶應義塾大学の共同研究グループが、対数量子化方式の深層ニューラルネットワーク(DNN: Deep Neural Network)を利用した推論エンジンチップを発表する(講演番号13.2)。推論エンジンのシリコンダイと8枚のSRAMシリコンダイを3次元積層した。SRAMの総容量は96Mバイト(768Mビット)に達する。SRAMと推論エンジンのデータ転送には磁界結合を採用した。転送速度は最大28.8Gバイト/秒と高い。推論エンジンのピーク性能は7.49TOPS(Tera Operations Per Second)。製造技術は40nmプロセスである。シリコンダイの寸法は14.3mm×8.5mm。

それからKAISTが、畳み込みニューラルネットワーク(CNN: Convolutional Neural Network)と再帰ニューラルネットワーク(RNN: Recurrent Neural Network)を統合したDNNアクセラレータを開発した(講演番号13.3)。消費電力当たりの性能は50.6TOPS/Wと高い。製造技術は65nmプロセスである。シリコンダイ面積は16mm2。

Stanford UniversityとKU Leuvenの共同研究グループは、328KバイトのSRAMを内蔵してエネルギー効率を高めた画像認識用CNNアクセラレータを発表する(講演番号13.5)。メモリセル近傍でアナログ積和演算処理を実行することで効率を高めている。CIFAR-10画像セットの認識精度は86.05%。消費エネルギーは3.8μJ/クラスと低い。製造技術は28nmのCMOSプロセス、シリコンダイの寸法は2.4mm角。

Copyright © ITmedia, Inc. All Rights Reserved.