データセンターを支える光伝送技術 〜ハイパースケールデータセンター編:光伝送技術を知る(4)(3/4 ページ)

今回は、エンタープライズデータセンターに続き、GoogleやFacebook、Appleなどが抱える巨大なデータセンター、「ハイパースケールデータセンター」について解説する。

FacebookとMicrosoftのデータセンターの中身を見てみる

データセンターの構造はほとんど公開されていないが、中には一部を公開している企業もある。例えば、GoogleとFacebookは、各データセンターの様子をWebサイトで紹介している(参考サイト)。Facebookは、「Open Compute Project(OCP)」というプロジェクトで技術を知ることができる(参考サイト)。光伝送の標準化を推奨しているMicrosoftは、プレゼンテーション資料から同社のデータセンターをうかがい知ることができる。

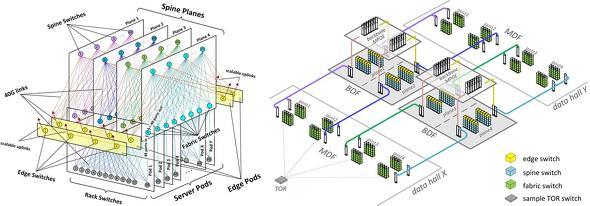

図4に、公開されているFacebookのデータセンターのネットワークを示す。図の左は論理的なトポロジー、右は実際のスイッチの設置を模式的に示したものだ。トポロジーはPod内とPod間で、折り返しClos Networkを交差するように2段重ねしている。注目すべきは、「Edge」と呼ばれる、外部通信ネットワークに接続するスイッチが、Leafと同じレイヤーにあることだ。

物理的な配置を見てみよう。まず、サーバが並んでいるData Hallの端、MDF(Main Distribution Frame)と呼ばれるエリアにFabricスイッチ(Leafスイッチ)がまとめて置かれ、TORと配線されている。Facebookが「BDF(Building Distribution Frame)」と呼ぶData Hallの外にある設備には、Spineスイッチとエッジスイッチが設置され、その上部のMPOE(Minimum Point of Entry)に、外部通信ネットワークとの接続設備が置かれている。Facebookによれば、MDFからBDFとMPOEへの光ファイバーの敷設を工夫し、膨大で複雑なコネクションを、正確に接続できるようになっているという。光ファイバーの敷設の仕方によって光伝送の距離が決まるが、数百メートルと考えられる。

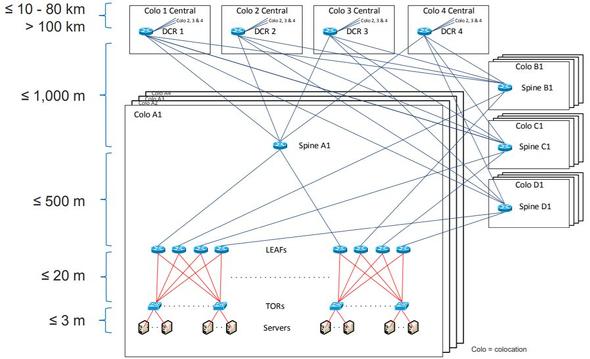

図5に、Microsoftのデータセンターの模式図を示す。

サーバとTORのラックを並べた複数のRowとLeaf/Spineスイッチでからなる「Colo A1」が基本単位となっている。4個の基本単位「Colo A1-4」が上位の構成単位となっている。「Colo A1-4」と同じ構成単位が4つあり、さらに上位に位置する4つの「Colo 1-4 Central」に接続されている。名称からColocationを主眼としたデータセンターであることが分かる。

ネットワークに着目すると、「Colo A1」のLeafスイッチは他の基本単位、例えば「Colo B1」のSpineスイッチにも接続されている。また、全てのSpineスイッチは「Colo 1-4 Central」にあるDCRに接続されている。

配線距離を見ると「Colo A1-4」内のLeafとSpineの接続は500m以下とされ、「Colo A1」のSpineと「Colo B1」のSpineや「Colo 1-4 Central」のDCRとの接続は1000m以下とされている。配線距離は設備の配置によるものであるが、「Colo A1-4」が同じフロアまたは部屋にあり、フロア内配線が500m以下、フロア間配線が1km以下という事だろう。また、DCRとSpineでClosスイッチを構成している可能性もある。

図では不明な点もあるが、数十万台以上のサーバを有するハイパースケールデータセンターでは、このような階層化されたノンブロックネットワークを実現するために、膨大な数の光ファイバーによる複雑な配線が必要であることが分かる。

Copyright © ITmedia, Inc. All Rights Reserved.