アナログCIM回路でCNNとTransformerの処理を実現:容量再構成型CIM構造を提案(1/2 ページ)

慶應義塾大学は、Transformer処理と畳み込みニューラルネットワーク(CNN)処理を、極めて高い演算精度と電力効率で実行できる「アナログCIM(コンピュート・イン・メモリ)回路」を開発した。自動運転車やモバイルデバイスといったエッジコンピューティングにおいて、AI(人工知能)技術の導入が容易となる。

自動運転車やモバイルデバイスへのAI導入が容易に

慶應義塾大学理工学部電気情報工学科の吉岡健太郎専任講師は2024年2月、Transformer処理と畳み込みニューラルネットワーク(CNN)処理を、極めて高い演算精度と電力効率で実行できる「アナログCIM(コンピュート・イン・メモリ)回路」を開発したと発表した。自動運転車やモバイルデバイスといったエッジコンピューティングにおいて、AI(人工知能)技術の導入が容易になる。

画像処理や自然言語処理、音声認識など多くの分野で深層学習が活用されている。しかし、深層学習では演算量が膨大となるため、エッジデバイスなどに応用する場合、効率のよいAIハードウェアが必要となる。ここで注目されているのが、メモリと演算器間で送受信するデータ量を削減可能なCIM計算機構である。

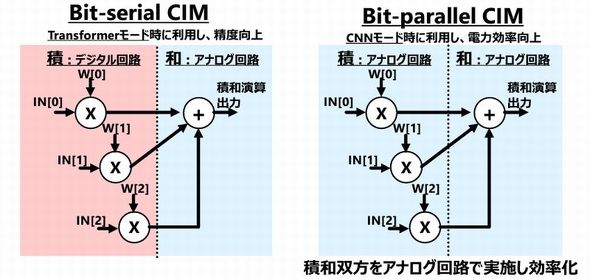

とりわけ、電力と面積効率が重要となるエッジデバイス向けでは、電力効率の高いアナログCIMが必要となる。ただ、画像処理に用いられるCNNでは十分な演算精度が得られるものの、Transformerでは演算精度が不足するといわれてきた。

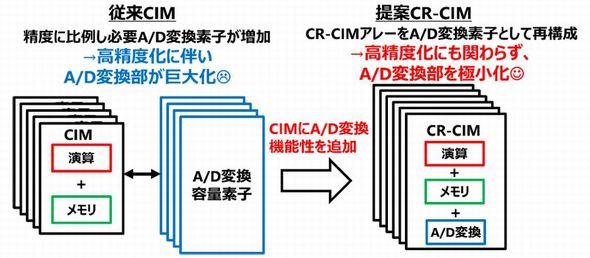

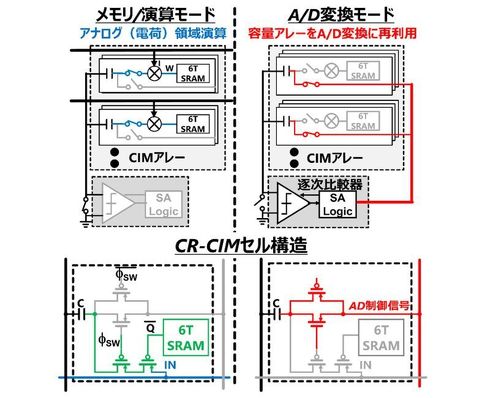

そこで今回、1つのメモリセルに「データ格納用メモリ」や「演算回路」「A-D変換素子」を統合した新しい「容量再構成型CIM(CR-CIM)」構造を提案した。CR-CIMは、演算に用いる回路素子をA-D変換にも再利用する。これによって、Transformer推論に必要な10ビットA-D変換を実現しながら、集積するトランジスタ数を従来に比べ60%削減できたという。

新たに開発したCR-CIMは、CNN動作時に「低精度・高効率演算モード」で、Transformer動作時には「高精度演算モード」で、それぞれ動作する。これによって、TransformerとCNNの両方を効率よく実行することが可能となった。具体的に、CNN動作時は加算だけでなく乗算もアナログ領域で行う「Bit-parallel動作」とし、演算効率を5倍に高めた。この時、演算精度はやや劣化するが、CNNでは十分すぎる精度だという。

Copyright © ITmedia, Inc. All Rights Reserved.