推論性能でNVIDIAに挑む AIチップは「省エネ」が競争の軸に:「MLPerf」の最新スコアを公開(2/4 ページ)

推論ベンチマーク「MLPerf」の最新ラウンドのスコアが公開された。その結果からは、AI用プロセッサの新たな競争の軸が、性能そのものよりも「電力効率」に移りつつあることが読み取れる。

NVIDIA「Blackwell B200」

NVIDIAはこのラウンドで「Blackwell B200」を初公開した。Blackwell B200は、新しいBlackwellアーキテクチャを搭載した初のGPUで、レチクルサイズのコンピューティングダイを2つ搭載しているため、H100/H200の2倍のコンピューティング能力がある。また、H200の141GBに対して180GBとより多くのメモリを搭載している。さらに、FP4をサポートするNVIDIA初のGPUでもある。

サーバモードの単一のB200は、Llama2-70Bdで10755.60トークン/秒の推論が可能で、H100よりも最大で4倍高速である。オフラインモードでは11264.40トークン/秒で、H100よりも最大3.7倍速い。注目すべきは、NVIDIAが今回の結果で初めてFP4に量子化したことだ(提出者は、厳密な精度目標(今回は99.9%)を満たすことを条件に、希望に応じて積極的に量子化することができる)。H200(H100よりも大容量で高速なメモリを搭載し、FP8に量子化)と比較すると、どちらのシナリオでも2.5倍以上の差があった。NVIDIAは、ワークロード全体をFP4に量子化したかどうかについては言及していない。同社のTransformerエンジンソフトウェアは、トレーニングと推論中に最適な結果を得るために混合精度を実現している。

B200の結果は「プレビュー」カテゴリーに提出された。つまり、NVIDIAはBlackwellを6カ月以内に市場投入すると予想される。両社の製品サイクルから、AMDの現世代MI300Xは、近いうちにNVIDIAのB200に匹敵する性能になると予想される。Llama2-70Bの推論では、B200は現在のMI300Xより約4倍高速である。

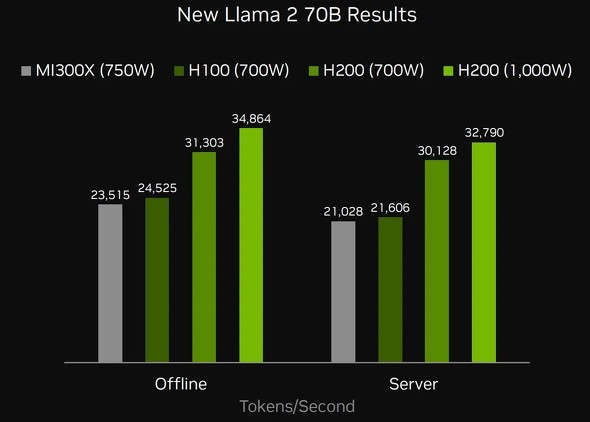

NVIDIAと同社のパートナーは、新しいエキスパートワークロードの組み合わせである「Mixtral-8x7B」の結果を披露した。このワークロードは、総パラメータ数が467億個で、トークンあたり12.9アクティブである(この場合、エキスパートモデルの組み合わせは、「エキスパート」と呼ばれる8つの小さなサブモデルのいずれかにクエリを割り当てる)。Mixtralでは、同じ電力エンベロープ(700W)でH200がH100を上回った。H200はメモリが1.8倍、帯域幅が1.4倍多く、性能は約11〜12%向上している。

NVIDIAは、「前回の推論ラウンドと比較して、『Hopper』GPUから27%高い性能を引き出しており、この成果の多くは当社の開発者ツールに組み込まれている」と述べている。

Copyright © ITmedia, Inc. All Rights Reserved.