GPUの台頭と進化がサーバの消費電力を急増させる:福田昭のデバイス通信(472) AIサーバの放熱技術(5)(1/2 ページ)

AI(人工知能)対応でCPUとGPUの消費電力は増大している。そのため、既存のデータセンターの冷却に大きな負担がかかっている。

人工知能(AI)用途でサーバへの要求性能が急激に上昇

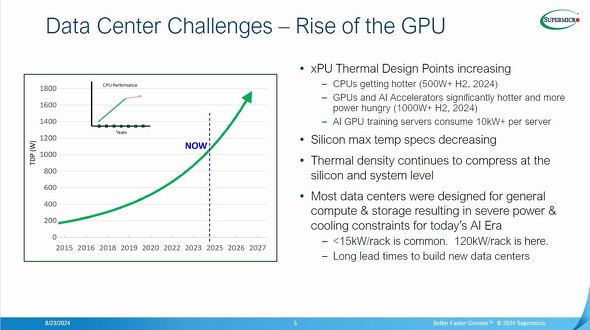

サーバやデータセンターなどの放熱技術に注目が集まっている。演算処理を担うGPUとCPUの最大消費電力(熱設計電力(TDP))が増加しつつあることで、効率の高い放熱技術が強く求められるようになってきた。

そこで本コラムでは、サーバやデータセンターなどを支える最新の放熱技術を本コラムの第468回から、シリーズで説明している。前回は、オープンエリアのデータセンターで使われていた従来方式の放熱技術を簡単に説明した。

従来方式では、ラックマウントしたサーバを配列した部屋(コンピュータルーム)の床下から低温の空気をサーバに送り、サーバで温められて上昇した高温の空気を天井から回収する。回収した高温の空気をコンピュータルームの空調機(CRAC:Computer Room Air Conditioner、「クラック」とも呼ぶ)によって冷やし、低温の空気を床下に送り込む。「強制対流空気冷却(強制空冷)」と呼ばれる方式の1つである。データセンターの冷却システムとしては、コストが最も低い。

しかし最近では、サーバの発熱量が増加したことにより、単なる強制空冷ではサーバの発熱を処理しきれない。何らかの工夫が必要となりつつある。その背景にあるのがAI用途における要求性能の急速な上昇だ。いわゆる「生成AI」を生み出した大規模言語モデル(LLM:Large Language Model)は、モデルのパラメータ数を増やすとモデルの性能(精度)が一気に上昇する。パラメータ数はここ数年で指数関数的(1年で約10倍)に増加してきた。

例えば米国の人工知能開発企業OpenAIが2020年に開発した大規模言語モデル「GPT-3」はパラメータ数が1750億、トークン数(100トークンが75ワードに相当)が3000億という途方もない規模に達している。前世代の「GPT-2」(2019年に公開)はパラメータ数が15億だったので、1世代でパラメータ数が117倍に激増したことになる。GPT-3の学習(訓練)には、発表当時の最先端GPU「A100」を合計で100個搭載したAIサーバ群でも34日間を必要とした。

「学習(訓練)」期間を短くするためには、AI用サーバ(AIサーバ)の演算処理能力も指数関数的に向上させなければならない。このことはCPUとGPUの消費電力の増大をもたらした。前回で述べたように2020年の時点でCPUの消費電力は200W、GPUの消費電力は300Wを超えていた。それが2024年後半にはCPUの消費電力は500W、GPUの消費電力は1000Wに達すると予測されている(参考:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」の内容から)。消費電力はCPUが2.5倍、GPUが3.3倍に達する。

Copyright © ITmedia, Inc. All Rights Reserved.