GPUの台頭と進化がサーバの消費電力を急増させる:福田昭のデバイス通信(472) AIサーバの放熱技術(5)(2/2 ページ)

AI(人工知能)対応でCPUとGPUの消費電力は増大している。そのため、既存のデータセンターの冷却に大きな負担がかかっている。

データセンターの電力使用効率が向上しない

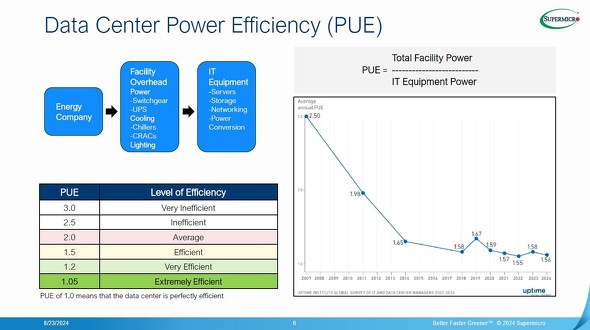

データセンターの消費電力には、情報処理を担うサーバやストレージなど(IT機器)による消費電力のほかに、冷却サブシステムや電源ユニット、照明ユニットなどによる消費電力が存在する。

データセンターの電力効率は一般に、「電力使用効率(PUE: Power Usage Effectiveness)」で評価する。PUEの定義は「データセンター全体の消費電力/IT機器による消費電力」であり、普通は1.0を超える。そしてPUEの値に応じて「3.0:きわめて非効率(Very Inefficient)」から「1.05:きわめて効率が良い(Extremely Efficient)」まで6段階の評価が付く。

データセンターの電力効率とその評価[クリックで拡大] 出所:Supermicroが国際学会Hot Chips 2024のチュートリアルで講義した「Thermal Techniques for Data Center Compute Density」のスライドから

データセンターの品質基準を提供している民間団体Uptime Instituteの調査によると、2007年の時点でデータセンターのPUE(平均値)は2.50(非効率:Inefficient)だった。それが7年後の2014年には、1.65(「1.5の効率が良い:Efficient」と、「2.0の平均的:Average」の間)に向上しており、無駄な電力が大幅に削減されたことが分かる。ところが2018年に1.58に達した後は、PUEがほとんど改善されていない。最近のPUE(平均値)は2022年が1.55、2023年が1.58、2024年が1.56である。

この背景には、既存のデータセンター(施設レベル)の大半が汎用のコンピューティングとストレージを前提に冷却システムを構築してきたという事情がある。前回に述べたように、ラック当たりで10kWというのがコストの低い冷却システムの許容値だ。汎用コンピューティングには妥当でも、AIコンピューティングにとっては厳しい制約となる。

例えば2024年後半を前提にすると、2個のCPU(500W×2=1000W)と8個のGPU(1000W×8=8000W)を搭載するラックマウント型GPUサーバ(標準的な高さは8U)の最大消費電力は、CPUとGPUだけで9kWに達してしまう。実際には主記憶やストレージ、ネットワークスイッチなどが加わるので、10kWを軽く超える。冷却システムは強化せざるを得ず、冷却システムの消費電力とコストが増加する。

⇒「福田昭のデバイス通信」連載バックナンバー一覧

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ラックサーバのデータセンターを支える空冷技術

ラックサーバのデータセンターを支える空冷技術

データセンターの放熱/冷却システムの詳細を解説する。まずは空冷方式を取り上げる。 サーバの主なフォームファクター

サーバの主なフォームファクター

今回は、サーバの主なフォームファクター(外形の形状と寸法)を解説する。大きく分けて、3つのフォームファクターがある。 放熱と冷却の基本的な技術

放熱と冷却の基本的な技術

今回は、放熱と冷却の基本的な技術を解説する。 熱に関する基礎知識

熱に関する基礎知識

「Hot Chips 2024」の技術講座(チュートリアル)のテーマは放熱技術だった。CPU/GPUの消費電力が増加し、サーバやデータセンターの放熱技術に対する注目が集まっているからだ。本シリーズでは、Hot Chips 2024の技術講座などをベースに、最新の放熱技術を解説する。 3端子貫通型フィルタの接続方法と実装レイアウト

3端子貫通型フィルタの接続方法と実装レイアウト

今回は「(2)3端子貫通型フィルタの接続と実装のポイント」の概要を説明する。3端子貫通型フィルタを電源ラインに接続する2つの方法と、それぞれの用途を解説する。 チップ抵抗器の小型化が過度な温度上昇を招く(前編)

チップ抵抗器の小型化が過度な温度上昇を招く(前編)

今回から、第4章第1節第3項「部品実装・設計時の注意点」の概要を説明していく。この項は、「熱設計」「電気性能」などの4つのパートで構成される。