NVIDIAの「GPU祭り」はまだ序章? 生成AIブームは止まらない:湯之上隆のナノフォーカス(76)(2/5 ページ)

NVIDIA製GPUの需要が高まる“GPU祭り”は、今後どうなっていくのだろうか。本稿では、AI(人工知能)サーバの出荷台数のデータを読み解きながら、NVIDIAの“GPU祭り”の行く末を予想する。

2種類あるAIサーバの定義

DIGITIMES Researchがリリースした”Global annual server shipments, 2023-2024”(Servers Report Database, 2024)によれば、AIサーバには次の2種類がある。

- HBMを搭載していないAIアクセラレーターを2個以上搭載しているシステムを「汎用AIサーバ」という

- HBMを搭載したAIアクセラレーターを少なくとも4個搭載したシステムを「ハイエンドAIサーバ」という

ここで、AIアクセラレーターとは、AIアプリケーション、特にニューラルネットワークや機械学習を高速化するために設計された特殊なハードウェアのことであり、その典型例がNVIDIAのGPUである。そして、ChatGPTレベルの生成AIの開発と稼働には、汎用AIサーバではなく、ハイエンドAIサーバが多数必要となる。

では、汎用AIサーバとハイエンドAIサーバはどのくらい出荷されているのか?

汎用AIサーバとハイエンドAIサーバの出荷台数

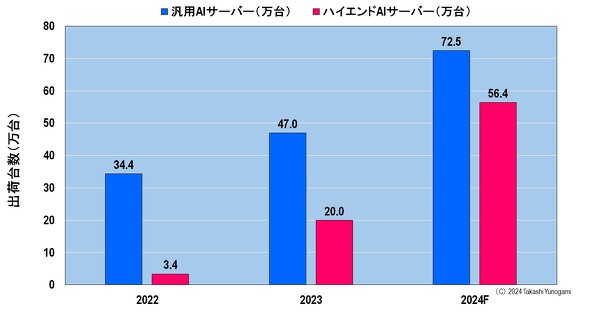

図4に、2022〜2023年における汎用AIサーバとハイエンドAIサーバの出荷台数を示す。汎用AIサーバは、2022年に34.4万台、2023年に47万台出荷され、2024年に72.5万台出荷される見込みである。

図4 汎用AIサーバーとハイエンドAIサーバーの出荷台数(2022〜2024年)[クリックで拡大] 出所:DIGITIMES Research: Servers Report Database, 2024, ”Global annual server shipments, 2023-2024”

一方、ChatGPTレベルの生成AIの開発や稼働に必要なハイエンドAIサーバは、2022年に3.4万台、2023年に20万台出荷され、2024年に56.4万台出荷される見込みとなっている。

それでは、このハイエンドAIサーバの出荷台数が、米CSPの需要を満たしているのだろうか?

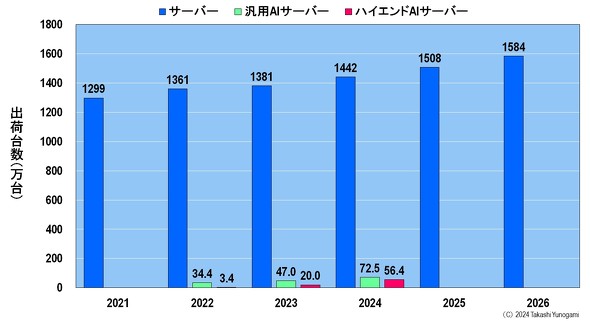

図5に、サーバ、汎用AIサーバ、ハイエンドAIサーバの出荷台数を示す。筆者は、このグラフを書いて見て、「ハイエンドAIサーバの出荷台数って、これっぽっち?」と、がくぜんとしてしまった。汎用AIサーバにしてもハイエンドAIサーバにしても、サーバ全体から見ると、その出荷台数があまりにも少ないからだ。

図5 サーバ、汎用AIサーバ、ハイエンドAIサーバの出荷台数[クリックで拡大] 出所:MICおよびDIGITIMES Research: Servers Report Database, 2024, ”Global annual server shipments, 2023-2024”を基に筆者作成

そして、ChatGPTレベルの生成AIの開発や稼働には何基のハイエンドAIサーバが必要かを調べてみみて、筆者はさらにがくぜんとすることになった。

Copyright © ITmedia, Inc. All Rights Reserved.