NVIDIAの「GPU祭り」はまだ序章? 生成AIブームは止まらない:湯之上隆のナノフォーカス(76)(3/5 ページ)

NVIDIA製GPUの需要が高まる“GPU祭り”は、今後どうなっていくのだろうか。本稿では、AI(人工知能)サーバの出荷台数のデータを読み解きながら、NVIDIAの“GPU祭り”の行く末を予想する。

ChatGPTレベルの生成AIに必要なハイエンドAIサーバ

ChatGPTの開発と稼働には、ハイエンドAIサーバ“NVIDIA DGX H100”が3万基必要であるという(図6)。筆者は、この「3万基」という数字を見て、頭がクラクラしてしまった。

ちなみに、“NVIDIA DGX H100”には、1個4万米ドルに価格が高騰した「H100」が8個搭載され、システム全体の価格が46万米ドルであるという。ということは、ChatGPTレベルの生成AIには、3万基×46万米ドル=138億米ドル(1米ドル145円とすると約2兆円!)もの投資が必要である。

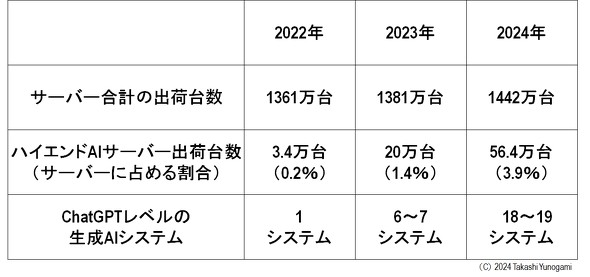

筆者は、世の中には生成AIシステムが溢れかえっていると思い込んでいたが、実際に、ChatGPTクラスの生成AIは、どのくらい構築された(またはされる)のだろうか?(図7)

図7 サーバの出荷台数、ハイエンドAIサーバの出荷台数および、ChatGPTレベルの生成AIシステム数[クリックで拡大] 出所:MICおよびDIGITIMES Research: Servers Report Database, 2024, ”Global annual server shipments, 2023-2024”を基に筆者作成

2022年に出荷されたハイエンドAIサーバは3.4万基であるから、ChatGPTクラスの生成AIは、1システムしか構築できなかった(これがまさにChatGPTである)。翌2023年にはハイエンドAIサーバが20万基出荷されたから、ChatGPTクラスの生成AIは6〜7システム構築可能だった。そして2024年にハイエンドAIサーバは56.4万台出荷される見込みだから、ChatGPTクラスの生成AIは18〜19システム構築可能になる。

ただし、上記の見積もりは、ChatGPTクラスの生成AIが、ハイエンドAIサーバ“NVIDIA DGX H100”3万基で構築できると仮定している。しかし、恐らく生成AIは次第に高性能化しているから、その場合は“NVIDIA DGX H100”が3万基より多く必要になっているかもしれない。以上から、米CSPが、現状のハイエンドAIサーバの出荷に満足しているとは到底考えられない。

それでは、米CSPなどのエンドユーザーが、それぞれ、何台のハイエンドAIサーバを保有しているかを見てみよう。

Copyright © ITmedia, Inc. All Rights Reserved.