ビジョンモデル+言語モデルをエッジで動作可能なアクセラレーター:EdgeCortixがSEMICON Japanでデモ(1/2 ページ)

EdgeCortixは「SEMICON Japan 2024」(2024年12月11〜13日、東京ビッグサイト)に出展。AI(人工知能)アクセラレーター「SAKURA-II」でビジョンモデルや言語モデルを動作させるデモや、チップレット集積型半導体として開発中のAI-RAN向け次世代プラットフォーム「SAKURA-X」の概要などを紹介した。

EdgeCortixは「SEMICON Japan 2024」(2024年12月11〜13日、東京ビッグサイト)で、最新のAI(人工知能)アクセラレーター「SAKURA-II」のデモや、チップレット集積型半導体として現在開発中の「SAKURA-X」のコンセプトなどを紹介した。

SAKURA-IIは、EdgeCortix独自のプロセッサアーキテクチャ「DNA(Dynamic Neural Accelerator)」技術を用いることで、高い電力効率を実現したプラットフォーム。INT8で最大60TOPS、BF16で30TFLOPSの演算性能を実現しつつ、消費電力はわずか8W(AIアクセラレーターチップの仕様)や10W(ボードの仕様)に抑えている。さらに、この低い消費電力で、Llama 2、Stable Diffusion、Vision Transformer(ViT)といった数十億のパラメーターを持つAIモデルをサポートする。

会場では、SAKURA-IIを搭載したPCで、Hugging Faceが開発したクラウド不要の言語モデル「SmolLM 2」を動かすデモを展示した。「組み込み機器のようなエッジ端末で、実際に言語モデルを動作させられることを示している。ロボットに言語で動作を指示するといった使い方ができるのではないか」(EdgeCortix担当者)

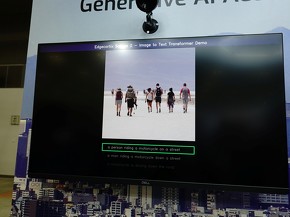

画像からテキストを生成するデモも披露した。ビジョンモデルのViTと言語モデル「GPT-2」を組み合わせたもので、画像からリアルタイムでキャプション(何が映っているかを端的に説明するテキスト)を生成している様子を展示した。「SAKURA-IIは、ビジョンモデルと言語モデルを組み合わせて動かすこともできる。生産ライン上で、カメラを使った不良検査などへの応用が期待できる」(EdgeCortix)

Copyright © ITmedia, Inc. All Rights Reserved.