AI半導体市場は「群雄割拠」の時代へ:NVIDIAはどう戦うのか(1/2 ページ)

AIで使われる高性能コンピュータチップ市場を独占しているNVIDIA。最近は、AIの各方面でライバルが登場し、NVIDIAの地位に迫ろうとしている。

NVIDIAは過去10年間にわたり、ML(機械学習)/AI分野で使われる高性能コンピュータチップ市場を独占してきた。

NVIDIAは、独自開発したCUDAソフトウェアや急速なイノベーションによる後押しを受け、AIプロセッサの代名詞となった。2025年における同社の市場価値は、一時的ながら5兆米ドル規模に達している。半導体チップやネットワーク接続など、AIの成長を支えるハードウェア関連の売上高は、2025年2月〜10月の期間で1478億米ドルに達したという。

NVIDIAの最新かつ最強のプロセッサである「Grace Blackwell」シリーズは、即座に完売してしまったが、その支配的な地位は弱体化しつつある。同社は現在、業界全体がより特殊なハードウェアへと移行していく中で、1社だけと競争するのではなく、さまざまな方面からの挑戦を受けている状況にある。

NVIDIAの強力な販売力と高い利益率は、主に、生産量が限られているという希少性によって実現されている。ハイエンドチップの主要なボトルネックは、TSMCのCoWoS(Chip-on-Wafer-on-Substrate)先進パッケージングの生産能力に限界があるという点だ。

NVIDIAは、この限られた生産能力の大半を利用しているが、半導体供給をめぐる競争は激化の一途をたどっている。唯一の製造メーカーであるTSMCは、2026年までに生産能力を月産ウエハー10万枚まで拡大する計画を立てている。供給の制約が緩和されれば、GoogleやAMDなどの企業が利益を享受することになるだろう。

業界は現在、大規模な基盤モデル(foundation models)での実験から、大規模かつ高コスト効率な推論を優先する方向へと移行しており、NVIDIAは重大なリスクに直面している。

大手クラウドプロバイダー各社は、NVIDIAの「CUDA」エコシステムへの依存から脱却しようとしている。運用コストが学習コストを上回ってしまう大量推論向けに、独自チップを開発するための投資を行っているのだ。

NVIDIAの大口顧客が「競合」に

北米の「ビッグ4」と呼ばれるハイパースケーラー企業であるGoogleとAmazon Web Services、Microsoft、Metaは、この分野において最大規模の資本支出を行っている。これら4社によるカスタムシリコンへの集団的な移行は、競争力を確保するための戦略的な動きだといえる。

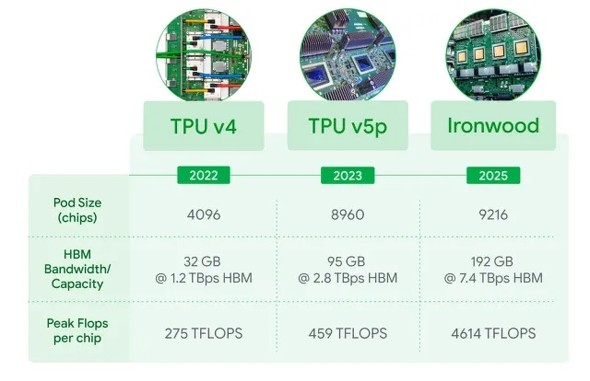

Alphabet傘下のGoogleは「Tensor Processing Unit(TPU)」によってカスタムAIチップへの移行を開始した。最新バージョンである第7世代TPU「Ironwood」は、推論向けに最適化されている。大量の共有メモリを搭載し、単独の「SuperPOD」で最大9216個のチップを接続可能なため、大規模なMoE(Mixture of Experts/混合エキスパート)モデルのメモリ制約に対応することができる。

Meta Platformsは、2027年から自社のデータセンター向けにGoogleのTPUチップをリースし、調達する可能性がある。これはGoogleが、商用チップのサプライヤーとしての位置付けへと転換していくことを示している。一部の予測によると、GoogleがNVIDIAの年間売上高全体の最大10%を奪い取り、その額は数十億米ドル規模に達する可能性があるという。

Amazon Web Services(AWS)は、NVIDIAの高額なチップの代替品を探している企業を引き付けるべく、価格性能のさらなる向上を追求している。AWSは「当社の『Trainium』チップは、GPUと比べて学習コストを最大50%削減でき、ミッドレンジのAIワークロードをターゲットに定めている」と主張する。

またAWSは、3nm世代のプロセス技術を適用したカスタムチップ「Graviton5」も拡充している。汎用タスクでは、前世代品と比べて最大25%の高性能化を実現するという。Anthropicなどのパートナー企業は、モデル学習向けにTrainium2を使用していて、AWSのTrainiumソフトウェアやソフトウェア開発キット(SDK)「Neuron」の価値を示している。

Metaは、特殊なアプローチを採用している。同社の「MTIA(Meta Training and Inference Accelerator)」は、FacebookやInstagram向けのレコメンデーションシステムのような、大量のタスク向けに設計されている。同社は、これらのタスクをカスタムチップにオフロードすることで、NVIDIA製H100を高度なAI研究のために確保しておくことができるのだ。

Microsoftのカスタムシリコンプログラムは、挫折に直面している。同社の次世代チップ「Maia(開発コード名:Braga)」は、2026年まで延期され、困難な状況にある。この遅延により、OpenAIの計算要件を満たすために、引き続きNVIDIAの高額なBlackwell GPUを調達しなければならなくなった。またMicrosoftは、コストを相殺するためにAMDのGPU「Instinct MI300X」も使用しており、AMDの最大顧客の1社となっている。

「NVIDIAの代替」を狙うAMD

大手クラウドメーカーが独自システムを開発する中、AMDは引き続き、幅広い市場でNVIDIAの主要な代替品としての位置付けを維持している。AMDのMI300Xチップは、NVIDIAのH100を大幅に上回る192GBのHBM3メモリを搭載しており、大規模モデル推論向けにコストを削減する上で最適だ。AMDの予測では、同社のデータセンターGPUの年間売上高は数十億米ドル規模に達し、NVIDIAと直接競合できるようになる見込みだという。

AMDにはかつて、ソフトウェアの制約があったが、今はOpenAIのTritonコンパイラでそれに対応できている。開発者はTritonを使うことで、CUDAやAMDの「ROCm」などに関する深い専門知識がなくても、NVIDIA製とAMD製の両方のハードウェアと互換性がある高性能なコードを書くことができる。

Tritonは、ハードウェアの互換性を高め、CUDAからの移行を簡素化する。このためコストが削減され、メーカー各社は代替サプライヤーを容易に採用できる。

Copyright © ITmedia, Inc. All Rights Reserved.