サーバをそのままオイルにどぼん PUE 1.03の液浸冷却技術:CES 2026 現地レポート

Quantum Meshは「CES 2026」のENEOSブースにて、コンテナ収容型液浸冷却システム「KAMUI(カムイ)」を展示した。サーバ自体をそのまま冷却液(オイル)に浸すもので、PUE(Power Usage Effectiveness)は1.03〜1.04を実現する。

分散型のエッジデータセンターの開発および運営を手掛けるQuantum Meshは「CES 2026」(2026年1月6〜9日、米国ネバダ州ラスベガス)のENEOSブースにて、商用のコンテナ収容型液浸冷却システム「KAMUI(カムイ)」を展示した。コンテナ収容型液浸冷却システムの商用化は「日本国内では初」(同社)だという。

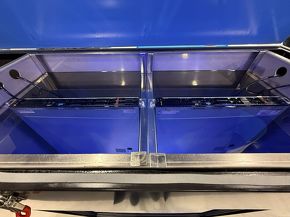

ENEOSのブースに展示した「KAMUI」の外観。左側が本体(コンテナ)で、そのサイズは高さ1200mm×幅1400mm。この1台で16Uまでのサーバを運用できる。展示用なので右側にチラーがあるが、実際の運用ではチラーは必要ない[クリックで拡大]

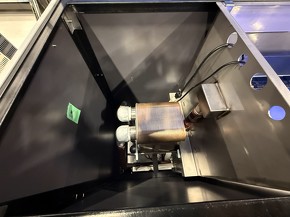

KAMUIはQuantum Meshが独自に開発した単相液浸冷却システムだ。サーバの熱で温まった冷却液(オイル)を、地下水を利用した熱交換によって冷却し、その冷却されたオイルでサーバを冷やし続ける。

具体的には、サーバそのものを冷却液に浸す。サーバの熱で温まった冷却液は、冷却槽のすぐ隣にある熱交換器により水で冷やされ、再びサーバの冷却に使われる。Quantum Meshによれば、冷却液は約55℃で冷却槽を出ていき、約25℃に冷やされて再び冷却槽に入ってくるという。温度が高い物体から低い物体へと熱を移動させる熱交換を用いて冷却するので、冷却に必要な消費電力を極めて低く抑えられることが特徴だ。同社は「データセンターの電力使用効率を示す指標であるPUE(Power Usage Effectiveness/1.0に近づくほどよい)は、現在の空冷方式は1.7〜1.8、導入がこれから本格化する水冷方式は1.4くらい。それに対し、KAMUIは1.03〜1.04を達成している」と語る。

KAMUIは、40kW/ラックの高密度ラックを安定して冷却できる能力を持つ。

冷却液にはENEOSの液浸冷却液「IXシリーズ Type J」を使用している。「IXシリーズ Type Jは絶縁系オイルで酸化しにくい。5〜10年に一度くらいの頻度で交換すればよい」(Quantum Mesh)

KAMUIは既存のサーバにも対応できるが、2点だけ変更が必要だ。ファンレスにすることと、SSD仕様にすることである。オイルに浸すので、ファンやHDDのように回転するようなメカニカルな機構があると不具合が起きてしまうからだ。

NVIDIA CEOは「水冷装置不要」とコメントも、液浸冷却には追い風

データセンターでは、現在主流の空冷方式が行き詰まりを迎えつつあるとQuantum Meshは説明する。効率よく冷却するためには、10℃や5℃といった低い温度の風が必要だが、日本では16℃以下の風だと結露を起こす。そのため風量を上げるしかないが、消費電力やGPUサーバの発熱量を考えると、それも限界に達しつつある。

そのため、次世代のデータセンター冷却技術として水冷方式の導入が始まっている。空冷方式よりもPUEが優れている一方で、冷却プレートを用いてプロセッサを間接的に冷やすため、冷却水を通す細い配管が必要で、水漏れが起きる可能性がある。工事も複雑で、水冷専用のラックも必要だ。その分コストも上がる。

さらに、CES 2026の開幕前となる2026年1月5日(米国時間)には、NVIDIA CEOのJensen Huang氏が次世代GPUである「NVIDIA Rubin」の仕様について講演。「温水で冷却できるので、データセンターには水冷装置が不要になる」と発言し、話題を呼んだ。

Quantum MeshはEE Times Japanの取材に対し「この動きは、将来的に新設されるハイパースケーラーのPUEを下げる可能性を示唆するものではあるが、大規模データセンターが必要とする電力そのものが減ることを意味するものではない」とコメントした。

「先進国では構造的に電力供給が不足している。さらに、データセンター用GPUの納品が現時点では十分に進んでおらず、データセンターの本格稼働は後ろ倒しになるであろうこと、DLC(Direct Liquid Cooling)などの水冷方式は、水漏れによるサーバ破壊のリスクが残ることなどから、KAMUIのような液浸冷却の需要は拡大する方向に働くとみている」(Quantum Mesh)

Quantum Meshは2023年に設立された企業だ。災害が多い上に、10MWクラス以上のデータセンター用電力の確保が難しい日本において、2MWクラスの高圧電力を確保できる立地に絞って、分散型エッジデータセンターを提供する戦略を取っている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AI普及の思わぬ弊害 データセンターの電力問題が深刻化

AI普及の思わぬ弊害 データセンターの電力問題が深刻化

AI(人工知能)の発展が進む上で、データセンターの電力消費量に対する懸念が増している。次世代パワー半導体の積極的な採用や、より効率の良いデータセンターアーキテクチャの採用をはじめ、早急な対策が必要になる。 6kW以上の電力パス保護が実現するデータセンター向けPMIC、TI

6kW以上の電力パス保護が実現するデータセンター向けPMIC、TI

Texas Instrumentsは、データセンター向けの新しいパワーマネジメントIC「TPS1685」を発表した。並列接続によって6kW以上の電力パス保護が行える。 次世代データセンターで期待される光電融合技術

次世代データセンターで期待される光電融合技術

データ消費量が増加の一途をたどるデータセンターでは、次世代の技術として、光電融合技術への注目度が高まっている。 データセンター省エネの要、光電気集積モジュールを京セラが披露

データセンター省エネの要、光電気集積モジュールを京セラが披露

京セラは、キオクシア、アイオーコアとともに「CEATEC 2025」で、次世代グリーンデータセンター向けの光電気集積モジュール「OPTINITY」を展示した。 データセンターを支える光伝送技術 〜データセンター間を相互接続する技術

データセンターを支える光伝送技術 〜データセンター間を相互接続する技術

近年、地理的に分散した複数個のデータセンターを接続するデータセンター間相互接続通信(DCI:Data Center Interconnect)が注目されている。今回は、そうした技術の幾つかを解説する。