「AIの進化」に追い付けない半導体開発 解決の道筋は:「最初に規模を拡張」に潜むわな(1/3 ページ)

2026年1月に欧州で開催された「HiPEAC 2026」カンファレンスでは、AIの進化と半導体の進化に大きなギャップが生まれつつあることに対する懸念が示された。カンファレンスではこうしたギャップを解消するソリューションの他、熟練エンジニア不足にAIで対応する方法についても議論が行われた。

過去10年間でAIの開発はかつてないほど加速し、モデルサイズは数百万から数兆パラメータに拡大している。

しかし、これらのモデルを実行するために必要な物理的ハードウェアの進化には、数週間ではなく数年単位の時間がかかる。この時間的な断絶は効率のギャップを拡大し、膨大なエネルギー消費と膨れ上がるコストがAI革命の経済的持続可能性を脅かしている。

2026年1月26〜28日にポーランドのクラクフで開催された「HiPEAC 2026」カンファレンスには、欧州全土からトップクラスのコンピュータアーキテクチャの研究者らが集結し、「“まず規模を拡張し、後で修正する”というアプローチではもはや、現在の需要に追い付けない」という見解で一致した。

カンファレンス最終日の基調講演で、イリノイ大学アーバナシャンペーン校(UIUC:University of Illinois Urbana-Champaign)のDeming Chen 教授は「コンピューティングの未来は新しいアルゴリズムだけでなく、ソフトウェア設計とハードウェア実行の障壁を打ち破ることにかかっている」と語った。

「最初に規模を拡張」の罠(わな)

AI開発は長年にわたり、分断されたプロセスをたどってきた。研究者らは、完璧なハードウェアを前提として、最高の精度を目指して大規模なニューラルネットワークを構築する。モデルが完成して初めて、ハードウェアエンジニアが実際のチップ上でそのモデルを動作させる方法を模索するというやり方だ。

Chen教授は「この一方向的なワークフローが重大な技術的負債を生んでいる」と主張する。同氏はHiPEACの聴衆に向けて「現代のハードウェアはヘテロジニアス(異種混在)で、消費電力、熱、製造上の厳しい制約がある」と指摘した。

ハードウェアを単なるバックグラウンドレイヤーと見なすと、AIシステムと実際にシリコンでできることに不一致が生じる。その結果、実際のコンピューティングよりもはるかに多くのエネルギーをデータの移動に消費することになるという問題が起こる。

Chen氏はHiPEAC 2026の聴衆に「トップダウンの最適化では、根本的にずれた設計上の決定を補うことはできない。われわれは、爆発的なコストとエネルギー消費に直面している。こうした傾向が続けば、大規模言語モデル(LLM)のトレーニングにかかるエネルギー消費量はすぐに、小国のエネルギー消費量を上回ることになる」と語った。

協調設計のソリューション

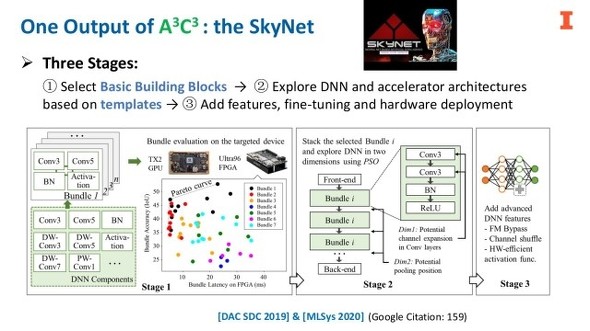

イリノイ大学の研究者らは「A3C3手法(AIアルゴリズムとアクセラレータの協調設計、共同探求、共同生成)」を提案している。この方法では、ハードウェアを固定された目標と見なすのではなく、数学を用いてニューラルネットワークとハードウェア設計の両方を同時に探求する。

Chen氏は、低消費電力のドローンの物体検出用に構築されたニューラルネットワーク「SkyNet」を例に挙げて説明した。同氏のチームは双方向探求を用いて、モデルとハードウェアを一対のペアとして構築した。SkyNetは、世界最大級の半導体設計会議「DAC(Design Automation Conference)」が主催する組み込み設計技術のコンテスト「DAC System Design Contest」において、他の100以上のエントリーを打ち負かし、「ResNet」のような人間が設計したモデルよりも優れた精度と速度を達成した。Chen氏は「これは、構成のみによる協調設計が、全体的な精度やエネルギー消費量、性能の観点から大きな飛躍を実現できるということを実証している」と説明する。

メモリの制約をどう解消するのか

協調設計が、特にLLMに必要であることは自明だ。LLMは、テキストを1トークンずつ生成するため、メモリによる制約がある。実際の計算よりも、モデルの重みをメモリからプロセッサに移動させる時間の方が長くなる場合が多い。

Chen氏のチームはこの問題に対応するため、LLMの設計を変更して複数の「ヘッド」を追加するシステム「Medusa」を開発した。これらのヘッドは、未来の複数のトークンを同時に予測する。そしてツリー構造をベースとした分析により、どの予測が正しいかを確定する。

Chen氏は「これは、メモリ限界のある連続したデコード処理を、計算集約型の並列処理に変えるものだ」と説明する。Medusaは、GPUの予備の演算能力を利用することにより、生成品質を落とすことなく、2倍以上の高速化を達成するという。

また同時に、同氏のチームは、会話履歴を保存するKV(Key Value)キャッシュの増大という問題にも取り組んでいる。コンテキストウィンドウが数百万トークンにも達していることから、このKVキャッシュがGPUメモリを圧迫する可能性がある。Chen氏は、アテンションパターンを観測し、モデルが実際に使用する重要なトークンのみを特定して保持するという、「SnapKV」技術を導入した。

Chen氏は「モデルは、メッセージの中で何が最も重要な情報なのかを理解しようとしている。SnapKVは、それほど重要ではないトークンを破棄することで、メモリフットプリントを約8分の1に縮小することが可能だ」と指摘する。

Copyright © ITmedia, Inc. All Rights Reserved.