ビッグデータのクラスタリング処理を汎用PCで実行:少ないメモリ容量で高速処理

一般的な処理能力のPCで、ビッグデータのクラスタリング処理を高速に実行できる手法を、情報・システム研究機構国立情報学研究所(NII)の松井勇佑氏らが開発した。

IoT時代のデータ処理に有用

情報・システム研究機構国立情報学研究所(NII)コンテンツ科学研究系特任研究員の松井勇佑氏、ドワンゴメディアヴィレッジ研究開発グループのグループリーダー大垣慶介氏、東京大学大学院情報理工学系研究科電子情報学専攻の相澤清晴教授と山崎俊彦准教授らの研究グループは2017年9月12日、一般的な処理能力のPCで、ビッグデータのクラスタリングを高速に実行できる手法を開発したと発表した。

人工知能(AI)などの研究では、膨大な画像データなどを高速に処理する必要がある。このため、収集した大量データの中から、類似したものをまとめてグループ化する「クラスタリング」の作業が必要となる。ところが、1億個を超えるような画像データを高速に処理する場合、これまでは多数のサーバによる分散並列処理を必要としていた。

そこで今回、CPUは4コアでメモリ容量が32Gバイト程度の一般的なPCでも、ビッグデータのクラスタリング処理を可能にする技術を開発した。開発した手法ではまず、直積量子化と呼ばれる技術を用いて、データを圧縮する。これによって、使用するメモリ容量を削減することができる。

次に、圧縮したデータの中から類似したデータをグループ化し、グループの平均を計算する。これらの処理を繰り返し行う。類似したデータのグループ化には、かねて松井氏が提案した技術を用いている。グループの平均を効率よく計算する技術は新たに考案した。

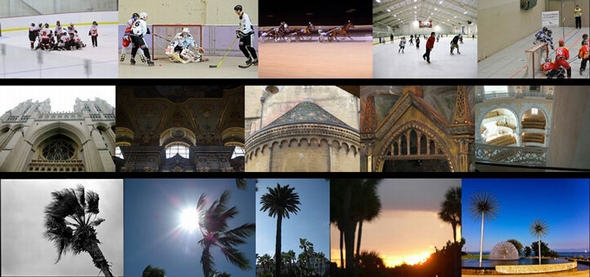

開発した手法を一般的なPCで用い、1億枚の画像データセット「Yahoo Flickr Creative Commons 100M(YFCC100M)」を対象に、クラスタリング処理を行った。「氷上のスポーツ試合」や「欧風の教会」「ヤシの木」など、10万種類のグループに分類する処理を、約1時間で実行することができたという。10億枚の画像データを10万種類のグループに分類する処理については約12時間で済んだ。

研究グループは、一般的なクラスタリング手法である「Binary k平均法」などとその特性を比較した。既存の手法は元データを不可逆的に変形するため、クラスタリング終了後に元データへ復元することはできない。これに対し開発した手法だと、データを近似的に復元することが可能である。さらに、開発した手法はチューニングなどの煩雑な設定は不要で、取り扱いが簡単だという。また、k平均法に比べて精度は劣るものの、処理速度は10〜1000倍も高速で、必要なメモリ容量は100分の1〜4000分の1で済むという。

IoT(モノのインターネット)のエッジデバイスでは、CPUコア数やメモリ容量などコンピュータ資源に限界がある。こうした中で、今回の開発成果を活用すると、エッジデバイス側でビッグデータのクラスタリング処理を行うことが可能になる。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ドリフト電流や拡散電流と異なる光電流を実証

ドリフト電流や拡散電流と異なる光電流を実証

理化学研究所(理研)などの共同研究グループが、p‐n接合において電界に比例するドリフト電流や、キャリア濃度差に比例する拡散電流とはメカニズムが大きく異なる光電流であるシフト電流の観測に成功した。 反強磁性体で巨大な異常ネルンスト効果を発見

反強磁性体で巨大な異常ネルンスト効果を発見

東京大学らの研究グループは、反強磁性体マンガン合金で、自発的な巨大熱起電力効果が現れることを発見した。素子構造が比較的単純で、集積化により高出力を実現することも可能となる。 印刷で薄くて柔らかいモーターを実現

印刷で薄くて柔らかいモーターを実現

東京大学の川原圭博准教授らの研究グループは、印刷技術を用いて、薄くて柔らかい軽量なモーターの作製に成功した。ソフトロボットへの応用などが期待される。 高容量で長寿命、リチウム−硫黄二次電池用電極

高容量で長寿命、リチウム−硫黄二次電池用電極

大阪府立大学の辰巳砂昌弘教授らは、高容量と長寿命を兼ね備えたリチウム−硫黄二次電池用正極の開発に成功した。エネルギー密度の高い次世代蓄電池の開発が可能となる。 Wi-RANで多段中継、多地点から同時に情報収集

Wi-RANで多段中継、多地点から同時に情報収集

京都大学の原田博司教授らは、広域系Wi-RAN(Wireless Regional Area Network)システム用の無線機を用いて、無線多段中継伝送による多地点同時映像情報収集の基礎試験に成功した。 京大ら、アンモニア燃料電池で1kW発電に成功

京大ら、アンモニア燃料電池で1kW発電に成功

京都大学らの研究グループは、アンモニアを直接燃料とした固体酸化物形燃料電池(SOFC)で、1kWの発電に成功した。アンモニア燃料電池の発電出力としては世界最大級となる。