「世界初」高速化&精度劣化監視の新AI技術:DXを支える富士通のテクノロジー(2/4 ページ)

富士通研究所は2019年10月25日、川崎市中原区の本社で行われた富士通の研究開発戦略説明会で、AI運用時の精度劣化を監視し、再学習なしに自動修復できる「High Durability Learning」と、AI処理を最大10倍高速化できる「Content-Aware Computing」という2つの新技術を発表した。同社によるといずれも世界初の技術という。

AI処理を最大10倍高速化、増大するAIニーズに対応

AI技術の進化と普及に伴い、AI処理の計算量は爆発的に増加している。同社によれば、AIの計算需要の変遷について、スーパーコンピュータ「京」の全系(8万ノード)を用いた場合の学習時間で見ると、2012年の「AlexNet」が50秒だったのに対し、2018年の「Alpha Go Zero」では約6カ月と、約30万倍まで増大しているという。

今後もこの計算量はさらに増大していく見込みであり、それに合わせてGPUや専用プロセッサにより計算性能も向上しているが、「計算需要の増大には追いついていない」という。

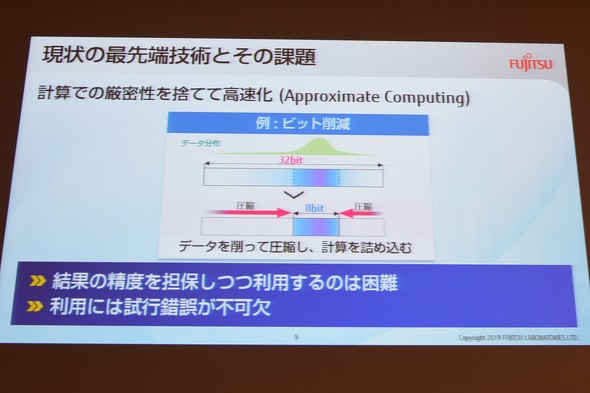

そうした背景から、現在、ニューラルネットワークの計算において32ビットの演算精度を8ビットに落とし並列演算をさせて高速化するなど、計算の厳密性を捨てて高速化する技術が注目されているが、一律に演算精度を落とせば演算結果も劣化するため、どの箇所の演算精度を落とし、どの箇所の演算精度を落とさないか、専門家が試行錯誤して演算精度の調整を行う必要がある。

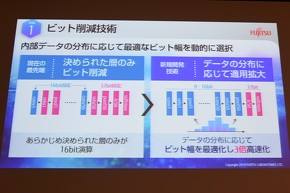

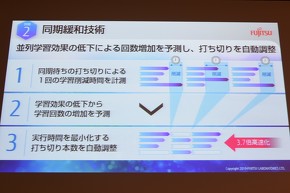

今回、同社が発表した「Content-Aware Computing」は、プログラム挙動を動的に分析する手法をとることで、こうした専門家の試行錯誤を自動化することに成功したという。具体的には、内部データの分布に応じて最適なビット幅を動的に選択する「ビット削減技術」と、並列学習効果の低下による回数増加を予測し、打ち切りを自動調整する「同期緩和技術」を用いている。

ビット削減技術については、従来の手法ではニューラルネットワークのうち、あらかじめ決められた層しか低ビット化できなかったが、この新技術では各層の学習データの分布に応じて低ビット化の適用を拡大できるといい、演算結果の劣化を抑えつつ、従来の3倍の高速化を実現するという。

同期緩和技術は、並列処理の各演算において、処理を打ち切った場合の処理時間の削減量と演算結果への影響度を予測し、演算結果を劣化させない範囲で処理時間を最大限に削減できるよう、各演算の打ち切り時間を自動で制御。こうして並列計算の高速実行を実現しており、ディープラーニングの処理では最大3.7倍の高速化を可能にしている。同社は、この2つの技術を適用することで、自動化による使いやすさにあわせ、「最大約10倍の性能を実現した」としている。Content-Aware Computingについても、2020年度中に実用化する方針としてる。

Copyright © ITmedia, Inc. All Rights Reserved.