史上最悪レベルの半導体不況に回復の兆し、生成AIという新たな“けん引役”も:湯之上隆のナノフォーカス(65)(4/5 ページ)

“コロナ特需”から一転、かつてないレベルの不況に突入した半導体業界だが、どうやら回復の兆しが見えてきたようだ。本稿では、半導体市場の統計や、大手メーカーの決算報告を基に、半導体市場の回復時期を探る。さらに、業界の新たなけん引役となりそうな生成AIについても言及する。

ChatGPT(生成AI)狂騒曲

2022年11月30日にオープンAIが公開したChatGPTが爆発的に世界に普及している。アクティブユーザー数1億人に到達するのにかかった時間は、Facebookが54カ月、X(旧twitter)が49カ月、Instagramが30カ月、LINEが19カ月、Tiktokが9カ月であるのに対して、ChatGPTはわずか2カ月だったという。

その性能も急速に向上しており、2023年1月にMBA最終試験に対する回答がB(合格レベル)評価になり、同年2月に米医師資格試験に対する正答率が合格ラインに到達し、同年3月にGPT-4が米司法試験に対する回答が上位10%のスコアを獲得し、過去5年分の日本の医師国家試験に合格するレベルになったという。

ChatGPTに端を発した生成AIブームはとどまるところを知らず、その後も、ハイテク企業各社が続々と生成AI開発に乗り出している。そして、米NVIDIAのGPUが独占しているAI半導体市場に対して、AMDやIntelをはじめ、Google、Amazon、Metaなどのクラウド大手も専用のAI半導体の開発を始めた。

ここで、そもそも生成AIとは何か、どのような原理で動作しているかを以下で説明する(筆者もよく分かっていなかったのでにわか勉強しました)。

生成AIのステップは2段階

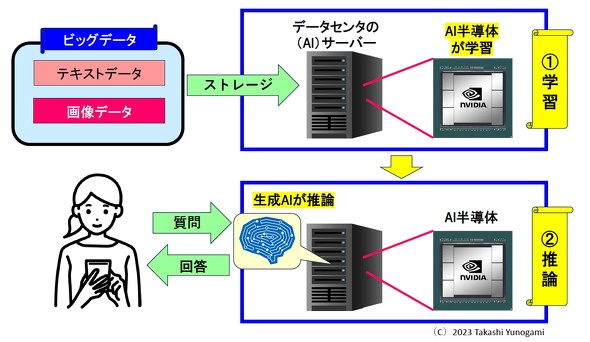

図12を用いて、ChatGPTなどの生成AIの仕組みを説明する。生成AIのステップは、1)学習と2)推論の2段階に分けられる。

まず、テキストデータや画像データなど、インターネット上のビッグデータをAIサーバに読み込ませる。その際、NVIDIAのGPUなどのAI半導体がそのデータを学習する。

次に、ユーザーが質問を書き込むと、AIサーバ上で動作する生成AIが推論を行って回答する。その際、AIサーバ上で推論を行っているのは、やはりNVIDIAのGPUなどのAI半導体である。

ここから分かることは、生成AIとは、AIサーバに搭載されている、(NVIDIAのGPUなどの)AI半導体上で動作する「ソフトウェアのようなもの」と言えるだろう。

NVIDIAのGPUが引っ張りだこ

生成AIが動作するのはAIサーバ上である。サーバというからには、DRAMやNANDが大量に必要になるだろう。その上、AI半導体が必須になるのは当然であり、その市場をNVIDIAがほぼ独占している。そして、NVIDIAがリリースしているGPUの「A100」と「H100」は、驚くべきチップである。

- A100:TSMCの7nm、チップサイズ826mm2、540億トランジスタ、1個1万米ドル

- H100:TSMCの4nm、チップサイズ814mm2、800億トランジスタ、1個4万米ドル

「A100」も「H100」も、チップサイズが800mm2を超えるモンスターチップで、1個1万〜4万米ドルもする。そして、生成AIの開発や運用には、GPUが数千〜数万個必要になるという。

実際に、OpenAIが2.5万個、Metaが2.1万個、Teslaが7000個、それぞれ「A100」を保有しているという記事がある(細谷元、『生成AIでGPU不足深刻化、NVIDIA新投入のGH200とは? メタやテスラが抱える驚きのGPU数』、2023年8月19日)。

この記事によれば、OpenAIがことし(2023年)7月に商標登録を行った「GPT-5」には、3〜5万個の「H100」が必要とTeslaのElon Musk氏が推測したことが書かれている。

さらに、ことし50万個出荷される予定の「H100」は受注残が積みあがっており、来年2024年には150〜200万個出荷される(しなければならない?)という予測がある。しかし、そう簡単に出荷個数を増やせるかどうかは分からない。それはなぜか?

Copyright © ITmedia, Inc. All Rights Reserved.