NVIDIAの「GPU祭り」はまだ序章? 生成AIブームは止まらない:湯之上隆のナノフォーカス(76)(4/5 ページ)

NVIDIA製GPUの需要が高まる“GPU祭り”は、今後どうなっていくのだろうか。本稿では、AI(人工知能)サーバの出荷台数のデータを読み解きながら、NVIDIAの“GPU祭り”の行く末を予想する。

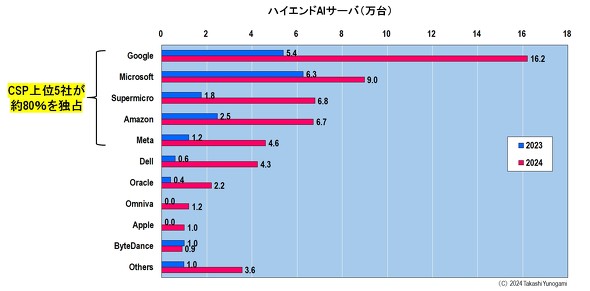

エンドユーザー別のハイエンドAIサーバ台数

図8に、エンドユーザー別のハイエンドAIサーバ台数を示す。2023年は、OpenAI社を傘下に持つMicrosoftが6.3万台で最多だったが、2024年になるとGoogleがMicrosoftを抜いて最多のハイエンドAIサーバを保有するようになった。

図8 エンドユーザー別のハイエンドAIサーバ(2023〜2024年)[クリックで拡大] 出所:DIGITIMES Research: Servers Report Database, 2024, ”Global annual server shipments, 2023-2024”

2024年のトップ5は、1位がGoogleの16.2万台(5システム)、2位がMicrosoftの9万台(3システム)、3位がSupermicroの6.8万台(2システム)、4位がAmazonの6.7万台(2システム)、5位がMetaの4.6万台(1システム)となっている(なおカッコ内はChatGPTクラスの生成AIが構築可能なシステム数である)。ここから、米CSPの上位5社が、全体の約80%を独占していることが分かる。

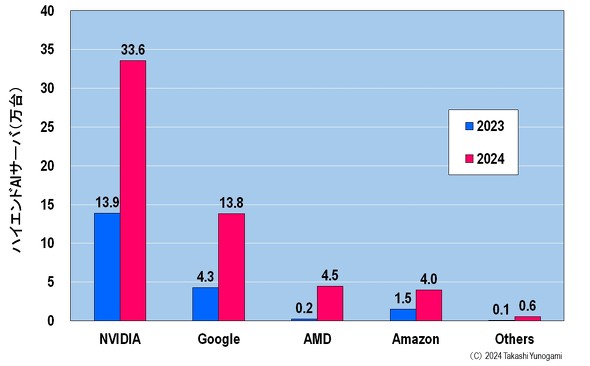

今度は、AIアクセラレーター別のハイエンドAIサーバの出荷台数を見てみよう(図9)、予想通り、NVIDIAのGPUがAIアクセラレーターに最もたくさん使われており、2024年には33.6万台だった。しかし驚いたのは、2番目に多かったのが、米AMDではなく、Googleだということである。

図9 AIアクセラレーター別のハイエンドAIサーバ(2023〜2024年)[クリックで拡大] 出所:DIGITIMES Research: Servers Report Database, 2024, ”Global annual server shipments, 2023-2024”

Googleは、AIアクセラレーターとして、Tensor Processing Unit(TPU)を自社開発した。そのTPUが搭載されているハイエンドAIサーバが、2024年に13.8万台となっている。ここで、図8から、2024年にGoogleは16.2万台のハイエンドAIサーバを保有していることが分かっている。従って、その内訳は、Google自社開発のTPU搭載が13.8万台、残り2.4万台がNVIDIAのGPU搭載と推察される。つまり、NVIDIAにとってみると、Googleはカスタマーでもあり、強敵でもある。

加えて、再度2024年の出荷台数を見ると、3位のAMDの4.5万台に、4位のAmazonが4万台と肉薄している。Amazonも、AIアクセラレーターとして、AWS Trainiumを開発している。うかうかしていると、AMDはAmazonにも抜かれてしまうかもしれない。

以上から、今のところNVIDIAは最多のAIアクセラレーターを出荷しているが、その強敵として、GoogleとAmazonが浮上してきている。NVIDIAのライバルは、プロセッサメーカーのAMDではなく(もちろん危機にひんしているIntelでもなく)、米CSPのGoogleやAmazonだということである。

Copyright © ITmedia, Inc. All Rights Reserved.