ディープラーニングの学習で「世界最高速度」実現:1カ月かかる処理を1日で

富士通研究所は2016年8月9日、スーパーコンピュータのソフトウェア並列化技術を応用し、複数のGPUを用いてディープラーニングの学習速度を高速化するソフトウェア技術を開発したと発表した。

「世界最高速度を達成」

富士通研究所は2016年8月9日、スーパーコンピュータのソフトウェア並列化技術を応用し、複数のGPUを用いてディープラーニングの学習速度を高速化するソフトウェア技術を開発したと発表した。同技術をオープンソフトウェアの「Caffe」に適用し、画像認識用多層ニューラルネットの1つである「AlexNet」を用いて評価したところ、GPU1台の学習速度に対して16台で14.7倍、64台では27倍を実現。同技術適用前と比べて、GPU16台で46%、64台で71%の学習速度の向上を実現している。

これにより、コンピュータ1台では約1カ月かかる学習処理を、GPUを64台並列動作させることで、1日程度で処理することが可能になったという。2016年8月5日時点での、富士通研究所による調べでは、「世界最高速度を達成した」としている。

2つの開発技術を適用

ディープラーニングの高速化手法は従来、GPUを搭載したコンピュータをネットワークで結合した並列化では、10数台を超えてしまうとデータ共有時間が増加するため、次第に並列化の効果が得られにくくなることが課題だった。

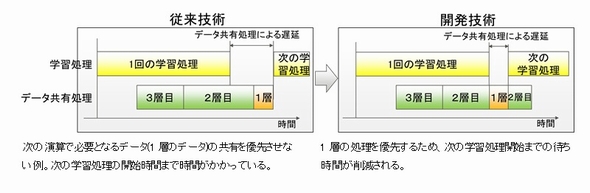

富士通研究所は今回、2つの技術を開発した。1つ目は、データ共有のスケジューリング技術だ。連続的に続く複数の演算で、次の学習処理の開始に必要となるデータが先に、それぞれのコンピュータで共有されるように転送の優先順序を自動的に制御する。

従来技術では、次の学習処理の初めに必要となる1層のデータ共有処理が最後に行われるため、データ共有処理が最後に行われるため、遅延が長くなってしまう。今回の開発技術では、2層目のデータ共有処理途中に1層目のデータ共有処理を行うことで、次の学習処理の開始までの待ち時間を短縮できたとする。

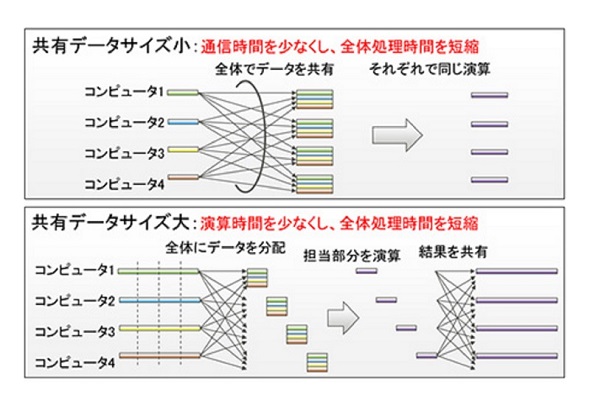

2つ目は、データサイズに応じた演算最適化処理技術だ。元となるデータ量が少ないときは、各コンピュータでデータを共有して同じ演算を実行し、結果を転送する時間を削減する。データ量が多いときは処理を分割し、他のコンピュータと算出した結果を共有して、後の演算で利用する。データの量に応じて最適な演算方法を行うように自動で振り分けることによって、全体の演算時間を最小にしている。

富士通のAI技術として実用化へ

富士通研究所では今後、今回開発した技術を富士通のAI技術「Human Centric AI Zinrai(ジンライ)」の1つとして、2016年度中の実用化を目指すとした。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIで働く人々は幸福になれるのか

AIで働く人々は幸福になれるのか

日立製作所は2016年6月、AI技術を活用し、働く人の幸福感向上に有効なアドバイスを、各個人の行動データから自動で作成する技術を発表した。今回の発表に伴い、ソーシャルメディア上では、AIに対する期待と不安の声が混じっている。AIは私たちの幸福感を高めてくれるのだろうか。そこで、このAIを活用した技術を開発した日立製作所の矢野和男氏にインタビューを行った。 GoogleからAI用プロセッサ「TPU」が登場

GoogleからAI用プロセッサ「TPU」が登場

Googleが、人工知能(AI)に向けたアクセラレータチップ「Tensor Processing Unit(TPU)」を独自開発したことを明らかにした。同社が2015年にリリースした、オープンソースのアルゴリズム「TensorFlow」に対応するという。 オムロンがAI搭載センサーを発表、自動運転に適用へ

オムロンがAI搭載センサーを発表、自動運転に適用へ

オムロンは、顔画像センシングと時系列ディープラーニングを組み合わせた「ドライバー運転集中度センシング技術」を搭載したセンサーを発表した。2019〜2020年発売の自動車へ搭載を目指す。 NEDOが人工知能技術の進展予測を公表

NEDOが人工知能技術の進展予測を公表

NEDOは2016年4月21日、人工知能技術の進展予測と、産業界に与える効果をまとめた「次世代人工知能技術社会実装ビジョン」を公表した。 日本は「子どもの人工知能」で世界と戦え

日本は「子どもの人工知能」で世界と戦え

人工知能(AI)に関わる研究者らは2016年4月、東京都内で「これからの技術開発の方向」についてパネルディスカッションを行った。本記事では、その議論の一部を紹介する。 インダストリー4.0の課題は人工知能で解決

インダストリー4.0の課題は人工知能で解決

センサーを利用した装置のモニタリングでは、膨大な量のデータが生成され、既にネットワークをひっ迫している。ルネサス エレクトロニクスは、同社の産業機器向け高速データ処理/通信エンジンである「R-IN」と人工知能を組み合わせ、それをエッジデバイス(工場の装置や機器)に搭載することで、この課題を解決しようとしている。