機械学習の時間を100分の1へ、インテルAIの戦略:Nervanaプラットフォーム(2/2 ページ)

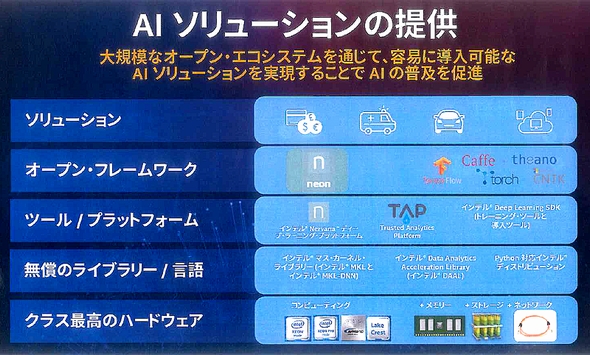

インテルは2016年12月9日、米国で開催した人工知能(AI)に関するイベント「AI Day」で発表した内容をもとに、AI事業に向けた戦略について説明会を開催した。2016年8月に買収したNervana Systemsの技術をベースとしたAI製品群を展開し、2020年にマシンラーニング(機械学習)における時間を現行の最速ソリューションと比較して100分の1に短縮することを目指す。

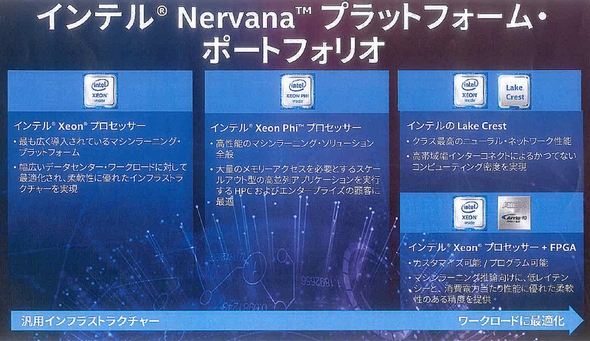

Nervanaプラットフォームとは

Nervanaプラットフォームは、インテルが2016年8月に買収したNervana Systemsの技術をベースとしたAI製品群を指す。「Xeon」や「Xeon Phi」プロセッサ、アクセラレーターとしてのFPGA、Nervana Systemsの技術を用いた製品が含まれる。

根岸氏によると、AIのワークロードを実行するデータセンターのサーバで、97%にインテルプロセッサが搭載されている。その中で、最も広く導入されているマシンラーニングプラットフォームとして挙げるのが、Xeonプロセッサである。Xeonプロセッサでは、2017年に「Apache Spark」の性能を18倍向上した「Skylake」を投入する。

Xeon Phiは、Xeonと比較してより学習時間の短縮に焦点を当てたプロセッサとなっている。最大400Gバイトのダイレクトメモリアクセスが可能で、根岸氏は「現行品(開発コード名:Knights Landing)で32ノードでスケーリングした場合、31倍のマシンラーニング時間の高速化を実現できている」と語る。2017年には、Knights Landingに対して4倍の性能向上を実現した「Knights Mill」を投入する予定だ。

また、Intel FPGA(旧Altera)の「Arria10」をプロセッサと組み合わせて高並列な実装をすることで、電力効率に優れた推論を実現できるという。FPGAは回路設計できる技術者が限られるが、IPのビルディングブロックを提供することで対応する。

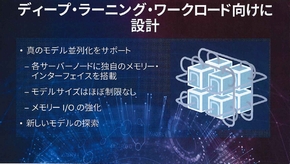

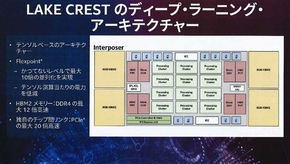

Nervana Systemsの技術をベースとしたASIC「Lake Crest」は、学習時間の短縮を追求した設計となっている。計算処理を行うProcessing Cluster、計32GバイトのHBM2メモリ、外側に独自の通信機能などを配置(上記ブロック図を参照)。最大10倍の並列化を実現できるとしており、2017年上期から一部顧客に提供を開始する。

機械学習にかかる時間を100分の1へ

ディープラーニングの学習には、GPUが多く活用されている印象がある。根岸氏も「最初は、AIのワークフローにプロセッサは向いていないといわれていた」と言及する。しかし、Xeon Phiで行った実験では6カ月未満のソフトウェア最適化により、最大400倍のパフォーマンス向上を実現。「ハードウェアの特長は、ソフトウェアをどれだけ最適化できることに依存することが分かった。つまり、AIにプロセッサが向いていないのではなく、単に今まで最適化されていなかっただけなのだ」(根岸氏)と語る。

インテルではLake Crestの次世代品として、数年の間に「Knights Crest」を展開予定。Knights Crestの詳細は明かせないとしたが、これらのAI製品群により、2020年までにマシンラーニングの時間を現行の100分の1に短縮することを目指すとした。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

沈黙する人工知能 〜なぜAIは米大統領選の予測に使われなかったのか

沈黙する人工知能 〜なぜAIは米大統領選の予測に使われなかったのか

世界中が固唾をのんで、その行方を見守った、2016年11月8日の米国大統領選挙。私は、大統領選の予測こそ、人工知能(AI)を使い倒し、その性能をアピールする絶好の機会だとみていたのですが、果たしてAIを手掛けるメーカーや研究所は沈黙を決め込んだままでした。なぜか――。クリントンvsトランプの大統領選の投票を1兆回、シミュレーションしてみた結果、その答えが見えてきました。 AIで働く人々は幸福になれるのか

AIで働く人々は幸福になれるのか

日立製作所は2016年6月、AI技術を活用し、働く人の幸福感向上に有効なアドバイスを、各個人の行動データから自動で作成する技術を発表した。今回の発表に伴い、ソーシャルメディア上では、AIに対する期待と不安の声が混じっている。AIは私たちの幸福感を高めてくれるのだろうか。そこで、このAIを活用した技術を開発した日立製作所の矢野和男氏にインタビューを行った。 困惑する人工知能 〜1秒間の演算の説明に100年かかる!?

困惑する人工知能 〜1秒間の演算の説明に100年かかる!?

コンピュータは、入力値から出力値に至る演算のプロセスを、順番通りに説明できます。ところが、「なぜ、その結果になったのか」と尋ねると、途端に説明できなくなってしまいます。困惑し、黙りこくったり、自分が行った演算を“言い訳”のごとく延々と説明したりと、迷走を始めるのです。 インダストリー4.0の課題は人工知能で解決

インダストリー4.0の課題は人工知能で解決

センサーを利用した装置のモニタリングでは、膨大な量のデータが生成され、既にネットワークをひっ迫している。ルネサス エレクトロニクスは、同社の産業機器向け高速データ処理/通信エンジンである「R-IN」と人工知能を組み合わせ、それをエッジデバイス(工場の装置や機器)に搭載することで、この課題を解決しようとしている。 NEDOが人工知能技術の進展予測を公表

NEDOが人工知能技術の進展予測を公表

NEDOは2016年4月21日、人工知能技術の進展予測と、産業界に与える効果をまとめた「次世代人工知能技術社会実装ビジョン」を公表した。 日本は「子どもの人工知能」で世界と戦え

日本は「子どもの人工知能」で世界と戦え

人工知能(AI)に関わる研究者らは2016年4月、東京都内で「これからの技術開発の方向」についてパネルディスカッションを行った。本記事では、その議論の一部を紹介する。