組み込みに特化した商用の深層学習フレームワーク:CPUでも高速に推論処理

ディープインサイトは、「Embedded Technology 2017(ET2017)/IoT Technology 2017」で、組み込み機器に特化した商用の深層学習フレームワークを使い、CPUで高速に推論処理を実行するデモを行った。

CPUで推論を実行できる

ディープインサイトは2017年11月15日から17日までの会期で開催されている展示会「Embedded Technology 2017(ET2017)/IoT Technology 2017」(会場:パシフィコ横浜)で、IntelのCPUを搭載した組み込み機器で、ディープラーニングの推論処理を高速に実行するデモを披露した。ディープインサイトが開発したディープラーニングフレームワーク「KAIBER(カイバー)」の推論実行エンジンと、Intelの数値演算ライブラリ「Intel MKL」、並列化のライブラリ「OpenMP」を用いることで、組み込み機器での推論処理を高速化できたという。

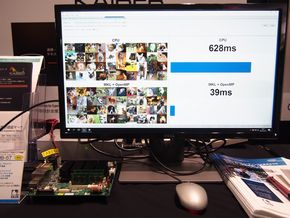

デモでは、イヌとネコの判定を行う際の処理時間を示した。同じCPUを使って推論処理を実行する場合に比べて、Intel MKLとOpenMPも使うと15〜20倍、高速化できている。

左=「KAIBER」の推論実行エンジンを使い、組み込み機器で推論処理を行っているデモ。CPUのみだと628ミリ秒かかる処理が、Intel MKLとOpenMPも使うことで39ミリ秒にまで高速化されている/右=デモで使用したIntelの「Atom」プロセッサを搭載した組み込みボード(クリックで拡大)

左=「KAIBER」の推論実行エンジンを使い、組み込み機器で推論処理を行っているデモ。CPUのみだと628ミリ秒かかる処理が、Intel MKLとOpenMPも使うことで39ミリ秒にまで高速化されている/右=デモで使用したIntelの「Atom」プロセッサを搭載した組み込みボード(クリックで拡大)IoT(モノのインターネット)機器で取得したデータを、よりリアルタイムで処理するための方法の1つとして、組み込み機器にディープラーニング(深層学習)を実装しようとする動きが始まっている。現在、ディープラーニングはGPUによって処理する方法が一般的だが、コストや消費電力に制約の多い組み込み機器では、IntelやARMコアのCPUのみを搭載していて、GPUを利用できないことも多い。そのため、CPUのみでディープラーニングの推論を高速に処理したいというニーズが高まっている。

ディープインサイトは、こうした背景からKAIBERを開発した。

KAIBERの最大の特長は、オープンソースではなく、商用のフレームワークだということだ。ディープラーニングのフレームワークには「Caffe」やGoogleの「TensorFlow」、PFN(Preferred Networks)の「Chainer」などがあるが、これらはいずれもオープンソースである。ディープインサイトの社長を務める久保田良則氏は、「オープンソースを使うと、機器を商用化した後のサポートを得られない。その点、KAIBERは商用フレームワークなので、しっかりとサポートできる」と強調する。

KAIBERは、サーバで行う学習機能と、組み込み機器に搭載する推論実行エンジンで構成されているが、このどちらも商用なので、サポート体制が整っている。フレームワーク全体はJavaで開発されていて、推論実行モジュールはC言語を用意している。

久保田氏は「GPUを使わなくても、IoT機器で推論処理を実行できるというのは大きい」と述べる。現在は推論のみを組み込みボードで実行しているが、将来的には、より高性能なCPUを使い、推論だけでなく学習もボードで実行することを目指しているという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

深層学習のコアライブラリー、ソニーが無償公開

深層学習のコアライブラリー、ソニーが無償公開

ソニーは、ディープラーニング(深層学習)のプログラムを生成するためのソフトウェアであるコアライブラリー「Neural Network Libraries」を無償で公開した。 パナとNVIDIA、ディープラーニングで連携

パナとNVIDIA、ディープラーニングで連携

パナソニック ソリューションテクノロジーは、「第6回 IoT/M2M展【春】」で、NVIDIA製AIスーパーコンピュータ「DGX-1」とGPU「Tesla P100」および、AIスーパーコンピュータを搭載した自動運転の事例などを紹介した。 モノマネする人工知能 〜 自動翻訳を支える影の立役者

モノマネする人工知能 〜 自動翻訳を支える影の立役者

最近の機械翻訳の発展には目を見張るものがあります。なぜ、ここまで進化しているのでしょうか。AI(人工知能)による翻訳、通訳を取り上げ、その発展の理由を探ってみると、その根底には、あるパラダイムシフトが存在していたことが分かりました。 機械学習を活用する将来の半導体設計

機械学習を活用する将来の半導体設計

次世代チップ関連の会議「ISPD」(2017年3月19〜22日、現地時間)では、「機械学習は、チップの設計において“人間の仕事”を減らす方向に向かっている」との見解が示された。 機械学習の時間を100分の1へ、インテルAIの戦略

機械学習の時間を100分の1へ、インテルAIの戦略

インテルは2016年12月9日、米国で開催した人工知能(AI)に関するイベント「AI Day」で発表した内容をもとに、AI事業に向けた戦略について説明会を開催した。2016年8月に買収したNervana Systemsの技術をベースとしたAI製品群を展開し、2020年にマシンラーニング(機械学習)における時間を現行の最速ソリューションと比較して100分の1に短縮することを目指す。 Xilinx、エッジ〜クラウドの機械学習に対応

Xilinx、エッジ〜クラウドの機械学習に対応

Xilinx(ザイリンクス)は、応答性に優れたビジョンシステムを極めて短い期間で開発することが可能となる「reVISIONスタック」を発表した。エッジからクラウドまで広範な機械学習(マシンラーニング)の処理を行うアクセラレーションプラットフォームを迅速に開発することができる。