データセンターを支える光伝送技術 〜データセンター間を相互接続する技術:光伝送技術を知る(6)(3/3 ページ)

近年、地理的に分散した複数個のデータセンターを接続するデータセンター間相互接続通信(DCI:Data Center Interconnect)が注目されている。今回は、そうした技術の幾つかを解説する。

リージョナル・データセンター間相互接続に使用される光トランシーバー

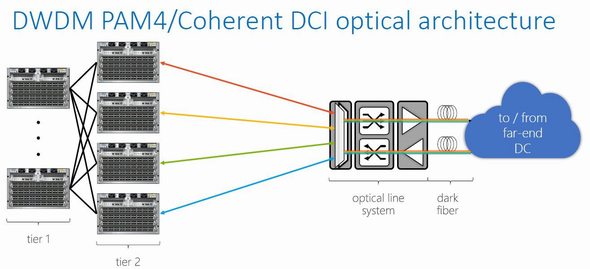

図4にMicrosoftのDCIの構成を示す。Tear1はLeaf、Tear2はSpineスイッチに相当する。リージョナル・データセンター間接続では、Spineスイッチのソケットに、波長多重可能な80km伝送の光トランシーバーを直接挿入する。Spineから出た光信号はそのまま光多重して伝送され、波長分離して送信先データセンターのSpineで受信される。

この東西トラフィック接続はRegion内データセンター群のLeaf/Spineスイッチネットワークの部分ネットワークである。このため、その伝送速度はLeaf/Spineと同じである。データセンターのスイッチネットワークの伝送速度が100GbE(ギガビットイーサネット)の場合、DCIも100GbEである。さらに、経済性やメンテナンス性などからデータセンター内のスイッチと同一の光トランシーバー形式(Form Factor)が要求されている。

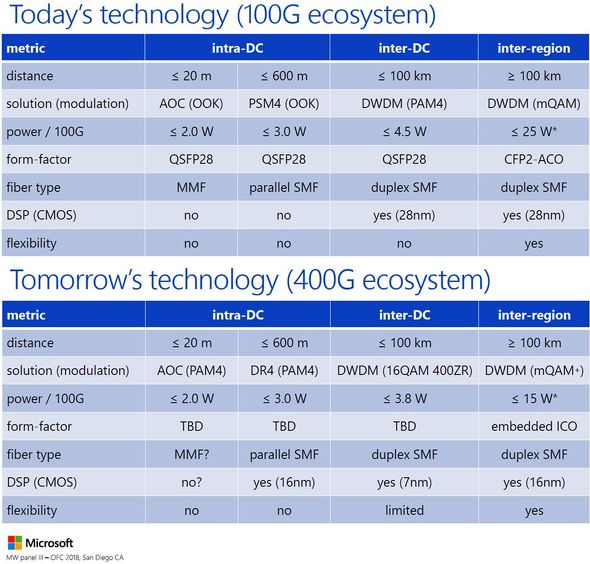

Microsoftでの例を図5に示す。Region内のデータセンターの接続は「inter-DC」と表記されている。図5で示されているように、「100G ecosystem」と100GbEでデータ伝送速度が統一されているだけでなく、光トランシーバのモジュール形式(Form Factor)はデータセンター内(intra-DC)の光トランシーバと同じ親指サイズのQSFP28で統一されている。接続距離によって方式(「Modulation」)は異なるがRegion内の光トランシーバのソケットを統一したのが特徴である。このことによりスイッチ間の距離に応じたQSFP28光トランシーバを挿入できる。

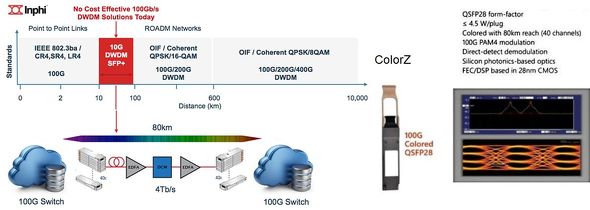

現在の100GbEにおいて、Microsoftは米国InphiのColorZを使用しているといわれる。図6に示したInPhiの資料によれば、100Gbpsでは、100km以上の長距離ではデジタルコヒーレント方式が主流だが、消費電力が大きいため小型化が困難である。

ColorZでは、少し波長をずらした2本の50Gbps PAM4光信号をセットで100GbEとし、波長多重の標準の一つである100GHzの波長間隔に詰める。図6によれば、40チャネルの100GHz間隔の波長多重を利用し、1本のファイバーで4Tbpsで伝送できる。

50Gbps PAM4はIEEE 400GbE-LR8/FR8にも採用されている、振幅変調・直接検波(IMDD)という、低消費電力で小型化が可能な方式の一つである。図6右下にあるように、1スロットに4つのレベルを持ち、周波数帯域またはBaud Rateがビットレートの半分である。50Gbps PAM4は25GBaud信号であり、これを80km伝送するにはDSPでの信号処理が必須だ。

ちなみに、Region間は100kmを超える距離なので、デジタルコヒーレント受信技術が用いられている。図5の表内にある「CFP2」とは、名刺サイズのモジュール形式(Form Factor)を指し、伝送装置やルーターなどで使用されている。「ACO」は、送受信の光デバイスとその駆動回路や受信回路ICを搭載し、インタフェースがアナログ信号である(ACO: Analogue Coherent Optics)コヒーレント通信用トランシーバーモジュールであり、送受信DSPはボード上に置かれている。

こうして、20mから100km超まで、データセンター全体が100GbEのデータレートで接続されている。

図5を見ると、Microsoftの次世代(Tomorrow's technology)は「400G ecosystem」と示されている。この表では、Region内(<100km)では伝送方式(「modulation」)が決まっている。DCI、すなわち「Inter-DC」は、400GZRというOIF(Optical Internetworking Forum)において議論されているコヒーレント受信方式のDP-16QAMという方式である。

モジュール形式(form factor)は、intra-とinter-DCは同一であることが求められるが未定、つまり「TBD(To Be Defined)」だ。400GbEではQSFP56-DDとOSFPが候補となっている。両方とも19インチの標準スイッチシャシーにおいて32ポート搭載可能である。OSFPは許容消費電力が大きい。一方、QSFP-DDは40GbEのQSFP+と100GbEのQSFP28とダウンコンパチであり、有力だが消費電力が大きい400GZRを収容できるかが不明である。

400GbEリージョナルDCIでは、データセンター内と同一の情報容量とモジュール形式が要求されるため高い技術の開発が必要である。デバイスとしてはSi-photonicsとInP Photonic Integrated Circuit(PIC)が有力視されている。DSPとしては低消費電力化から7nm CMOSプロセスが適用される予定である。

筆者プロフィール

高井 厚志(たかい あつし)

30年以上にわたり、さまざまな光伝送デバイス・モジュールの研究開発などに携わる。光通信分野において、研究、設計、開発、製造、マーケティング、事業戦略に従事した他、事業部長やCTO(最高技術責任者)にも就任。多くの経験とスキルを積み重ねてきた。

日立製作所から米Opnext(オプネクスト)に異動。さらに、Opnextと米Oclaro(オクラロ)の買収合併により、Oclaroに移る。Opnext/Oclaro時代はシリコンバレーに駐在し、エキサイティングな毎日を楽しんだ。

さらに、その時々の日米欧中の先端企業と協働および共創で、新製品の開発や新市場の開拓を行ってきた。関連分野のさまざまな学会や標準化にも幅広く貢献。現在はコンサルタントとして活動中である。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

データセンターを支える光伝送技術 〜エッジデータセンター編

データセンターを支える光伝送技術 〜エッジデータセンター編

今回は、データセンターの新しいトレンドとして注目されている「エッジデータセンター」について解説する。 データセンターを支える光伝送技術 〜ハイパースケールデータセンター編

データセンターを支える光伝送技術 〜ハイパースケールデータセンター編

今回は、エンタープライズデータセンターに続き、GoogleやFacebook、Appleなどが抱える巨大なデータセンター、「ハイパースケールデータセンター」について解説する。 データセンターを支える光伝送技術 〜エンタープライズデータセンター編

データセンターを支える光伝送技術 〜エンタープライズデータセンター編

現代において、最も重要な社会インフラの一つともいえるのがデータセンターだ。データセンターには光伝送技術が欠かせない。今回は、データセンターに使われる光伝送技術について、エンタープライズデータセンターやハイパースケールデータセンターを取り上げて、解説していく。 大規模データセンターをめぐる競争が激化

大規模データセンターをめぐる競争が激化

Web大手各社は、これまでにない大規模な分散コンピュータネットワークの構築をめぐり、「ムーアの法則」のごとく、競争の中に置かれているような状態にある。コンピュータサイエンスの歴史書に新たな章が書き加えられようとしているところだが、その動きがどこに向かっているのかは不明だ。 Xilinx、データセンター事業でエコシステム拡大に注力

Xilinx、データセンター事業でエコシステム拡大に注力

ザイリンクスは2019年3月19日、同社のデータセンター事業戦略について講演やセッションを行うイベント「Xilinx Data Center Acceleration Seminar」を開催した。 メモリ市場予測、ボトムは2019年中盤か

メモリ市場予測、ボトムは2019年中盤か

今回は、これからのメモリ市況を占う。サーバ/データセンター、PC/スマホ、それぞれのメモリ需要のこれまでを振り返りながら、これからどうメモリ市場が動いていくか予想する。