ニュース

組み込み機器でも生成AIが使える 日本発のアクセラレーター:EdgeCortixが「SAKURA-II」を発表(3/3 ページ)

エッジAI(人工知能)向けのアクセラレーターを手掛ける日本のスタートアップEdgeCortixが、新しいプラットフォーム「SAKURA-II」を発表した。CNN(畳み込みニューラルネットワーク)モデルだけでなく、トランスフォーマーモデルを容易に実装できることが特徴だ。

1チップで複数モデルを実行するデモ

展示会ブースでは、SAKURAを使ったデモも幾つか披露していた。1つ目は、1個のSAKURA-Iで、16台のカメラの映像から同時に物体検出を行うもの。AIモデルにはYOLO v5sを用いていた。推論性能は約500fps(フレーム/秒)で、ボード全体の消費電力は8.2Wだという。

2つ目は、RGBカメラで撮影している映像を解析し、リアルタイムで解像度を上げて表示するというデモ。SAKURA-IでABPN(Attention-based Back Projection Network)モデルを実行し、映像の解像度を360×640から1080×1920と3倍に向上させた。これによって、より鮮明な画像の表示が可能になっていた。

左=ABPNモデルにより映像の解像度をリアルタイムで向上。上段が360×640、下段が1080×1920の映像/右=解像度を上げた下段の映像の方が、より明瞭に表示されている。これがリアルタイムで行える[クリックで拡大]

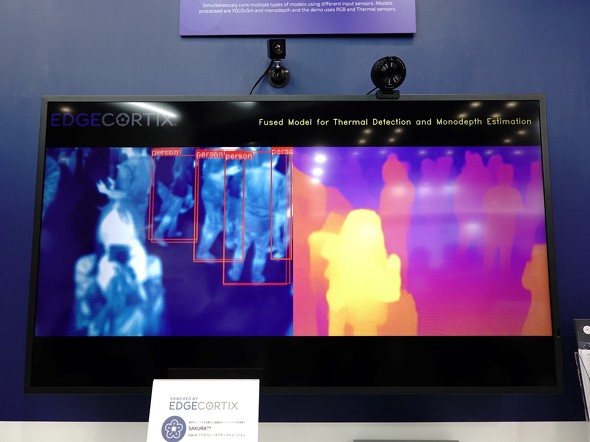

左=ABPNモデルにより映像の解像度をリアルタイムで向上。上段が360×640、下段が1080×1920の映像/右=解像度を上げた下段の映像の方が、より明瞭に表示されている。これがリアルタイムで行える[クリックで拡大]3つ目は、1個のSAKURA-Iで複数のAIモデルを同時に実行するデモだ。RGBカメラとサーマルカメラを使用して、YOLO v5mとmono Depthの2つのモデルを同時に実行し、物体検出と深度推定を行っていた。「MERAにモデルを入力後、ワークを分配することで、1チップで複数のモデルを実行できるようになる」(EdgeCortix)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

FPGAに実装可能なエッジAI用ハードIP、45fpsで推論

FPGAに実装可能なエッジAI用ハードIP、45fpsで推論

エッジデバイス用の推論プロセッサ開発を手掛けるEdgecortix(エッジコーテックス)は、「第1回 AI・人工知能 EXPO【秋】」(2020年10月28〜30日、幕張メッセ)で、同社の技術を実装して行うエッジAI(ここでは推論)のデモを展示した。 ルネサス、エッジコーティックスと戦略的提携

ルネサス、エッジコーティックスと戦略的提携

ルネサス エレクトロニクスは、エッジAIソリューションを提供するEdgeCortix(エッジコーティックス)に出資した。今回の戦略的提携によってルネサスは、エッジコーティックスが保有する技術を組み合わせ、エネルギー効率をさらに高めたAI/ML(機械学習)機能を提供していく。 PALTEK、エッジAI向けハードIPのEdgeCortixと提携

PALTEK、エッジAI向けハードIPのEdgeCortixと提携

PALTEKは、EdgeCortixと販売代理店契約を結んだ。ザイリンクス製アクセラレーターカードに、EdgeCortixが開発したエッジデバイス用推論プロセッサ向けハードウェアIPを実装し、省スペースや低電力化を必要にするエッジAI用途に提案していく。 「汎用マイコンでこそエッジAIを」 急加速する市場のけん引役を狙うST

「汎用マイコンでこそエッジAIを」 急加速する市場のけん引役を狙うST

AI(人工知能)関連技術の進展が目覚ましい昨今、クラウドではなくエッジデバイス上でAI推論を行うエッジAIの導入が進む。中でも、マイコンを用いた低消費電力のエッジAIへの注目が高まっている。開発者が抱える課題や求められるソリューションについて、STマイクロエレクトロニクスに聞いた。 Intelの最新AI戦略と製品 「AIが全てのタスクを引き継ぐ時代へ」

Intelの最新AI戦略と製品 「AIが全てのタスクを引き継ぐ時代へ」

Intelは、同社の年次イベント「Intel Vision 2024」にて、エッジからクラウドまであらゆる所でのAI(人工知能)の活用を目指す「AI Everywhere」戦略に関する製品や戦略を説明した。