2026年のHBM市況、カギを握るのは最新世代「HBM4」:福田昭のストレージ通信(301) 半導体メモリの行方をアナリストが解説(5)(2/2 ページ)

2025年8月に開催された「FMS(the Future of Memory and Storage)」の一般講演を紹介するシリーズ。今回はTrendForceのアナリストであるEllie Wang氏の講演を取り上げる。広帯域メモリ(HBM)の生産能力や容量、価格を予測する。

AIチップが搭載するHBM容量は288Gバイト、1年半で2倍に

続いて需要動向を見ていこう。標準的なAI処理プロセッサであるハイエンドの大規模GPUでは、HBMモジュールを主記憶として同一のパッケージに搭載することがごく当たり前になっている。GPU(厳密にはGPUモジュール)はプロセッサ(GPUダイ)とHBMモジュールで構成された状態になってから販売される。HBMの主要な需要家(最大顧客)とは、GPUベンダー、あるいはAIプロセッサ(モジュール)のベンダーを意味する。

HBMの最大ユーザーは、市販GPUのトップベンダーNVIDIAであることはDRAM業界では良く知られている。それからGPU大手のAMDも、HBMの重要なユーザーだ。

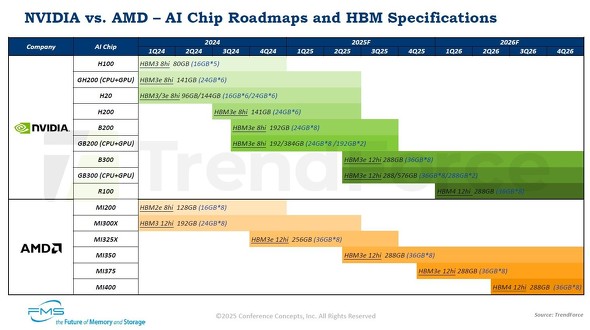

Wang氏による講演では、両社のAIチップとHBM仕様(DRAMダイ積層数とモジュール容量、搭載HBMモジュール数、搭載HBMの総記憶容量)が四半期ごとのロードマップとして示されていた。NVIDIAのAIチップが搭載するHBMモジュールの総記憶容量は、2024年前半に80Gバイト〜144Gバイトだった。主力のHBMモジュールは、HBM3E世代(DRAMダイ8枚の積層)の16Gバイトモジュールまたは24Gバイトモジュールである。

これが2025年後半になると、HBM3E世代でも主力製品はDRAMダイを12枚積層した36Gバイトモジュールに変わる。総記憶容量は288Gバイトで1年半前の2倍に増加する。2026年になるとHBM4世代のモジュールを搭載したAIチップの出荷が始まる。DRAMダイの積層数は12枚、モジュールの記憶容量は36GバイトとHBM3E世代と同じであるものの、データ転送速度が大きく向上する。

NVIDIAとAMDのAIチップとHBM仕様のロードマップ(2024年第1四半期(1Q24)〜2026年第4四半期(4Q26))[クリックで拡大] 出所:2025 Proceedings of FMS、TrendForce

AMDのAIチップが搭載するHBMモジュールの総記憶容量は2024年前半が128Gバイト(HBM2E世代、8枚積層の16Gバイトモジュール)と192Gバイト(HBM3世代、12枚積層の24Gバイトモジュール)、2024年後半が256Gバイト(HBM3E世代、12枚積層の36Gバイトモジュール)である。2025年には搭載するHBMモジュールの総記憶容量が288Gバイト(HBM3E世代、12枚積層の36Gバイトモジュール)に拡大する。そして2026年には、HBM4世代の36Gバイトモジュールを採用した総記憶容量288GバイトのAIチップが出荷される。

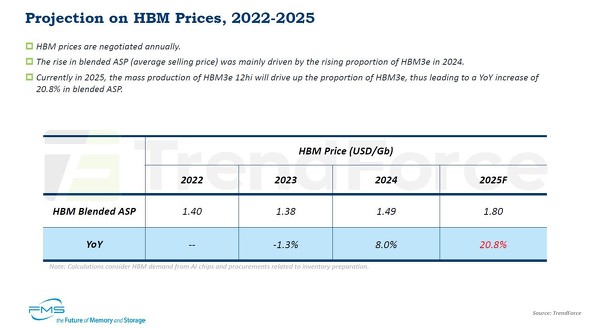

HBMの記憶容量当たり価格は2025年に21%上昇すると予測

平均価格(ASP)は、HBMモジュールのGビット当たり価格を意味する。HBMの価格交渉は単年ごとに実施されるという。2022年のASPは1.40米ドルだった。2023年には1.38米ドルとわずかに低下した。2024年は1.49米ドルで、ASPは反発した。同年はHBM3E世代の出荷比率が増加したことにより、価格が上昇したとする。

2025年のASPは大幅に上昇し、1.80米ドルに達すると予測する。12枚積層のHBM3E世代の量産が始まったことによって同世代の比率がさらに増加し、価格を押し上げる。

⇒「福田昭のストレージ通信」連載バックナンバー一覧

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

半導体メモリの地域別市場で2番目に大きくなった中国の現状

半導体メモリの地域別市場で2番目に大きくなった中国の現状

2025年8月に開催された「FMS(the Future of Memory and Storage)」の一般講演を紹介するシリーズ。Yole Groupのアナリストが中国のメモリ市場を解説した講演を取り上げる。 人工知能(AI)が牽引するHBM系DRAM市場

人工知能(AI)が牽引するHBM系DRAM市場

2025年8月に米国で開催された「FMS(the Future of Memory and Storage)」の講演を紹介する。今回は、TrendForceのシニアバイスプレジデントを務めるArvil Wu氏の講演概要を説明する。 Sandiskの四半期業績、前期比で2四半期連続の増収増益に

Sandiskの四半期業績、前期比で2四半期連続の増収増益に

今回は、Sandiskの2025年7月〜9月期(2026会計年度第1四半期)の業績を紹介する。 Samsungの半導体四半期業績、売上高と利益がともに急回復

Samsungの半導体四半期業績、売上高と利益がともに急回復

Samsung Electronicsの2025年度第3四半期(2025年7月〜9月期)の四半期業績を紹介する。半導体部門の決算の概要をお伝えする。 SK hynixの決算、2四半期連続で売上高と営業利益が過去最高を更新

SK hynixの決算、2四半期連続で売上高と営業利益が過去最高を更新

今回は、SK hynixの2025年度第3四半期(2025年7月〜9月期)の業績を紹介する。売上高、営業利益ともに2四半期連続で過去最高を更新した。 HDD大手Seagateの四半期業績は増収増益、営業利益率は30%に近づく

HDD大手Seagateの四半期業績は増収増益、営業利益率は30%に近づく

米Seagate Technologyの2026会計年度第1四半期(2025年7月〜9月期)の決算を紹介する。