1.2TB/s、24GBのHBM3 Gen2 LLMの学習を高速化:Micronがサンプル出荷を開始(2/2 ページ)

Micron Technologyは2023年7月、生成AI(人工知能)などの用途に向けて、1.2Tバイト/秒のメモリ帯域幅と、24Gバイトの容量を実現したHBM3 DRAM「HBM3 Gen2」のサンプリング出荷を開始したと発表した。

LLMの学習時間を短縮

これらの特長からHBM3 Gen2は、大規模言語モデル(LLM)の学習時間を短縮できる、AI推論向けに高効率なインフラを構築できるといった利点を提供できるとする。Micronによれば、HBM3をHBM3 Gen2に置き換えた場合、GPT3.5の学習時間は30%短縮し、推論のクエリ処理能力は50%向上するという。

Micronのコンピュート&ネットワーキング事業部門 バイスプレジデント兼ゼネラル・マネージャーのPraveen Vaidyanathan氏は、2023年7月27日に開催されたアジアの報道機関向けの説明会で、より広帯域幅で大容量のメモリが必要とされている背景について、「爆発的ともいえるAIの拡大が続き、アプリケーションの幅が広がっていることが挙げられる」と語った。特に、コンピューティングやメモリへの要求が大きい生成AIやHPC、大量のデータを扱うディープラーニングが、けん引する要因になっていると続けた。

さらに、AI処理に向けたサーバ(AIサーバ)は汎用サーバとは異なり、DRAM搭載量が6〜8倍になると言及。こうした背景により、HBM市場(ビットベース)は2022〜2025年にかけて、年平均成長率(CAGR)50%以上で成長するとの予測を紹介した。

12層の36Gバイト品も2024年にサンプル出荷へ

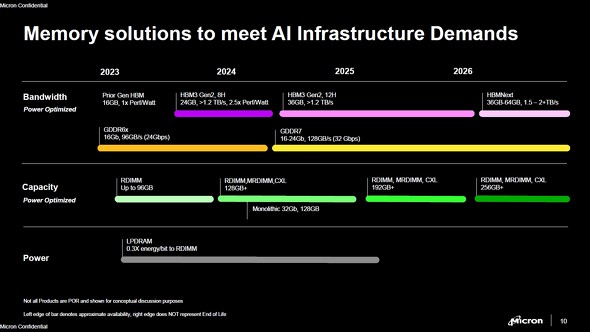

Vaidyanathan氏は、「MicronはAIインフラに必要なメモリに対する、あらゆるニーズに応えたい」と述べ、今後のロードマップも紹介した。

HBM3 Gen2では、8層を積層した今回の24Gバイト品に加え、12層を積層した36Gバイト品のサンプル出荷を2024年第1四半期に開始する予定だ。2026年以降には、帯域幅と容量をさらに高めた「HBMNext」をリリースするという。

2024年前半には128Gバイト/秒(32Gbps)のGDDR7を市場に投入する他、「MRDIMM(Multi-Ranked DIMM)」や「CXL(Compute Express Link)」対応のメモリも発表するとみられる。Micronは2021年3月に、Intelと共同開発した不揮発メモリ「3D XPoint」の開発から撤退し、CXL対応のメモリ開発へと舵を切る戦略を発表していた。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Micronが「3D XPoint」開発から撤退へ、工場も売却

Micronが「3D XPoint」開発から撤退へ、工場も売却

Micron Technology(以下、Micron)は2021年3月16日(米国時間)、同社がIntelと共同開発した不揮発メモリ「3D XPoint」の開発から撤退し、CXL(Compute Express Link)を用いる新しいメモリ製品への開発へとリソースを移行すると発表した。 Micron、27億5000万ドルでインドに後工程新工場

Micron、27億5000万ドルでインドに後工程新工場

Micron Technologyは2023年6月22日、最大27億5000万米ドルで、インド・グジャラート州にDRAMおよびNAND型フラッシュメモリの組み立て/テスト工場を新設すると発表した。インド中央政府と州政府から総事業費の70%の財政支援を受けるという。 EUV適用1γ DRAM、広島工場では2026年に生産開始

EUV適用1γ DRAM、広島工場では2026年に生産開始

Micron Technologyは2023年5月22日、EUV(極端紫外線)リソグラフィ適用の1γノードDRAMの生産発表に併せて広島工場で記者会見を実施した。 3D DRAMからCXLメモリまで、Micronの見解を聞く

3D DRAMからCXLメモリまで、Micronの見解を聞く

2022年8月、米国の半導体支援の法案「CHIPS法(正式名称:CHIPS and Science Act)」の可決に伴い、400億米ドルを投じて米国での生産活動を拡張すると発表したMicron Technology(以下、Micron)。同年9月1日(米国時間)には、米国で20年ぶりにメモリ工場を建設する計画も発表した。EE Times Japanは、Micronのモバイルビジネス部門でシニアバイスプレジデント兼ゼネラルマネジャーを務めるRaj Talluri氏および、Micron本社に取材し、市場動向や新しいメモリ技術に対するMicronの見解について聞いた。 Micron、232層3D NANDフラッシュの量産を開始

Micron、232層3D NANDフラッシュの量産を開始

Micron Technology(以下、Micron)は2022年7月26日、第6世代の3D(3次元) NAND型フラッシュメモリとして、232層NANDフラッシュの量産を開始したと発表した。6プレーン動作のTLC(Triple Level Cell)を採用し、低電圧インタフェースのNV-LPDDR4に対応する最初の製品となる。 Micronのアイダホ新工場が、米国のDRAM供給を向上させる

Micronのアイダホ新工場が、米国のDRAM供給を向上させる

Micron Technologyが米国で20年ぶりにメモリ工場を建設する計画を発表したことについて、米国の市場調査会社であるIC InsightsのアナリストBrian Matas氏は「半導体製造を米国で行うことは有益だ。CHIPS法(正式名称:CHIPS and Science Act)は米国の企業が拡張計画を進めるきっかけになった。米国でIC(集積回路)を現地調達できるようになるのは良いことだ」と述べている。