超低電圧動作でエネルギー効率を大幅向上、PIM型アクセラレーター:164TOPS/Wを達成

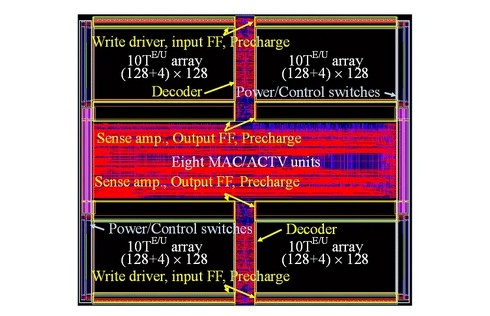

東京科学大学は、推論時のエネルギー効率を飛躍的に高めるプロセッシングインメモリ(PIM)型のニューラルネットワークアクセラレーターマクロを開発した。EMP動作が可能なSRAMを採用し、推論時のエネルギー効率を164TOPS/Wにまで高めた。

東京科学大学 総合研究院 未来産業技術研究所の菅原聡准教授と塩津勇作研究員らの研究チームは2025年4月、推論時のエネルギー効率を飛躍的に高めるプロセッシングインメモリ(PIM)型のニューラルネットワーク(NN)アクセラレーターマクロを開発したと発表した。エネルギー最小点(EMP)で動作することでエネルギー効率を最大化するとともに、積和演算(MAC)の並列化により、推論時のエネルギー効率は164TOPS/Wを実現したという。

PIM型NNアクセラレーターは、バスを介することなくメモリにある重みデータを取り出してMAC演算を行うことで、エネルギー効率を向上させられる。特に、メモリとしてSRAMを用いたPIM型NNアクセラレーターは、ロジックCMOS技術で実装できるので、応用していく上で重要とされている。

NNアクセラレーターで演算性能を維持したまま省電力化するには、EMPとなる駆動電圧で推論できることが極めて重要になる。CMOSロジックシステムのEMPは0.25〜0.4V程度であることが知られているが、このような低電圧では、SRAMを含む一般的なメモリにおいて動作信頼性を確保することが難しい。そのため、EMPで動作するPIM型NNアクセラレーターの実現は困難だった。

今回は、研究チームが開発してきた、EMP動作が可能なSRAMを用いてNNアクセラレーターを開発。MAC演算の並列数を増やすことで、EMPをさらに低電圧側にシフトさせ、エネルギー効率を大幅に向上させられるとする。

研究チームが開発したアクセラレーターマクロは、複数のマクロを組み合わせることで、任意のサイズ/形状のネットワークを実現できる。今回は2値化NN(BNN)で実装した。INT4、INT8用にも構成できるという。

8並列のPIM型BNNアクセラレーターマクロ(PPIM)を用いて推論動作時の性能評価を行った結果、従来の1並列PIM型マクロ(SPIM)ではEMPは0.4Vだったが、PPIMではEMPは0.275Vにまで低減した。この時、PPIMのエネルギー効率は大幅に増加して、164TOPS/Wに到達したという。

研究チームは今後、MAC演算の並列数をさらに増やしたPIMマクロの他、INT4/INT8対応のPIMマクロ技術、GPUやカスタムプロセッサにも応用できるマクロ技術を開発する予定だ。

本成果は、IEEEの「IEEE Journal on Exploratory Solid-State Computational Devices and Circuits」に、2025年3月10日付で掲載された。

(※)本記事は制作段階で生成系AIを利用していますが文責は編集部に帰属します(ITmedia AI倫理ポリシー)。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

東工大ら、PIM型NNアクセラレーターのマクロを開発

東工大ら、PIM型NNアクセラレーターのマクロを開発

東京工業大学と工学院は、モバイルエッジデバイスに搭載可能な、PIM(プロセッシングインメモリ)型ニューラルネットワーク(NN)アクセラレーターのマクロを開発した。動作時と待機時の電力消費が極めて小さく、高い演算能力とエネルギー効率を実現できるという。 「フラッシュメモリで」AI演算 消費電力はGPU比で1000分の1に

「フラッシュメモリで」AI演算 消費電力はGPU比で1000分の1に

フローディア(Floadia)が、SONOS構造のフラッシュメモリを用いて超低消費電力で推論を行うCiM(Computing in Memory)技術を開発中だ。GPUに比べ1000分の1ほどの消費電力で積和演算を実行できるという。2025年春ごろには試作チップができ上がる。 アナログCIM回路でCNNとTransformerの処理を実現

アナログCIM回路でCNNとTransformerの処理を実現

慶應義塾大学は、Transformer処理と畳み込みニューラルネットワーク(CNN)処理を、極めて高い演算精度と電力効率で実行できる「アナログCIM(コンピュート・イン・メモリ)回路」を開発した。自動運転車やモバイルデバイスといったエッジコンピューティングにおいて、AI(人工知能)技術の導入が容易となる。 ラズパイで生成AIモデルを実行、EdgeCortixがデモ

ラズパイで生成AIモデルを実行、EdgeCortixがデモ

EdgeCortixは「第9回 AI・人工知能 EXPO 春」で、「Raspberry Pi」と同社のAIアクセラレーター「SAKURA-II」を組み合わせ、Transformerモデルを実行するデモを展示した。1枚のカードで3つのAIモデルを実行するデモも披露した。 AIシステムの「メモリの障壁」を取り除く MRAMで挑む米新興

AIシステムの「メモリの障壁」を取り除く MRAMで挑む米新興

米スタートアップのNumemは、MRAMベースの同社のメモリ「NuRAM」によって、AIシステムにおけるメモリのボトルネックを解消しようと取り組んでいる。

![今回開発したマクロにおける動作周波数(緑線)、平均電力(青)、消費エネルギー(赤)、推論時のエネルギー効率(黒)。実線がPPIMで、破線がSPIM[クリックで拡大] 出所:東京科学大学](https://image.itmedia.co.jp/ee/articles/2504/24/mm250424_uos02_w490.jpg)