NVIDIAが解説するディープラーニングの基礎(前編):歴史から仕組み、学習まで(4/4 ページ)

エヌビディアは2018年4月24日、ディープラーニングに関するセミナー「NVIDIA Deep Learning Seminar 2018」を東京都内で開催した。本稿では、セッション「これから始める人のためのディープラーニング基礎講座」から、ディープラーニングの歴史や概要、学習の流れについて紹介する。

過学習と局所解について

このように、層が深いディープラーニングでは勾配法と誤差逆伝播法が学習に重要な役割を果たしているが、一方で課題も存在する。その代表的なものとして、山崎氏は「過学習」と「局所解」を説明した。

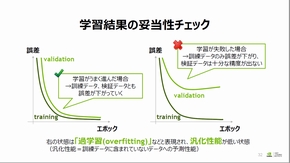

ニューラルネットワークの学習では、一般的に学習データと学習状態を検証する検証データを分けて学習の妥当性を検証する。学習が成功した場合、学習が進むにつれ学習用データと検証データの誤差が0に漸近するが、学習が失敗した場合は学習データのみ誤差が0に漸近し、検証データでは学習データほどの精度が出ないことがある。これを過学習とし、そのネットワークは一般的なデータ処理性能(汎化性能)が低い状態にあるという。

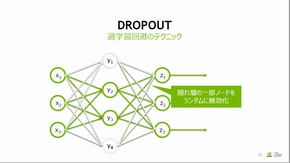

山崎氏は過学習の回避について、隠れ層の一部パーセプトロンをランダムに無効化し学習を行う「Dropout」と呼ばれる手法が有効だと紹介した。

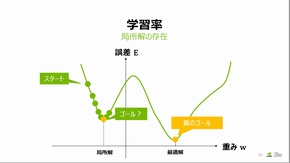

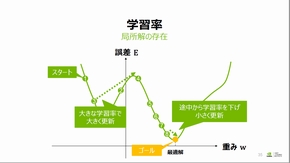

また、以下の重み係数と誤差の関数で図示されているように、複数の極小値を持つ場合では、誤差が最も小さい重み係数でない「局所解」で学習が収束することがあるという。山崎氏は、重み係数更新のステップである学習率を学習の序盤では大きめに設定し、途中から学習率を下げていくことで局所解での学習収束を回避できるとした。

後編では、セッション後半で語られた畳み込みニューラルネットワークなどのさまざまなネットワークやその応用例、ディープラーニングフレームワークの概要について紹介する。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIAが解説するディープラーニングの基礎(後編)

NVIDIAが解説するディープラーニングの基礎(後編)

エヌビディアは2018年4月24日、ディープラーニングに関するセミナー「NVIDIA Deep Learning Seminar 2018」を東京都内で開催した。本稿では、セッション「これから始める人のためのディープラーニング基礎講座」から、各種ニューラルネットワークやその応用例、ディープラーニングフレームワークの概要について紹介する。 IoT時代、ディープラーニングの主用途は制御か

IoT時代、ディープラーニングの主用途は制御か

Preferred Networks(PFN)は、IoT(モノのインターネット)にディープラーニングを活用する意義について、自社の応用例を挙げて説明した。また、IoTの普及でデータ量がどの程度増加するかを取り上げた上で、ディープラーニングの処理性能向上に向けた自社の取り組みについて語った。 機械学習を活用する将来の半導体設計

機械学習を活用する将来の半導体設計

次世代チップ関連の会議「ISPD」(2017年3月19〜22日、現地時間)では、「機械学習は、チップの設計において“人間の仕事”を減らす方向に向かっている」との見解が示された。 パナとNVIDIA、ディープラーニングで連携

パナとNVIDIA、ディープラーニングで連携

パナソニック ソリューションテクノロジーは、「第6回 IoT/M2M展【春】」で、NVIDIA製AIスーパーコンピュータ「DGX-1」とGPU「Tesla P100」および、AIスーパーコンピュータを搭載した自動運転の事例などを紹介した。 組み込みに特化した商用の深層学習フレームワーク

組み込みに特化した商用の深層学習フレームワーク

ディープインサイトは、「Embedded Technology 2017(ET2017)/IoT Technology 2017」で、組み込み機器に特化した商用の深層学習フレームワークを使い、CPUで高速に推論処理を実行するデモを行った。 深層学習を32ビットマイコンで実現 STがデモ

深層学習を32ビットマイコンで実現 STがデモ

STMicroelectronicsは、「embedded world 2018」で、32ビットマイコン「STM32」にDNN(ディープニューラルネットワーク)を実装するデモを披露した。 我々が求めるAIとは、碁を打ち、猫の写真を探すものではない

我々が求めるAIとは、碁を打ち、猫の写真を探すものではない

ちまたには「人工知能」という言葉が氾濫しています。ですが、明言しましょう。「人工知能」という技術は存在しません。そして、私たちがイメージする通りの「人工知能」の実現も、恐らくはまだまだ先になるでしょう。