エッジAIを安価・高速に、FPGAを駆使するベンチャー:どんなモノにも深層学習を実装(1/2 ページ)

LeapMindは2018年8月31日、東京都内で同社初となるプライベートカンファレンス「DeLTA TECH 2018」を開催した。このイベントでは、LeapMindの強みとなる技術が多く明かされていた。

「今のディープラーニングは巨大な資金や電力リソースが必要であり、一部の企業でしか恩恵を享受できていない。この状況を打破し、あらゆるものにディープラーニングを実装したい」

こう語るのは、エッジデバイスなどの組み込み機器向けディープラーニング(深層学習)に強みを持つベンチャー企業「LeapMind」。

LeapMindは2018年8月31日、東京都内で同社初となるプライベートカンファレンス「DeLTA TECH 2018」を開催した。このイベントでは、LeapMindの強みとなる技術が多く明かされていた。

組み込み特化のニューラルネットワーク

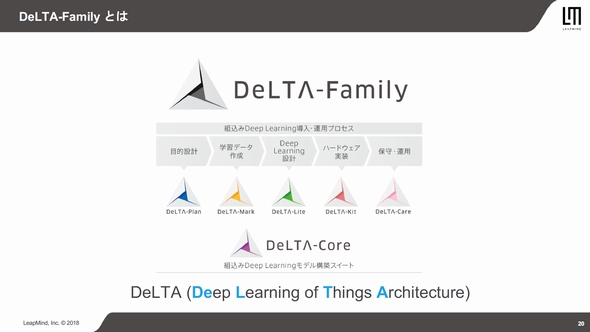

LeapMindは、組み込み用途でのディープラーニングを実現する「DeLTA(Deep Learning of Things Architecture)-Family」の提供している。同社プロジェクトマネジャーの安村修一氏は、DeLTA-Familyを「ディープラーニングの導入から運用、保守までをワンストップで請け負うソリューション」と説明する。

DeLTA-Familyは、学習データのアノテーション付加を支援するDelTA-Mark、ブラウザ上でニューラルネットワークのモデル構築を行うDeLTA-Lite、DeLTA-Liteで生成したモデルを評価できるハードウェアキットを提供するDeLTA-Kit、そしてこれらの中核となるDeLTA-Coreなどといったサービスで構成される。

さまざまなエッジデバイスにディープラーニングの推論を活用したアプリケーションを実装するには、安価かつ低消費電力なチップで高速に動作するニューラルネットワークが必要となる。同社は、組み込み向けFPGAを活用。DeLTA-KitにはIntelの「Cyclone V SoC」を採用する。

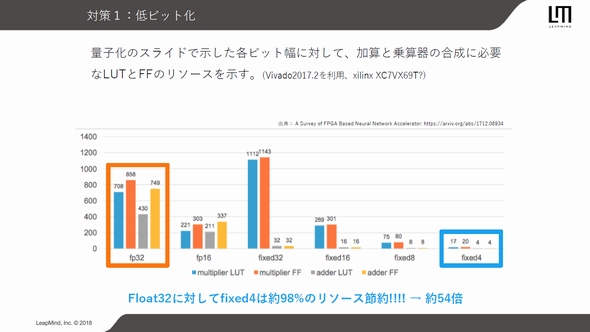

一方で、組み込み向けFPGAは演算速度やメモリなどの計算リソースが限られているため、同社は独自のニューラルネットワーク「LMnet」を開発。アプリケーションの目的に寄与しないニューロンを刈り取るPruning(剪定)や、FP32(32ビット浮動小数点)よりサイズの小さい演算精度を用いるQuantization(量子化)、大規模なモデルを模擬するように小規模なモデルを学習させるDistillation(蒸留)などの手法を駆使する。

DeLTAでは学習時に量子化を実行し、Weight(重み係数)は1ビット、Activation(入力)は2ビットの演算精度を使用。これにより、大幅なモデルサイズの圧縮と高速化を図ったとする。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

講演を行う安村修一氏

講演を行う安村修一氏