「エッジでもLLMを動かす」 韓国新興DEEPX:HBMではなくLPDDRにこだわる(2/3 ページ)

「GPUより優れたAI精度」

DEEPXは特許を60件保有し、282件申請している。Kim氏は、「これは他のどのオンデバイスAIチップメーカーよりも多い」と述べている。ただし同氏は、ハードウェアとソフトウェアの両方に「4つまたは5つの」異なる技術を搭載していると明かしただけで、同社の量子化技術がどのように機能するか、詳細は明らかにしていない。

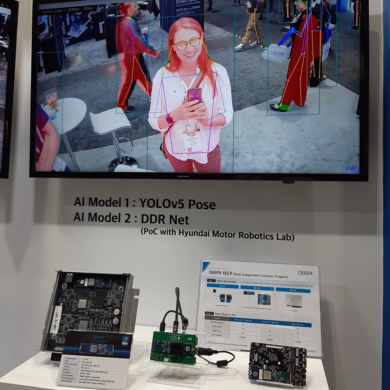

M1で、2種類のAIモデルを動作させているデモ。姿勢検知用にYOLOv5を、セマンティックセグメンテーション用にDDR Netを走らせている。このデモで使用したAIシステムは、Hyundai Motor Robotics Labと共同で開発したPoC(Proof of Concept)である[クリックで拡大]

M1で、2種類のAIモデルを動作させているデモ。姿勢検知用にYOLOv5を、セマンティックセグメンテーション用にDDR Netを走らせている。このデモで使用したAIシステムは、Hyundai Motor Robotics Labと共同で開発したPoC(Proof of Concept)である[クリックで拡大]「DEEPXは、INT8を使用しているにもかかわらず、GPUより優れたAI精度を提供する世界で唯一の企業ではないか。当社は、GPUを越えると自負している」(Kim氏)

V1のサンプルは2023年11月から市場に出ている。Kim氏によると、同社は現在、欧州、北米、アジアの約100社の顧客と取引しているという。

同社は以前、EE Timesに対し、「自動車分野の顧客にNPUをライセンス供与する」と語っていた。Kim氏によると、主に欧州と日本の自動車メーカーとの間で交渉が進んでいるという。自動車メーカーはアプローチを変えつつある。以前はチップメーカーがティア1の要望を聞いて対応していたが、現在は、独自のAIアクセラレーターチップを製造するTeslaに対抗すべく、自動車メーカー自身がチップメーカーに直接コンタクトを取るようになっているという。

同氏は、「中国市場にもチャンスがある。中国の自動車メーカーは、2027年までに全ての車載アプリケーションに中国製のチップを搭載することを義務付けられているが、高度なNPU技術を持っていない。そのため、NPU IPに対する(中国からの)需要は高い」と述べている。

DEEPXの最優先事項は、依然としてチップの販売であると同氏は明言している。

エッジデバイスでLLMをサポート

DEEPXは、次世代チップでTransformerをさらにサポートする計画だという。

Kim氏は、「現在、当社は一部のTransformerしかサポートしていない。(NPUでは)Transformerエンコーダーはサポートしているが、デコーダーはサポートしていない。技術的には可能だが、それよりも、次世代チップでのサポートに注力している」と述べている。

2025年末に登場する次世代チップは、エッジデバイスでLLM(大規模言語モデル)をサポートするという。Kim氏によると、M.2モジュールは、5W以下で毎秒20〜30トークンを提供できる見通しだ。これは、DEEPXのAI研究グループが現在、共同研究を行っている韓国の家電大手LGを含む潜在顧客からの要請に応えたものである。Kim氏は、「テレビの寿命期間中ずっとデータセンターでAI推論を行うと、テレビのプライスポイントを上回るコストが掛かるため、LGはモバイル機器や自動車、白物家電のDEEPXチップにLLMを移植することに興味を示している」と述べている。

「(デバイスにAIを搭載することは)LGのLLMジネスモデルにとって、実に理にかなっている。だからこそ、われわれは協力している。同社がLLM技術を提供してくれることで、当社はモデルの特性について学び、オンデバイスアプリケーション向けに最適化することができる」(Kim氏)

その結果、デバイスのLLM向けに最適化されたNPUチップが実現できる。Kim氏は、「最初のバージョンは、アクセラレーターのみになる予定だ。今のところエンドポイントデバイスでは、必要なメモリ容量に対応できないため、LLM対応SoCを実現するには3〜5年かかるだろう」と述べている。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか