NVIDIA、AI推論ソフト「TensorRT 3」を発表:GPUとの組み合わせで効率化

NVIDIAが新しいAI推論ソフトウェア「TensorRT 3」を発表した。GPUと組み合わせて、高速かつ効率的な推論を目指すという。

NVIDIAのGPUとの組み合わせでAI推論を加速

NVIDIAのCEO(最高経営責任者)を務めるJensen Huang氏は、2017年9月25〜27日に中国の北京で開催したGPU開発者会議「GPU Technology Conference」で、NVIDIAの新しいAI推論プラットフォーム「TensorRT 3」を発表した。

NVIDIAは、「大手インターネット企業は、画像や音声認識、自然言語処理、視覚検索、個別推奨などのAI対応サービスで生成されるデータの爆発的な増加への対応に奮闘している。サービスプロバイダーにとっても、データセンターとクラウドサービスのインフラのコストを大幅に削減できるような、迅速で正確なAI推論ソリューションの獲得が急務である」と説明した。

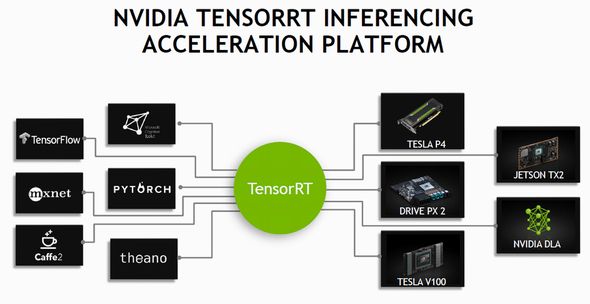

同社は、「TensorRT 3とNVIDIAのGPUを組み合わせることで、AI対応サービスのあらゆるフレームワークで超高速かつ効率的な推論を実現できる」としている。

Huang氏はGTCで、中国の主要インターネット企業であるAlibaba CloudやBaidu、Tencentが現在、NVIDIAのGPUアクセラレータ「Tesla V100」を活用してデータセンターやクラウドサービスインフラをアップグレードしていることを明らかにした。

同社はまた、InspurやLenovo、Huaweiなどの中国の大手機器メーカーが、リファレンスアーキテクチャ「NVIDIA HGX」を採用して、ハイパースケールデータセンター向けのGPUアーキテクチャ「Volta」ベースのアクセラレーテッドシステムを提供する計画を進めていることも発表した。

NVIDIAは、「ただし、ハードウェアだけでは、AI推論におけるデータの爆発的増加に対応するAIベースのサービスプロバイダーへの十分な支援ができない」として、顧客企業にTensorRTプラットフォームの採用を勧めている。

NVIDIAは北京で、Alibaba、Baidu、Tencent、JD.com、Hikvisionがプログラマブルな推論の加速に向けてNVIDIAのTensorRTを採用することも明らかにした。

ただし、NVIDIAのアクセラレーテッドコンピューティング担当グループ製品マーケティングマネージャーを務めるParesh Kharya氏によると、これまでのところ、TensorRTを既に採用しているのはJD.comだけだという。

Kharya氏は、「多くのAIベースのサービス企業はこれまで、オープンソースのディープラーニングライブラリ『TensorFlow』や『Caffe』など、トレーニングされたニューラルネットワークフレームワークを自社で選んだGPU上で実行することで、独自の最適化を行ってきた。TensorRTは、こうした手法では対応できなかった処理にも対応できる」と述べている。

サービスプロバイダーはTensorRTを採用することで、トレーニングしたディープラーニングフレームワークの選定から、目的に合ったGPUを選択するところまでを行える。

現在のところ、AIアプリケーションの製品展開に向けた“高性能最適化コンパイラとランタイムエンジン”がパッケージされた製品を提供する企業は、NVIDIA以外にはない。

NVIDIAは、「TensorRTは、ニューラルネットワークの記述ファイルをコンパイルしてターゲットGPU上で実行するため、トレーニングした推論ニューラルネットワークをハイパースケールデータセンターや組み込みGPUまたは車載GPUプラットフォーム向けに迅速に最適化し、検証、展開することができる」と説明している。

【翻訳:滝本麻貴、編集:EE Times Japan】

関連記事

「ムーアの法則は終わった」、NVIDIAのCEOが言及

「ムーアの法則は終わった」、NVIDIAのCEOが言及

台湾・台北で開催された「COMPUTEX TAIPEI 2017」で、NVIDIAのCEOであるJensen Huang氏は、「ムーアの法則は終わった。マイクロプロセッサはもはや、かつてのようなレベルでの微細化は不可能だ」と、ムーアの法則の限界について言及した。 ニューラルプロセッサIP、AI搭載モバイルを後押し

ニューラルプロセッサIP、AI搭載モバイルを後押し

Imagination Technologies(イマジネーションテクノロジーズ)が、ニューラルネットワークの処理に特化したアクセラレーター「PowerVR 2NX NNA」を発表した。モバイル機器にAI(人工知能)を搭載する動きが進む中、「今後のキーテクノロジーになる」と同社は語る。 AIで社会は良くなるか、それとも混乱するのか

AIで社会は良くなるか、それとも混乱するのか

ARMは、人工知能(AI)に関する意識調査を行った。将来はロボットの反乱で混乱するのか、それとももっと良い社会になるのか。 おうちにやってくる人工知能 〜 国家や大企業によるAI技術独占時代の終焉

おうちにやってくる人工知能 〜 国家や大企業によるAI技術独占時代の終焉

今回のテーマは「おうちでAI」です。といっても、これは「AIを自宅に実装すること」ではなく、「週末自宅データ分析およびシミュレーション」に特化したお話になります。さらに、そうなると避けては通れない「ビッグデータ」についても考えてみたいと思います。そして、本文をお読みいただく前に皆さんにも少し考えていただきたいのです。「ビッグデータって、いったいどこにあるのだと思いますか?」 量子コンピュータ実現に向け大きな前進――超大規模量子もつれの作成に成功

量子コンピュータ実現に向け大きな前進――超大規模量子もつれの作成に成功

東京大学大学院工学系研究科の古澤明教授らは、光での量子もつれ生成を時間的に多重化する新手法を用いて、従来に比べ1000倍以上となる1万6000個以上の量子がもつれ合った超大規模量子もつれの生成に成功したと発表した。古澤氏は「量子コンピュータ実現に向け、大きな課題の1つだった『量子もつれの大規模化』に関しては、解決された」とする。 NVIDIAがMOSFETの比例縮小則(デナード則)を解説(前編)

NVIDIAがMOSFETの比例縮小則(デナード則)を解説(前編)

1970年代から1990年代にかけて、半導体集積回路は「デナード・スケーリング」という法則に沿って高密度化と高速化を達成してきた。今回は、デナード・スケーリングの内容と、なぜ1990年代以降は、この法則に沿って微細化を進めることが困難になったのかを説明する。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

NVIDIAのJensen Huang氏 出典:NVIDIA

NVIDIAのJensen Huang氏 出典:NVIDIA