EE Times Japan >

連載記事 >

開き直る人工知能 〜 「完璧さ」を捨てた故に進歩した稀有な技術:Over the AI ―― AIの向こう側に(14)(7/9 ページ)

» 2017年08月29日 11時30分 公開

[江端智一,EE Times Japan]

ベイズ理論の概念と似ているN-gramモデル

では、最後に、N-gramモデルについて、私なりの理解で簡単に説明を試みます。

以前、この連載で、ベイズ推論のお話をしました(「困惑する人工知能 〜1秒間の演算の説明に100年かかる!?」)。まずは、この内容を思い出してください(まあ、思い出さなくても良いですが)。

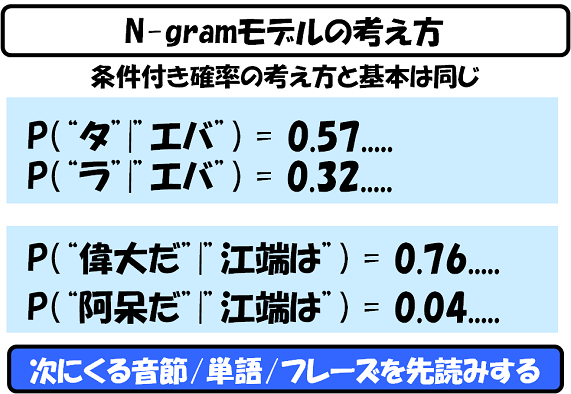

N-gramモデルとは、ぶっちゃけ「条件付き確率」のことです。ある事象の発生確率が、その直前までに既に発生してしまった事象によって、コロコロと変化する確率のことです。

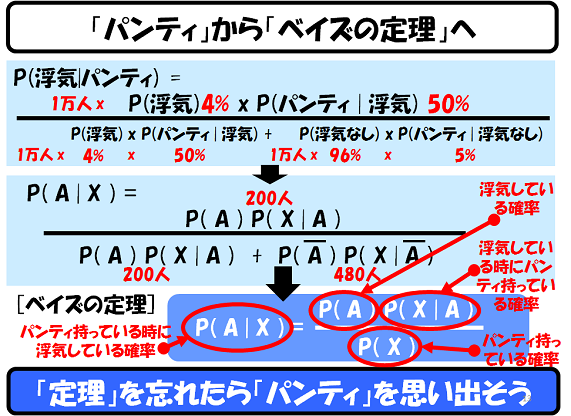

この例では、パートナー(男性)の浮気の確率が、他の条件によって(タンスの中からパンティが発見されたという事実で)変化することを示す、「"パンティ発見"条件付き"浮気"確率」を表しています。

N-gramモデルの考え方も、概念的には同じです(多分)。

"エバ"と出てきたら、次が「タ」となり"エバタ"となる確率と、"エバ"と出てきたら、次が「ラ」となり、"エバラ"となる確率を計算して、高いものからリストアップしておきます。こうしておけば、"エバ"の後の音節が不明瞭でも、力づくで音声認識を押し進めることができます。

また、文節単位でも、"江端は"がくれば、普通に「偉大だ」が確率的に上位にくるはずです。"江端は"の後に「阿呆だ」が登場する確率が下位に沈むのは間違いありません。なぜなら「江端は偉大だ」は、もはや、慣用句といってもいいレベルにあるからです(うそです)。

Copyright © ITmedia, Inc. All Rights Reserved.

Special ContentsPR

特別協賛PR

スポンサーからのお知らせPR

Special ContentsPR

Pickup ContentsPR

記事ランキング

- 中国が「半導体製造装置の自給自足」に苦戦している理由(前編)

- 中国が「半導体製造装置の自給自足」に苦戦している理由(後編)

- 3nmチップ搭載の最新スマホ3機種を分解 三者三様の設計思想とは

- 半導体業界 2026年の注目技術

- AI需要で好調も 村田製作所社長が語る「MLCC依存」脱却の一手

- 2026年のメモリ市場は「制御された供給不足」に 主役はHBM4

- ルネサス「R-Car V4H」、トヨタ新型「RAV4」に採用

- ローム、TSMCライセンス受けGaN一貫生産へ 27年目標

- Infineon、AI電源事業が驚異的成長 「売り上げ3年で10倍に」

- 2026年半導体市場の3大トピックを深掘り ―― DRAM不足の真相とTSMC、Intelの逆襲

Special SitePR

あなたにおすすめの記事PR