社会実装に向け着実に進化、CEATEC 2017で見たAI:タオルをたたむ、人間と対話する

産業技術総合研究所(産総研)やNextremerは、「CEATEC JAPAN 2017」の「AI-人工知能パビリオン」で、人工知能(AI)技術を用いたロボット制御システムや対話システムなどを紹介した。

タオルを折りたたむロボット

「CEATEC JAPAN 2017」(2017年10月3〜6日)の「AI-人工知能パビリオン」では、産業技術総合研究所(産総研)やNextremer(ネクストリーマー)が、人工知能(AI)技術を用いたロボット制御システムや対話システムなどを紹介した。

産総研は、人間との共存や生活支援を行うロボットの実現に向けたAI技術を幾つか紹介した。その1つは深層学習(ディープラーニング)技術を応用したロボットで、これまで扱うことが困難といわれてきたタオルやシャツのような柔らかいものをリアルタイムにつかみ、折りたたむことができる。

このシステムでは、人間がロボットを操作してタオルなどの柔軟な物を折りたたむ動作を教え込み、ロボットに成功体験を積み重ねさせた。実際にロボットが折りたたみ作業を行う時には、入力されたカメラの画像から、これまで蓄積してきたデータを参照しながら、タオルをつかむ場所やそのためのアーム動作をロボット自身が連想し、リアルタイムに行動するという。

「ロボットの学習は人手で行うため負担は大きいが、折りたたみ動作はリアルタイムに行うことができる。3Dモデリングによる学習だと、柔軟物を判別しアームが動き出すまで30秒程度要することもある」(説明員)と話す。ブースに設置したロボットは折りたたみ作業を30回学習させたという。完全ではないが、かなり高い確率でタオルの折りたたみに成功した。

VR上で人間とロボットが対話する……!

もう1つは、VR(仮想現実)によるロボットと人間の対話実験に向けたシミュレーター技術である。社会生活を行う上で人間とロボットが共存するためのデータベースを蓄積するという。具体的には、VR上でロボットによる指示を人間がどれだけ正しく理解し、迅速に行動できるかを確認する。

ブースでは、HMD(ヘッドマウントディスプレイ)を装着し、両手に持ったスティックを使ってデモを行った。ロボットからの指示を人間が理解し、作業を完了するまでのレスポンス時間を計測する。このデータをクラウドに蓄積し、クラウド側で分析することにより、日常生活に支障がない会話を行える知能ロボットの開発に活用していく。

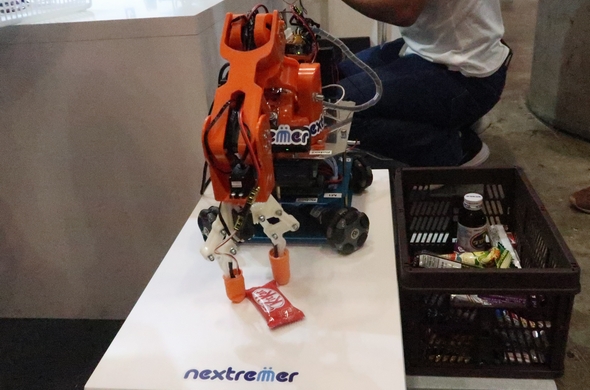

AIを使ったマニピュレーター

Nextremerは、AI技術を用いた移動マニピュレーターのデモを行った。シミュレーションで学習した結果に基づき、カメラが捉えた映像から円筒形や直方体、立方体といった形状や色を見極め、形状ごとに異なるつかみ方などの動作方法を判断し、マニピュレーターを適切に制御するという。

Nextremerはこの他、パートナー企業と連携し、自然言語処理機能を有するマルチモーダル対話システム「minarai」を活用した具体的な事例を紹介した。例えば、本田技研工業(ホンダ)と共同研究を進めている車載システムへの応用、凸版印刷が取り組む浅草観光案内、TBSテレビの世界陸上ロンドン公式バーチャルアシスタントなど多数のデモ展示を行った。

関連記事

開き直る人工知能 〜 「完璧さ」を捨てた故に進歩した稀有な技術

開き直る人工知能 〜 「完璧さ」を捨てた故に進歩した稀有な技術

音声認識技術に対して、長らく憎悪にも近い感情を抱いていた筆者ですが、最近の音声認識技術の進歩には目を見張るものがあります。当初は、とても使いものにはならなかったこの技術は、なぜそこまでの発展を遂げられたのか――。そこには、「音声なんぞ完璧に聞き取れるわけない!」という、ある種の“開き直り”があったのではないでしょうか。 力任せの人工知能 〜 パソコンの中に作る、私だけの「ワンダーランド」

力任せの人工知能 〜 パソコンの中に作る、私だけの「ワンダーランド」

私はこれまで、人口問題や電力問題、人身事故などさまざまな社会問題を理解するためにシミュレーションを利用してきました。シミュレーションは、AI(人工知能)という概念を飛び越えて、「人間が創造した神」と呼べるかもしれません。今回は、シミュレーションに最適なAI道具の1つとして、「オブジェクト指向プログラミング」を解説します。これは、PCの中に“私だけのワンダーランド”を力任せに作る技術ともいえます。 トヨタがNVIDIAのAI技術を採用、Intelに焦りか

トヨタがNVIDIAのAI技術を採用、Intelに焦りか

2017年5月10日、トヨタ自動車がNVIDIAのAI(人工知能)プラットフォームを採用する計画を明かした。自動車用AIプラットフォームを巡っては、Mobileye買収をするIntelと、NVIDIAが激しく競り合う。トヨタの採用でNVIDIAの優勢が明白になったが、勝敗の決着はまだ先のようだ。【訂正】 「みちびき」対応のGNSS受信機、1cmの精度を実現

「みちびき」対応のGNSS受信機、1cmの精度を実現

マゼランシステムズジャパンは、「CEATEC JAPAN 2017」で、1cm以下の精度で位置検出が可能なGNSS受信機を展示した。準天頂衛星システム「みちびき」に対応している。 AIで社会は良くなるか、それとも混乱するのか

AIで社会は良くなるか、それとも混乱するのか

ARMは、人工知能(AI)に関する意識調査を行った。将来はロボットの反乱で混乱するのか、それとももっと良い社会になるのか。 顔の表情や生体情報から、感情や眠気を推定

顔の表情や生体情報から、感情や眠気を推定

パナソニックは、人間の表情や生体情報から、感情や体調を瞬時に推定できる技術などを「CEATEC JAPAN 2017」で紹介した。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

タオルをつかんで折りたたむことができる生活支援用ロボットによるデモの模様

タオルをつかんで折りたたむことができる生活支援用ロボットによるデモの模様 VRによるロボットと人間の対話実験に向けたシミュレーターによるデモの模様

VRによるロボットと人間の対話実験に向けたシミュレーターによるデモの模様 Nextremerが行った移動マニピュレーターによるデモの模様

Nextremerが行った移動マニピュレーターによるデモの模様