1つのGPU/CPUで推論可能な超軽量LLM「tsuzumi」を24年3月から提供へ:学習コストは「GPT-3」の300分の1に(1/2 ページ)

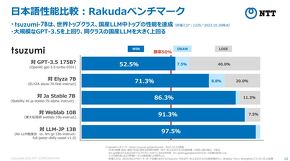

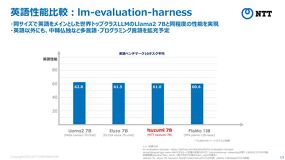

NTTが、独自開発した大規模言語モデル(LLM)「tsuzumi」を2024年3月から提供開始する。tsuzumiは、パラメーターサイズが6億または70億と軽量でありながら、世界トップクラスの日本語処理性能を持つLLMだ。

NTTは2023年11月、同社が独自開発した大規模言語モデル(LLM)「tsuzumi」を2024年3月から提供開始すると発表した。

tsuzumiのコンセプトについて、NTT 執行役員 研究企画部門長の木下真吾氏は「専門知識を持った、パラメーターサイズの小さなLLMの実現だ。tsuzumiは、パラメーターサイズを抑えつつ、言語学習データの質と量を向上させることで、軽量化と専門性を両立した」と語った。

専門知識を持った軽量LLM「tsuzumi」

tsuzumiは、パラメーターサイズが6億または70億と軽量でありながら、「世界トップクラス」(同社)の日本語処理性能を持つLLMだ。軽量なため、1つのGPUやCPUで推論動作が可能で、学習やチューニングに必要な時間やコストを軽減できるという。日本語/英語に対応する他、表が含まれる誓約書や契約書といった図表文書の視覚読解など、さまざまな形式にも対応できる。2024年4月以降は、言語化されていないグラフィカルな表示や音声のニュアンス、顔の表情などを理解するマルチモーダル対応や、日本語/英語以外の多言語対応、チューニングの高度版などを順次提供していく。

2022年11月にOpenAIが公開した「ChatGPT」の登場以降、LLMの開発競争は激化している。それに伴い、LLMの性能に関わるパラメーターサイズは爆発的に増加している。OpenAIのLLM「GPT」の初期モデルである「GPT-1」(2018年)のパラメーターサイズは1億1700万だったのに対し、「GPT-2」(2019年)では15億、「GPT-3」では1750億(2022年)と増加している。消費電力も膨大だ。GPT-3の1回の学習に必要な電力は1300MWhで、「原発1基の1時間分(1000MWh)に相当する」(NTT)という。

tsuzumiは、パラメーターサイズが70億の「軽量版」と、6億の「超軽量版」の2種類がある。NTTの試算では、学習コストをGPT-3規模のLLM(約4億7000万円)と比較した場合、軽量版では25分の1の約1900万円、超軽量版では300分の1の約160万円に低減で可能。同じく推論コストをGPT-3(約1500万円)と比較した場合、軽量版では20分の1の約70万円、超軽量版では70分の1の約20万円に低減できるという。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか