推論性能でNVIDIAに挑む AIチップは「省エネ」が競争の軸に:「MLPerf」の最新スコアを公開(1/4 ページ)

推論ベンチマーク「MLPerf」の最新ラウンドのスコアが公開された。その結果からは、AI用プロセッサの新たな競争の軸が、性能そのものよりも「電力効率」に移りつつあることが読み取れる。

AMDは、推論ベンチマーク「MLPerf」の最新ラウンドに、同社のデータセンター用GPUのフラグシップ製品である「AMD Instinct MI300X(以下、MI300X)」の結果を初めて提出した。同社は、市場リーダーであるNVIDIAの現世代ハードウェア「H100/H200」に匹敵する結果を達成したが、総合的にはNVIDIAがわずかな差で勝利した。

NVIDIAは、カナダのスタートアップ企業であるUntetherからも挑戦を受けた。Untetherは同社初となるMLPerfベンチマークを披露し、同社の「speedAI」アクセラレーターが「ResNet-50」ワークロードの電力効率において、NVIDIAのさまざまなチップを上回ったことを示した。GoogleもAI向けアクセラレーターチップ「Tensor Processing Unit(TPU)」の第6世代となる「Trillium」の結果を提出し、Intelは「Granite Rapids CPU」を初披露した。

AMDは「MI300X」のスコアを初めて提出

AMDは、NVIDIAのデータセンター向けGPUに対抗するMI300Xの結果を初提出し、「Llama2-70B」での推論におけるシングルチップおよび8チップシステムの性能を示した。シングルチップのMI300Xは、サーバモードで2520.27トークン/秒(token/s)、オフラインモードで3062.72トークン/秒の推論が可能で、8チップシステムのMI300Xは、サーバモードで21028.20トークン/秒、オフラインモードで23514.80トークン/秒を実行できる。この数字は、システムサイズ間のスケーラビリティがかなり直線的であることを示している(オフラインシナリオではバッチ処理によってスループットを最大化できるが、より難しいサーバシナリオではレイテンシの制限に対応したリアルタイムクエリをシミュレートする)

この結果は、NVIDIAの8チップシステムH100(80GB)で同じワークロードを処理した場合の結果と非常によく似ている(差は3〜4%)。NVIDIAのH200(141GB)(実質的に、より多くの高速メモリを搭載したH100)と比較すると、AMDは30〜40%遅くなっている。

AMDは、12チップレットのMI300X GPUをNVIDIAのH100に直接競合する製品と置付けていて、これはNVIDIAの市場独占に挑む最も有望な商用製品の一つとして広く期待されている。MI300Xは、NVIDIAのH100およびH200よりもHBM(広帯域幅メモリ)の容量と帯域幅が大きく(H200が141GB(ギガバイト)で4.8Tバイト/秒(TB/s)であるのに対して、MI300Xは192GBで5.2TB/s)、その差は大規模言語モデル(LLM)での推論結果に顕著に表れると思われる。AMDは、「192GBは1チップでLlama2-70Bモデル全体とKV(Key Value)キャッシュを保持するのに十分な容量で、これにより、モデルを複数のGPUに分割することによるネットワークオーバーヘッドを回避できる」と述べている。さらに、「MI300Xは、H100/H200よりもわずかにFLOPSが高い。H100と同等で、H200に後れを取っていることは、AMDファンを少し失望させるかもしれないが、これらの初期スコアは、ソフトウェアのさらなる最適化によって、次のラウンドで間違いなく改善される」とも説明した。

ソフトウェア面では、AMDは、「コンポーザブルカーネルライブラリを広範囲に使用して、プレフィルアテンションやFP8デコードページドアテンション、さまざまな融合カーネル向けにパフォーマンスクリティカルなカーネルを作成した」と述べている。また、デコードスケジューリングの高速化とプレフィルバッチ処理の改善のためにスケジューラも改善したという。

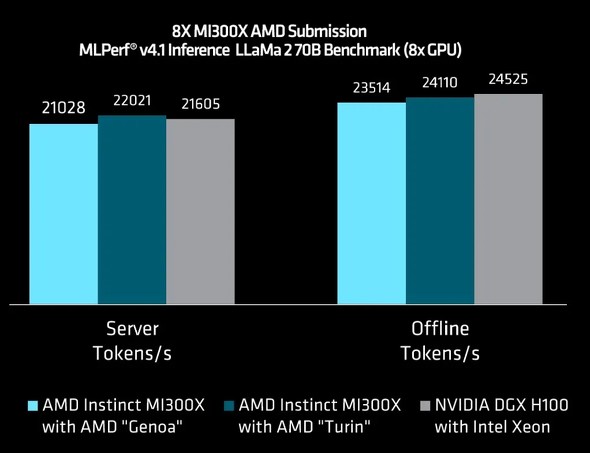

AMDはMI300Xと共に、次世代(第5世代)「EPYC」プロセッサである「Turin」も披露した。第4世代EPYCプロセッサである「Genoa」を搭載した同一システムと比較して、サーバモードで4.7%、オフラインモードで2.5%と性能改善はわずかではあるが、TurinベースのシステムをDGX-H100よりも若干高速化することができた。AMDのTurin CPUはまだ市場に投入されていない。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか