中堅研究員はAIの向こう側に何を見つけたのか:Over the AI ―― AIの向こう側に(23) 最終回(1/10 ページ)

約2年続いてきた本連載も、いよいよ最終回です。「中堅研究員はAIの向こう側に“知能”の夢を見るか」と名付けた第1回から2年間。筆者が“AIの向こう側”に見つけたものとは、何だったのでしょうか。

今、ちまたをにぎわせているAI(人工知能)。しかしAIは、特に新しい話題ではなく、何十年も前から隆盛と衰退を繰り返してきたテーマなのです。にもかかわらず、その実態は曖昧なまま……。本連載では、AIの栄枯盛衰を見てきた著者が、AIについてたっぷりと検証していきます。果たして”AIの彼方(かなた)”には、中堅主任研究員が夢見るような”知能”があるのでしょうか――。⇒連載バックナンバー

読者からのご指摘

前回、ニューラルネットワークの深層学習について、畳み込みネットワーク(Convolutional Neural Network : CNN)と、自己符号化(Auto Encoder:AE)の2つを取り上げ、「エロ」のパラダイムから解説を試みました。(http://eetimes.jp/ee/articles/1806/04/news030_5.html)

ところが、読者の方から、この記事の内容に対する批判を頂き、急ぎ、以下のようなコメントを掲載しました。

追記(2018年6月5日午後12時55分)

読者の方から、本記事のCNNについての誤りがあり「深層学習の前段部においてもバックプロパケーション学習は行なわれている」とのご指摘をいただきました。

大変申し訳ありませんが、 今回の、CNNについての内容については、現時点では『江端がウソを記載しているかもしれない』と疑っていただきますようお願い致します。

これより、いろいろと調べまして(ソースコードを読むなど)、来月(2018年7月)にその結果についてご報告致します。 ご迷惑をおかけしますが、次回掲載をお待ちいただけますよう、よろしくお願い致します。

<江端智一>

結論から申し上げますと、「ご指摘は正しい。江端はウソを記載した」となります。

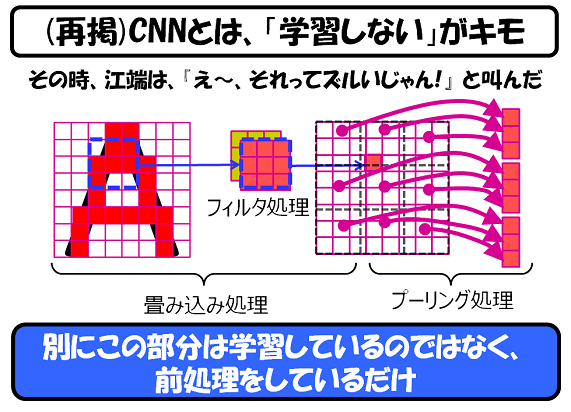

読者の方が指摘された部分は、前回掲載したこの図とその説明です。

今回問題となった記載は、上図の「前処理をしているだけ」の部分でした。

この1カ月間、私は書籍やネットで、CNNの、特に定式化について調べてみました。下記は、私が記載した手書きのメモの一部です。

実際のところ、まだ一部、私の頭の中では不明点(微分式への変換などで"?"と思う部分)がありますが、基本的にはCNN*1)は、全層だけでなくフィルターに至るまで、逆伝搬学習(バックプロパゲーション)*2)の対象となっており、数式として記述可能であることが分かりました。

*1)CNNの基本な考え方については、「官能の人工知能 〜深層学習を最も分かりやすく説明するパラダイム」をご覧ください。

*2)バックプロパゲーションについては、「不幸な人工知能 〜尊敬と軽蔑の狭間で揺れるニューラルネットワーク」をご覧ください。

Copyright © ITmedia, Inc. All Rights Reserved.