NVIDIAが解説するディープラーニングの基礎(後編):CNN/RNNやフレームワーク概要まで(2/5 ページ)

CNNの利点と応用領域

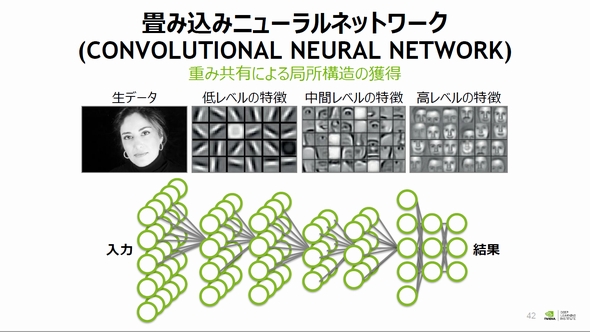

CNNの利点について、山崎氏は「重み共有による局所構造の獲得」を挙げ、さらに「もっと端的に言うと、入力データの中にどのような構造を持っているのか学習によって獲得することができる」と語る。

この点について、山崎氏はCNNを用いた人の顔画像を分類することを例として説明し、「入力層に近い(隠れ層の)重み係数を可視化すると、画像中の(幾何学的な)ある成分に反応するユニットができていることがある。(隠れ層が)出力層側に近くなるにつれて、顔のパーツに反応するユニットや顔のバリエーションに反応するユニットができていることもある」(山崎氏)とし、データ中にある特徴の抽出をさまざまなレベルで可能なことがCNNのメリットだとした。

CNNの応用として特に注目を集めている領域に、画像分類や物体検出、さらには画像内の物体を判定し、その位置や形状を推測するセマンティックセグメンテーション(領域分割)などがあるという。

リカレントニューラルネットワーク(RNN)

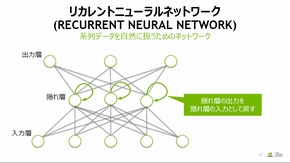

時系列データなど、前の情報がその次の情報に影響する連続的なデータの場合、ニューラルネットワークによる機械学習には「リカレントニューラルネットワーク(RNN:Recurrent neural network)」を用いることが一般的だ。RNNは、これまで扱った順伝播型ニューラルネットワークとは異なり、隠れ層の出力を再び隠れ層の入力として戻す「再帰型」のネットワーク構造をとる。

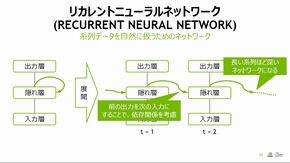

RNNでは「ある時刻(t = 1)のデータを入力し、隠れ層による処理を行った後、出力する。その次の時刻(t = 2)のデータ処理では、ある時刻(t = 1)の隠れ層にある情報を考慮してデータ処理を行う」(山崎氏)として、連続データの前後依存関係をうまく取り扱うことができるニューラルネットワークだと説明する。

また、連続データの系列が長くなるほどRNNは深いネットワーク構造となるため、山崎氏は「いわゆるディープラーニング的な文脈として(RNNの)学習をうまくやっていく必要がある」とする。一方で、長期の依存性を持つデータの場合では学習が困難なため「ピュアなRNNによる処理はあまり行われない」(山崎氏)と指摘する。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか