官能の人工知能 〜深層学習を最も分かりやすく説明するパラダイム:Over the AI ―― AIの向こう側に(22)(5/10 ページ)

手作り学習データでCNNを学んでみる

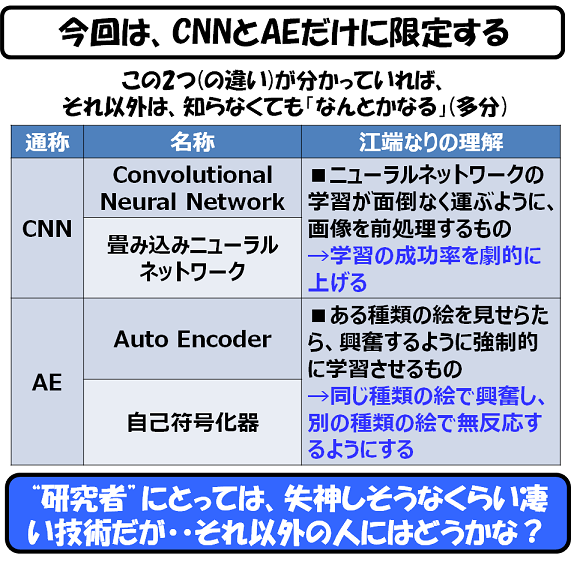

今回は、この教師あり学習としてCNN(Convolutional Neural Network:畳み込みニューラルネットワーク)を、教師なし学習としてAE(Auto Encoder:自己符号化)をご紹介します。

ニューラルネットワークには、いろいろありますが、前回の(1)階層型の層間全結合のニューラルネットワークと、この(2)CNNと(3)AEの3つさえ分かっていれば、おおむねニューラルネットワークは理解しているといっても良いでしょう。

では、CNNから解説します。

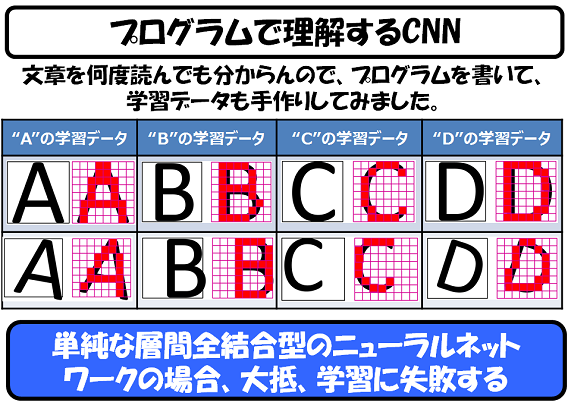

CNNについては、いろいろな文章を読みまくったのですが、どうにもよく分からなかったので、書籍やネットに記載されているプログラムをパクり……もとい、参照させて頂きながら、自分でプログラムを書いてみました(プログラムはこちら)。

学習データとしては、A,B,C,Dの4種類の文字を8つ用意しました。いくつかは文字の角度や大きさや場所を変えてみました。

前回、私は、XORという、線形では分離できない、簡単な4つの信号の学習を試みて、かなり頻繁な確立で学習に失敗することを示しました。

今回の入力データは、8x8=64ビットのデータを8つも学習させることになりますので、前回のような全結合型のニューラルネットワークを使って、逆伝搬学習(バックプロパゲーション)を試みれば、ほぼ確実に失敗することは分かっています。

文字認識は、ニューラルネットワークの代表アプリケーションと言えるもので、世の中の多くの論文で成功例の報告がありますが、大抵の場合、マグレで学習に成功したケースです(いわゆる、チャンピオンデータ、というやつです)。

まあ、マグレであれ何であれ、一度学習に成功してしまえば、そのニューラルネットワークはどこでも使うことができるようになりますので、それはそれで良いのです ―― が、結局のところ、マグレや設計者のセンスに依存するような技術は、結局使いものにならないのです。第2次AIブームのニューラルネットワークは廃れていったのは、こうした理由からでした。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCが熊本第2工場で3nm導入へ CEOが表明

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす