IBM、8ビット学習が可能なテストチップを発表:「ISSCC 2021」(1/2 ページ)

IBM Researchは、2021年2月13〜22日にオンライン開催された半導体業界最大級の国際学会「ISSCC 2021」において、テストチップを発表した。これは、同社が長年にわたり取り組んできた、低精度のAI(人工知能、ここでは機械学習)トレーニング/推論アルゴリズムを具現化したハードウェアだといえる。

低精度での学習/推論が可能に

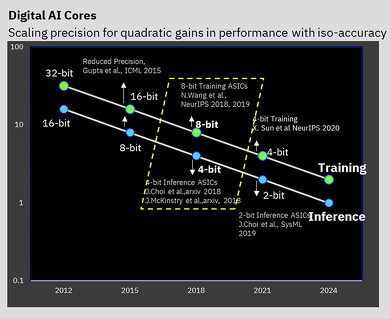

IBM Researchは、2021年2月13〜22日にオンライン開催された半導体業界最大級の国際学会「ISSCC 2021」において、テストチップを発表した。これは、同社が長年にわたり取り組んできた、低精度のAI(人工知能、ここでは機械学習)トレーニング/推論アルゴリズムを具現化したハードウェアだといえる。4コアを搭載し、7nmプロセスを適用したこのチップは、16ビットおよび8ビットのトレーニングだけでなく、4ビットおよび2ビットの推論もサポート可能だという(業界では現在、32ビットまたは16ビットのトレーニングと、8ビット推論が標準とされている)。

精度を低下させると、AI計算に必要とされる計算量や性能が大幅に低下する可能性があるが、IBMは、効率向上を実現することが可能なアーキテクチャ関連の秘策をいくつか用意しているという。そこで課題となるのが、計算結果にマイナスの影響を及ぼすことなく精度を低下させるという点だ。これは、IBMがこれまで長年にわたり、アルゴリズムレベルで進めてきた取り組みの1つである。

IBMは、2019年にAIハードウェアセンターを設立し、AI計算性能を毎年2.5倍に向上させることを目指してきた。最終的には2029年までに、電力性能比(FLOPS/W)を1000倍に高めるという野心的な目標を掲げている。

このような目標が必要とされた背景には、AIモデルのサイズや、そのトレーニングに必要な計算量が急激に拡大しているということがある。特に、自然言語処理(NLP)モデルは今や、1兆個規模の巨大なパラメータを持ち、その膨大な量のトレーニングに伴って排出される二酸化炭素排出量についても、見過ごすことはできない。

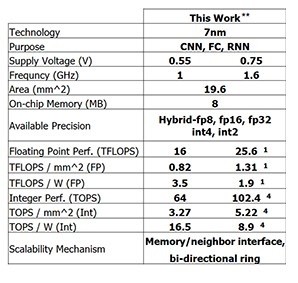

今回IBM Researchが発表したテストチップは、IBMがこれまでに実現してきた成果を示す存在だといえる。8ビットトレーニングに関しては25.6TFLOPSを実現し、4ビットの整数計算では102.4TOPSの推論性能を達成することが可能だ(クロック周波数が1.6GHz、供給電圧が0.75Vの場合)。クロック周波数を1GHz、供給電圧を0.55Vにそれぞれ下げると、電力効率を3.5TFLOPS/W(FP8)または16.5TOPS/W(INT4)に高められるという。

このような性能は、IBMが長年にわたり行ってきた、低精度トレーニングおよび推論技術に関するアルゴリズムの取り組みをベースとしている。IBM独自の8ビットハイブリッド浮動小数点フォーマット(Hybrid FP8)を初めてサポートすることが可能なチップである。Hybrid FP8は、機械学習分野の最高峰の国際会議である「NeurIPS(Neural Information Processing Systems) 2019」において初めて発表された。この新しいフォーマットは、特に8ビットトレーニングを可能にすることを目的として開発され、16ビットトレーニングに必要な計算性能を、マイナスの影響を与えることなく半減することが可能だ。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

IBM Researchが発表したテストチップの概要および性能 出典:IBM Research

IBM Researchが発表したテストチップの概要および性能 出典:IBM Research