EE Times Japan >

LSI >

シングルプロセッサで200億パラメーターを持つAIモデルを学習:Cerebrasのウエハースケールエンジン(2/3 ページ)

» 2022年07月08日 13時30分 公開

[Sally Ward-Foxton,EE Times]

ウエハーサイズプロセッサの能力

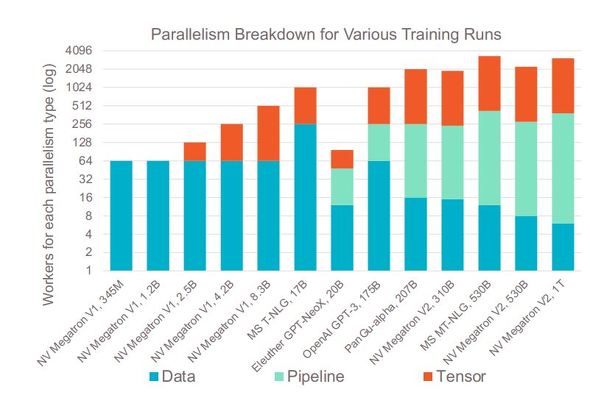

Cerebrasの発表にあるGPT-NeoX 20Bのような巨大モデルは、トレーニングに3種類全ての並列処理が必要になる。

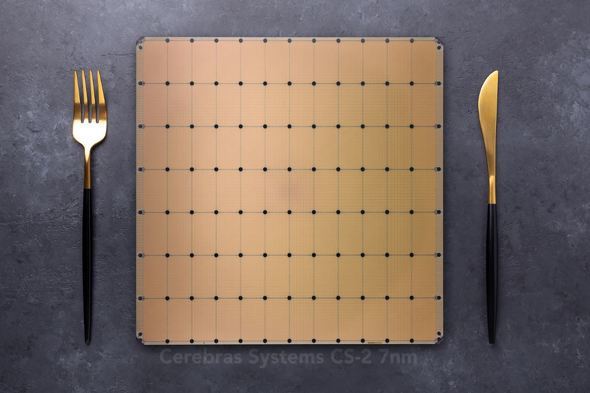

Cerebrasの「CS-2」は、プロセッササイズが非常に大きく(ウエハーサイズの単一チップ上に85万個のコアを集積した巨大プロセッサで、最大のネットワーク層にも十分な大きさ)、メモリと演算が分離されているため、モデルを並列化する必要がない。システムの演算部分のアーキテクチャは同じままで、演算を追加せずにメモリを追加して、より多くのパラメーターをサポートすることができる。

並列処理を利用する必要がないため、マルチプロセッサシステムで実行するためにモデルを手動で分割する時間とリソースを費やす必要がない。さらに、プロセスのカスタムパートがないため、モデルの移植が可能である。複数のパラメーターを持つGPTモデル間の変更は、1つのファイル内で4つの変数を変更するだけでできる。同様に、「GPT-J」と「GPT-Neo」の変更も、キーを数回押すだけでできる。Cerebrasによると、これによって数カ月分のエンジニアリング時間を削減できるという。

Copyright © ITmedia, Inc. All Rights Reserved.

Special ContentsPR

特別協賛PR

スポンサーからのお知らせPR

Special ContentsPR

Pickup ContentsPR

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- 村田製作所は増収減益、米Resonantのれん438億円減損

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

Special SitePR

あなたにおすすめの記事PR