日本語精度が高い130億パラメーターのLLMを開発:企業ごとのカスタマイズも容易

リコーは、日本語の精度が高い130億パラメーターの「大規模言語モデル(LLM)」を開発した。顧客の業種や業務に合わせたカスタムLLMを2024年春より順次、クラウド環境で提供する。

「学習に利用するコーパスの選定」など、独自工夫を盛り込む

リコーは2024年1月、日本語の精度が高い130億パラメーターの「大規模言語モデル(LLM)」を開発したと発表した。顧客の業種や業務に合わせたカスタムLLMを2024年春より順次、クラウド環境で提供する。

リコーが開発したLLMは、Meta Platforms製「LLM Llama2-13B」をベースに、日本語と英語のオープンコーパスを追加学習させた。「学習に利用するコーパスの選定」や、「誤記や重複の修正などのデータクレンジング」「学習データの順序や割合を最適化するカリキュラム学習」など、リコー独自の工夫を盛り込んでいる。

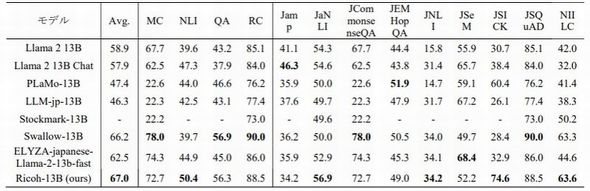

学習の結果、特にNLI(自然言語推論能力)に優れているという。日本語ベンチマークツール(llm-jp-eval)を用い、日本語LLMの性能を主なLLMモデルと比較したところ、リコーのLLMは評価スコアの平均値が最も高い(2024年1月4日現在)ことを確認した。

顧客は、リコーのLLMに独自の情報や知識を取り入れることで、それぞれの業務に適した独自のカスタムLLMを、短期間で容易に構築できるという。同LLMは、「AWS LLM開発支援プログラム」でサポートされており、「AWS Trainiumアクセラレーター」を搭載したAmazon Elastic Compute Cloud Trn1インスタンスを利用できる。これにより、従来手法による開発に比べ、「45%のコスト低減」や「12%の開発期間短縮」が可能となる。

関連記事

1つのGPU/CPUで推論可能な超軽量LLM「tsuzumi」を24年3月から提供へ

1つのGPU/CPUで推論可能な超軽量LLM「tsuzumi」を24年3月から提供へ

NTTが、独自開発した大規模言語モデル(LLM)「tsuzumi」を2024年3月から提供開始する。tsuzumiは、パラメーターサイズが6億または70億と軽量でありながら、世界トップクラスの日本語処理性能を持つLLMだ。 「LLMの巨大化」が生成AIのボトルネックに

「LLMの巨大化」が生成AIのボトルネックに

急成長が予想されている生成AI(人工知能)においてボトルネックとなるのは、LLM(大規模言語モデル)の巨大化、つまりパラメーター数の増加だという。SambaNova Systemsなどが、こうしたボトルネックについて語った。 たった2枚の画像で高度な判定、汎用外観検査AI

たった2枚の画像で高度な判定、汎用外観検査AI

岐阜大学は、2枚の画像データだけでも高度な判定が可能な「汎用外観検査AI」を開発した。種類が異なる製品の検査も、1つのAIで行うことができる。このため、生産現場に導入するコストや期間を大幅に削減することが可能となる。 国産の生成AI/基盤モデルの開発へ、経産省が講演

国産の生成AI/基盤モデルの開発へ、経産省が講演

経済産業省 商務情報政策局 情報産業課 ソフトウェア・情報サービス戦略室 企画官の小川宏高氏は、「EdgeTech+ 2023」のセミナーに登壇し、生成AIを中心に、日本の半導体・デジタル産業戦略について語った。 半導体設計をサポートするLLMを開発したNVIDIA

半導体設計をサポートするLLMを開発したNVIDIA

NVIDIAが半導体設計に関する一般的な質問への回答、バグドキュメントの要約、EDAツール用スクリプトの作成など、半導体設計に関連するタスクを支援する大規模言語モデル(LLM)である「ChipNeMo」を開発した。 「世界トップレベルの日本語性能」、NECの独自LLM

「世界トップレベルの日本語性能」、NECの独自LLM

NECが、軽量でありながら「世界トップレベルの日本語性能」(同社)を有する独自LLM(大規模言語モデル)を開発した。同社は2023年7月から法人向けの生成AIサービスを順次提供し、3年で売上高500億円を目指すという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング