embedded world 2025開幕、Altera CEOが語るエッジAIの展望:「ありとあらゆるところにAI」の時代(2/2 ページ)

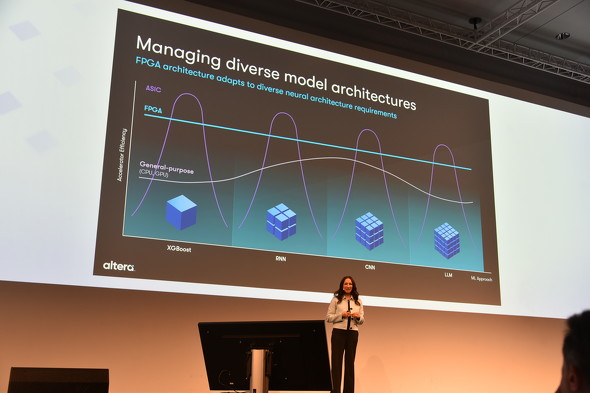

ASIC、汎用プロセッサとFPGAの比較

Rivera氏は、現在AIワークロードを高速化するために使用される選択肢は、GPUやCPUなどの汎用プロセッサ、カスタムASIC、FPGAの3つだと説明。GPUやCPUなどは汎用性と導入のしやすさから、AIワークロードの高速化のため広く利用されている。「特にGPUはベクトル処理機能によって、科学計算、画像処理、シミュレーションなどのAIタスクを高速化するのに非常に効率的だ」(同氏)。カスタムASICは、特定のAIタスクに最適化され高効率を実現する一方、それ以外のケースでは効率が低下する。FPGAは「FPGAの本来の高性能アーキテクチャと柔軟性によって、ユーザーは特定のAIタスクに合わせてハードウェアを最適化できる」ことから、さまざまなニューラルアーキテクチャにわたって比較的一貫した効率を提供可能、とそれぞれの利点について語った。

特にFPGAについては「多くの場合、カスタマイズによって、汎用的なオプションよりも高いパフォーマンスと改善された電力効率が得られる。企業にとって、これは総運用コストの削減を意味する。ASICのような固定機能アクセラレーターと比較すると、FPGAは再プログラム可能なため、ユーザーはシステム要件の進化に合わせてシリコンを再構成できる。エッジユースケースの場合、FPGAは、小型フォームファクタなどから、より大きなフットプリントまでカスタマイズできるスケーラブルなプラットフォームを提供可能だ」と強調。さらに、ライフサイクルが長いといった利点も挙げた。

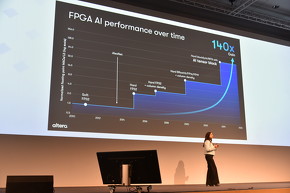

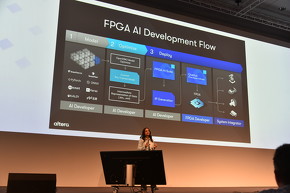

そのうえで同氏は、AI処理に最適化した「AI Tensor」ブロックを備えたファブリックを使用し、エッジの組み込みアプリケーションに展開されたモデルに対して低遅延のリアルタイム処理が可能となることなど、Alteraの最新FPGAおよび迅速な開発をサポートするソフトウェアやエコシステムサポートついて紹介していた。

3つの重要な発展

Rivera氏は「われわれは、AIの可能性を真に理解し始めたばかりだ」としつつつ、既に3つの重要な発展がみられるとまとめた。1つはアクセス性と低価格化で、「クラウドまたはインテリジェントエッジのAIインフラストラクチャは、膨大な量のデータをほぼリアルタイムで処理するために、すぐに利用可能だ。FPGAなどの追加の選択肢によって、可用性と低価格化はより向上される」とした。2つ目はデータへのアクセス向上とAIモデルの改善で、「AIシステムは、多様で高品質なデータによって成長する。現在、推定400億台を超えるデバイスが、毎日4億テラバイトを超えるデータを収集している。このデータと高度なAIモデルのブレークスルーを組み合わせることで、AIは現実世界のアプリケーションにさらに適応しやすくなるだろう」と説明した。

そして最後に、人々の日常生活へのAI統合が進んでいることを挙げ、「スマートフォン、ウェアラブル、自動車には既にAI機能が組み込まれている。より多くのデバイスに高度なインテリジェンスが統合されるにつれ、デバイスとシステムがリアルタイムデータに基づいて決定を下すシームレスな体験が実現されるだろう」と期待を示していた。

関連記事

10億パラメータモデルがエッジで動く Armの新プラットフォーム

10億パラメータモデルがエッジで動く Armの新プラットフォーム

Armは、エッジAI向けに最適化した「Armv9」ベースのプラットフォームを発表した。コンパクトなプロセッサコア「Cortex-A320」と、NPU(Neural Processing Unit) IP(Intellectual Property)「Ethos-U85」で構成されるもので、10億パラメータのAIモデルを実行可能だという。 「エッジAIを再定義」 NXP、米新興Kinaraを3億ドルで買収

「エッジAIを再定義」 NXP、米新興Kinaraを3億ドルで買収

NXP Semiconductors(以下、NXP)は、米国カリフォルニア州シリコンバレーのエッジAIチップスタートアップであるKinaraを3億700万米ドル(約465億円)の現金で買収した。Kinaraが得意とするマルチモーダルトランスフォーマーネットワークを生かし、エッジデバイスとの「人間のようなやりとり」を目指す。 AIアルゴリズムを動かしながら監視を支援 車載用レーダーセンサー

AIアルゴリズムを動かしながら監視を支援 車載用レーダーセンサー

日本テキサス・インスツルメンツ(日本TI)は、より安全で快適な運転環境の実現に向けた「統合型車載チップ」を発表した。60GHzミリ波レーダーセンサー「AWRL6844」、オーディオDSPコアを搭載したマイコン「AM275x-Q1」とプロセッサ「AM62D-Q1」および、Class-Dオーディオアンプ「TAS6754-Q1」である。 エッジAIにも使える無線マイコン ノルディック「nRF54」

エッジAIにも使える無線マイコン ノルディック「nRF54」

ノルディック・セミコンダクターは、2024年12月に開催された「第7回スマートハウス EXPO」で、最新世代のマルチプロトコルSoC(System on Chip)「nRF54」シリーズや、既存のSoCを使ったMatterのデモなどを展示した。nRF54のハイエンド品は、エッジAI(人工知能)にも使うことができる。 ザインがエッジAI開発支援を強化、ワンストップで

ザインがエッジAI開発支援を強化、ワンストップで

ザインエレクトロニクスは2024年12月9日、エッジAI機器開発に必須となるハードおよびソフトをまとめて提供する新たな「ワンストップ・ソリューション」の提供開始を発表した。画像データの高速伝送や画像処理をはじめとした独自技術/ノウハウを生かしサービスを展開、さらなる事業拡大を図る。 AI処理性能が従来の600倍に 独自NPU搭載のSTM32マイコン

AI処理性能が従来の600倍に 独自NPU搭載のSTM32マイコン

STマイクロエレクトロニクスは、組み込みAI(人工知能)に向けたマイコンの新製品「STM32N6」を発表した。独自設計のNPU「Neural-ART アクセラレーター」を搭載し、既存のハイエンドマイコン「STM32H7」と比べてAI処理性能は600倍に向上した。CPUコアは最大動作周波数800MHzのArm Cortex-M55を搭載し、STM32マイコンとして史上最高の性能を実現しているという。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- TIがSilicon Labsを75億ドルで買収する理由

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- TSMCが熊本第2工場で3nm導入へ CEOが表明

- IDT買収から7年、ルネサスがタイミング事業をSiTimeに売却

- 「何でもできるが誰にも使えない」――自作MASが突きつけた現実

- ソニー半導体、3Qは過去最高 通期予想もさらに上方修正