AIサーバラックへの電力供給は1台当たり1MW超に 高効率化で備えるInfineon:SiC/GaNも活用(1/3 ページ)

AIの需要増加で、ネットワーク上のデータ量は急速に増加している。2010年から2025年の15年間で、データ量は145倍になる見込みだ。チップ性能の向上で、計算量も指数関数的に増加していて、シングルプロセッサの電力需要は3〜4カ月ごとに倍増している。これに伴い、AIデータセンターによる送電網への負担、コスト、堅牢性/信頼性が重要な課題となっている。これに対しInfineon Technologiesは、AIデータセンター向けの電力供給システムの開発を進めている。

生成AIをはじめとするAIの需要増加で、ネットワーク上のデータ量は急速に増加している。NCTA/Thrive Global/IDC/UBSによると、2010年から2025年の15年間で、データ量は145倍になる見込みだ。チップ性能の向上で、計算量も指数関数的に増加していて、OpenAIとCSET Georgetownによるとシングルプロセッサの電力需要は3〜4カ月ごとに倍増。これに伴い、AIデータセンターによる送電網への負担、コスト、堅牢性/信頼性が重要な課題となっている。

これに対し、Infineon Technologies(以下、Infineon)は、AIデータセンター向けの電力供給システムの開発を進めている。同社の日本法人であるインフィニオン テクノロジーズ ジャパン(以下、インフィニオン)は2025年7月、メディア向けの説明会を開催した。

進化していくAIサーバラックの構成

インフィニオン バイスプレジデント 経営戦略室 室長 兼 社長補佐の後藤貴志氏は「Infineonは、エネルギー効率の改善、電力密度向上、システム全体の堅牢性の向上、垂直統合した製造フローによる品質と供給量の安定を図ることで、送電網への負担、コスト、堅牢性/信頼性の課題に対応する」と説明する。

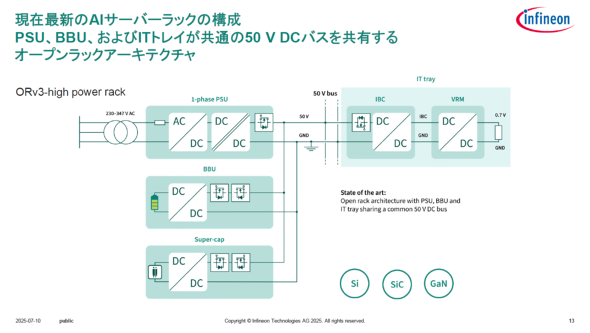

現在の最新AIサーバラックの構成は下図のようになっている。まず、外部から供給される200〜400V程度の交流電力を、電力供給ユニット(PSU)で50Vの直流電力に変換する。その後計算処理などを行うITトレイに電力が供給され、ITトレイ内でもさらに中間バスコンバーター(IBC)や電圧レギュレーターモジュール(VRM)で電圧を下げてGPUなどに電力を供給する。これに加え、停電などに備えるバッテリーバックアップユニット(BBU)やスーパーキャパシターも含めてAIサーバラックが構成されている。

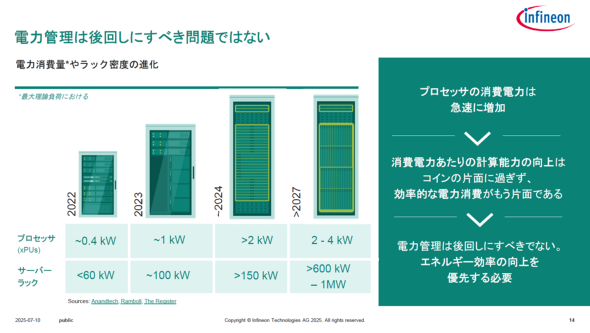

消費電力の増加で、この構成が変化すると見込まれる。PSUの容量を大きくする必要が出てくるからだ。プロセッサ1個当たりの消費電力は2022年には0.4kW程度、サーバラック1台当たりでは60kW程度だったが、2027年にはプロセッサ1個で2k〜4kW、ラック1台では600k〜1MWにも達すると予想されている。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

インフィニオン バイスプレジデント 経営戦略室 室長 兼 社長補佐 後藤貴志氏

インフィニオン バイスプレジデント 経営戦略室 室長 兼 社長補佐 後藤貴志氏