組み込みAIを加速する、ルネサスの新Processing-in-Memory:低電力で高速な推論を実現する(1/4 ページ)

ルネサス エレクトロニクスは、メモリ回路内でメモリデータの読み出し中に積和演算を行う既存のProcessing-in-Memory(PIM)を改良した、新たなPIM技術を開発したと発表した。同技術をベースに開発したAIアクセラレーターをテストチップに実装して推論処理を行ったところ、8.8TOPS/Wの電力効率を実証したという。

メモリ回路内で積和演算を行う「PIM」

ルネサス エレクトロニクス(以下、ルネサス)は2019年6月13日、メモリ回路内でメモリデータの読み出し中に積和演算を行う既存のProcessing-in-Memory(PIM)を改良した、新たなPIM技術を開発したと発表した。現在、京都で開催されている国際学会「2019 VLSI技術/回路シンポジウム」(2019年6月9〜14日)にて発表されたもの。

ルネサスは、組み込み機器などのエンドポイントで推論を行う「e-AI(embedded AI)」を成長戦略の一つとして掲げ、e-AIに向けた技術開発を進めている(関連記事:「ルネサス MCU/MPUのAI処理性能を今後3年で1000倍に」)。e-AIでは、いかに低消費電力で高速に推論を行えるかが鍵だが、PIMはそれを実現する技術の一つである。

ルネサスは、今回発表した新しいPIM技術をベースに、低消費電力で高速にCNN(Convolutional Neural Network)処理するAIアクセラレーターを開発。このアクセラレーターをテストチップに実装して推論処理を行ったところ、8.8TOPS/Wの電力効率を実証したという。さらに、手書き文字認識(MNIST)で評価した結果、99%以上の認識率を保ちつつ、「世界最高レベルの電力効率も達成した」(同社)とする。

既存のPIMには幾つかのタイプがあるが、ルネサス インダストリアルソリューション事業本部 e-AI事業推進室の主幹技師である野瀬浩一氏によれば、プロセスの制約がなく幅広い用途に使えるとして、SRAM型の単位構造をベースにしたという。

野瀬氏は、「デジタル回路では、ニューラルネットワークで求められる大量の積和演算を行うために、メモリからデータをCPUなどに読み出してきて、そこで演算し、計算結果をメモリに返すという一連の処理が発生する。これらの処理には電力が必要なので、消費電力がどうしても大きくなってしまうというのが、AIチップの共通した課題だ」と語る。PIMは、演算器とメモリ間のやりとりを極力減らすという技術だ。演算電力の他、メモリアクセスやデータの移動に伴う電力も抑えられる。

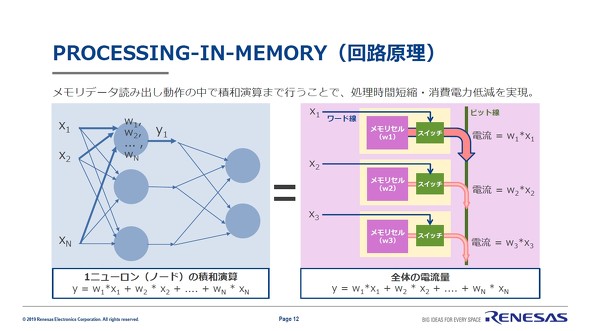

上の図は、既存のPIMにおけるニューラルネットワークの演算方法を示している。図の左は基本的なニューラルネットワークの処理を簡易的に示したもの。入力データ(x)に重みデータ(w)をかけて、それらの値(y)を足す。図の右はその処理をメモリ読み出し動作で模擬したものだ。

ルネサスが開発したPIMでは、「メモリセルに保存された重み係数の情報(w1, w2など)に応じた電流を出力するかどうかを、入力データの値で制御する」という動作が行われる。入力データが「0」なら電流を流さない、「1」なら流す、というのを、メモリセルの隣にあるスイッチで制御するのだ。

この動作は、「入力データの値とメモリセルの値を掛け算する」という動作になる。つまり、ニューラルネットワークにおける「入力データに重みデータをかける」という動作に相当する。その後、複数のセルを同じビット線につなげて、電流の和を算出すれば、ニューラルネットワークと同じ計算プロセスを行っていることになる。

ただ、こうした既存のSRAM構造のPIMには課題があると野瀬氏は述べる。メモリセル、スイッチともに1ビットが基本なので、1ビットの演算しかできないということだ。「1ビットの演算でもニューラルネットワークを処理するバイナリーニューラルネットワークもあるが、やはり画像認識などの精度が大幅に低下してしまう」(野瀬氏)。また、プロセスのばらつきが積和演算結果に影響するという問題もある。

ルネサスが新たに開発したPIMは、これらの課題を解決したものだ。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか