「Cooper Lake」やAI向け新FPGAを発表 Intel:AI戦略を強化

Intelは2020年6月18日(米国時間)、データセンター向けAI(人工知能)戦略の一環として、この市場に特化したCPU「Cooper Lake」や、専用AIエンジンを搭載した新FPGA「Stratix 10 NX」などを発表した。

Intelは2020年6月18日(米国時間)、データセンター向けAI(人工知能)戦略の一環として、この市場に特化したいくつかのデバイスを発表した。具体的には、第3世代の「Xeon Scalable CPU」や、専用AIエンジンを搭載した新FPGA「Stratix」、新しい「Optane」パーシステントメモリ、NAND SSDなどである。半年前にデータセンターに特化したAIアクセラレータを手掛けるイスラエルのHabana Labsを買収して以降初めて、データセンター向けAI戦略に光明を投じた形となった。

bfloat16に対応した「Cooper Lake」

Intelは、データセンター向けのフラグシップ製品であるXeon Scalable CPUシリーズの第3世代の第1版として「Cooper Lake」を発表した。14nmプロセスを適用した製品となる。

Xeon Scalableプロセッサはこれまでに3500万個以上が採用されている。前世代(第2世代、開発コード名は「Cascade Lake」)では、ディープラーニングなどの演算性能を向上する新しい命令セット「AVX(Advanced Vector Extension)-512」に拡張命令を追加した「DL(Deep Learning) Boost」が導入された。これによってINT8での演算性能が従来(3つの命令が必要)に比べて約3倍に向上する。

Cooper Lakeは、Googleの推論向けフォーマット(浮動小数点)「bfloat16(BF16)」をサポートしている。BF16は、計算効率と予測精度のバランスに優れていて、AIトレーニングの標準規格になりつつある。今回のDL Boostのアップデートによって、BF16とベクトルニューラルネットワーク命令(VNNI)のx86でのサポートを「業界で初めて」(Intel)実現した。

IntelのXeon and Memory Groupでコーポレートバイスプレジデント兼ゼネラルマネジャーを務めるLisa Spelman氏は、「BF16の優れた点の1つは、顧客によるソフトウェアの変更の必要性を最小限に抑えられることである。これにより、AI性能の向上において障壁となり得る、ソフトウェアへの膨大な変更作業なしに、トレーニングと推論の両方でハードウェアの効率を向上させることができる」と説明している。

Intelの発表によると、Cooper Lakeの画像分類のトレーニング性能は第2世代と比べて最大1.93倍、推論性能は1.87倍だという。自然言語処理トレーニングでは、前世代の1.7倍の性能になるとする。

この他、第2世代から継承された機能として、特定コアのベース周波数とターボ周波数を動的にコントロールして優先度の高いワークロードの性能を最大化する「Speed Select」がある。

AI用エンジンを搭載した「Stratix 10」

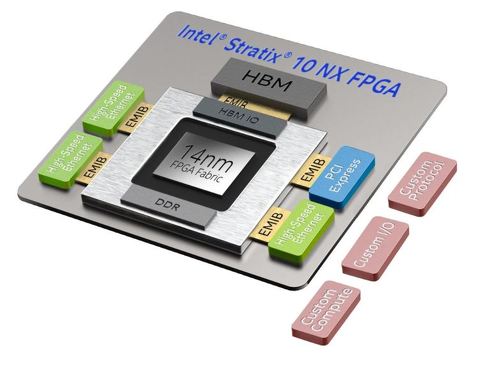

AI処理に最適化した新しいFPGA「Stratix 10 NX」も発表した。ニューラルネットワーク処理に特化した新しいエンジン「AI Tensor Block」が搭載されている。これによって、現行世代の「Stratix 10 MX」に比べ、INT8演算の性能が最大15倍に向上するという。

IntelでProgrammable Solutions Groupのコーポレートバイスプレジデント兼ゼネラルマネジャーを務めるDavid Moore氏は、「AI Tensor Blockの設計は、AIアプリケーションの高速化にフォーカスしている。特に、AIアプリケーションで一般的に使用されている低精度の整数および浮動小数点フォーマットで、高効率のTensorパイプラインを最適化している」と説明する。「これらの技術革新により、当社の標準的なDSPコンピュートブロックと同じ面積に、15倍の性能のコンピュートブロックを搭載できるようになった。Stratix 10 NXにはAI Tensor Blockが数千個搭載されているので、最も要求の厳しいAIアプリケーションでリアルタイムの性能を提供できるようになる」(同氏)。Stratix 10 NXは2020年後半に出荷される予定だ。

【翻訳:滝本麻貴、編集:EE Times Japan】

関連記事

Intel、3D積層技術Foveros採用の「Lakefield」を発表

Intel、3D積層技術Foveros採用の「Lakefield」を発表

Intelは2020年6月10日(米国時間)、10nmプロセスを採用した同社のノートPC向けSoC(System on Chip)「Lakefield(開発コード名)」として「Intel Core processors with Intel Hybrid Technology」を発表した。 Intelが3つの次世代パッケージング技術を明らかに

Intelが3つの次世代パッケージング技術を明らかに

Intelは、米国カリフォルニア州サンフランシスコで2019年7月9〜11日の日程で開催されている「SEMICON West 2019」に合わせて行われたイベントにおいて、3種類のパッケージング技術に関する同社のロードマップを初めて明らかにした。 2019年半導体企業売上高ランキング、トップにIntel

2019年半導体企業売上高ランキング、トップにIntel

英国の市場調査会社Omdia(旧IHS Markit)は2020年4月、2019年の世界半導体企業売上高ランキングを発表した。メモリ不況の影響などによって市場全体がマイナス成長となった中で、多角化戦略を進めるIntelが順調に売り上げを伸ばし、トップに返り咲いた。 10nmで苦戦するIntel、問題はCo配線とRuバリアメタルか

10nmで苦戦するIntel、問題はCo配線とRuバリアメタルか

Intelは2016年以降、今日に至るまで、10nmプロセスを立ち上げることができていない。一方で、配線ピッチは同等であるはずの、TSMCとSamsung Electronicsの7nmプロセスは計画通りに進んでいる。ではなぜ、Intelは10nmプロセスの立ち上げに苦戦しているのだろうか。 Intel、NervanaのAIチップ開発を打ち切りへ

Intel、NervanaのAIチップ開発を打ち切りへ

漠然とではあるが推測されてきた通り、IntelがNervanaのデータセンター向けAI学習用チップ「NNP-T」ならびに推論チップ「NNP-I」を打ち切った。最近買収したHabana Labs(以下、Habana)のチップ「Gaudi」と「Goya」の方を選択したとみられる。 世界半導体市場、2020年は3.3%プラス成長と予測

世界半導体市場、2020年は3.3%プラス成長と予測

WSTS(World Semiconductor Trade Statistics:世界半導体市場統計)は2020年6月9日、2020年春季の世界半導体市場予測を発表した。それによると、2020年の世界半導体市場は、メモリ市況の回復によって前年度比3.3%増となるという。さらに、2021年も同6.2%増となると予測。新型コロナウイルス感染症(COVID-19)によって先行きが不透明な状況であるものの、2年連続のプラス成長を見込む結果となっている。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか

Stratix 10 NXの概要 出典:Intel

Stratix 10 NXの概要 出典:Intel