NVIDIAの「GPU祭り」はまだ序章? 生成AIブームは止まらない:湯之上隆のナノフォーカス(76)(1/5 ページ)

NVIDIA製GPUの需要が高まる“GPU祭り”は、今後どうなっていくのだろうか。本稿では、AI(人工知能)サーバの出荷台数のデータを読み解きながら、NVIDIAの“GPU祭り”の行く末を予想する。

NVIDIAの“GPU祭り”は終わるのか

2022年11月30日に米Open AIがChatGPTを公開して以降、生成AI(人工知能)が大ブームとなり、AI半導体としてNVIDIAのGPUが引っ張りだこになった。しかしGPUの生産において、TSMCの中工程とDRAMを積層した広帯域メモリ(HBM)の2つがボトルネックとなっていたため、世界的にGPUの供給不足が続いていた(拙著『NVIDIAのGPU不足は今後も続く ボトルネックはHBMとTSMCの中工程か』、2024年5月7日)。

そのGPUの中でも特に「H100」の需要が大きく、価格が4万米ドルに高騰し、そのありさまはNVIDIAの“GPU祭り”などといわれていた。

そのような中で、TSMCが中工程のインターポーザのキャパシティを倍増し、SK hynixなどのDRAMメーカーがHBMを増産したことにより、「H100」のリードタイムが52週から20週に短縮されたという(参照:Digitimes)。

すると、NVIDIAの“GPU祭り”は終わるのだろうか?

そこで本稿では、今後、NVIDIAの“GPU祭り”が終わりに向かうのか否かを論じる。結論を先に述べると、ChatGPTクラスの生成AIの開発や稼働に必要なハイエンドAIサーバ(この定義は後述する)は、2024年時点でも全サーバの3.9%しか出荷されない見通しである。従って、米Google、米Amazon、米Microsoftなどのクラウドサービスプロバイダー(Cloud service provider、CSP)の需要は全く満たせていないと考えられる。要するに、これまでのNVIDIAの“GPU祭り”は序章にすぎず、本格的な生成AIブームはこれから到来するということである。

以下では、まず、NVIDIAのGPUの2つのボトルネックについて、簡単におさらいする。

NVIDIAのGPUの2つのボトルネック

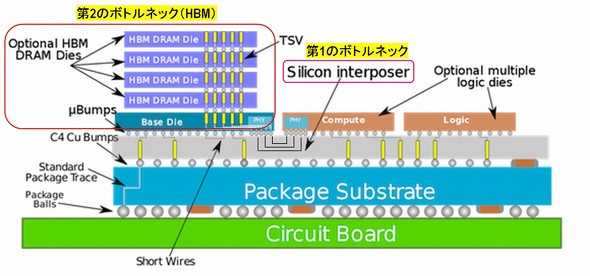

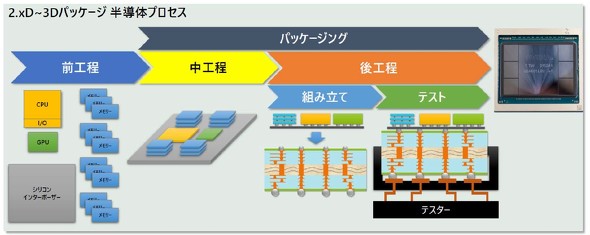

NVIDIAのGPUの生産においては、ファウンドリーのTSMCが前工程、中工程、後工程の全てを行っている。ここで、中工程とは、GPU、CPU、HBMなどのチップを別々に生産し、これらを12インチシリコンウエハーから切り出した角型の基板に配置する工程のことである。そして、この基板をシリコンインターポーザと呼んでいる(図1)。

図1 NVIDIAのGPUなど、2.5D〜3Dで出現する中工程[クリックで拡大] 出所:亀和田忠司、『次世代半導体パッケージング・実装技術動向と市場展望』、サイエンス&テクノロジー主催のセミナー、2024年2月6日のスライド

図1 NVIDIAのGPUなど、2.5D〜3Dで出現する中工程[クリックで拡大] 出所:亀和田忠司、『次世代半導体パッケージング・実装技術動向と市場展望』、サイエンス&テクノロジー主催のセミナー、2024年2月6日のスライドまた、TSMCが開発したNVIDIAのGPU用のパッケージをCoWoS(Chip on Wafer on Substrate)と呼ぶが、この中で、シリコンインターポーザのキャパシティとHBMの2つがボトルネックとなっていた(図2)。その事情は次の通りである。

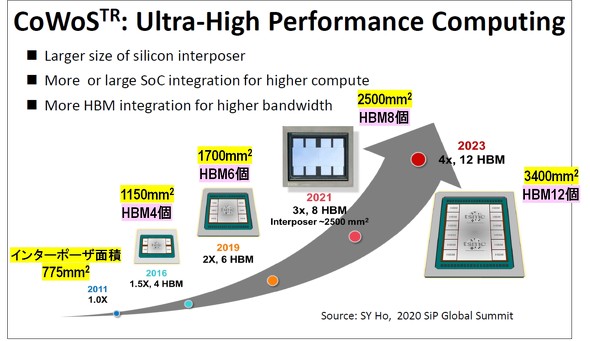

CoWoSが開発されたのは2011年であるが、その後、GPUの高性能化に伴って、GPUチップサイズが巨大化し、またGPUに搭載されるHBMの個数も増大していった(図3)。その結果、シリコンインターポーザが年々大型化し、それに反比例して1枚のウエハーから取得できるインターポーザ数が減少した。

図3 世代とともに増大するインターポーザ面積およびHBM搭載数[クリックで拡大] 出所:K C Yee(TSMC), ” Advanced 3D System Integration Technologies”, IEDM SC1, December 13, 2020

図3 世代とともに増大するインターポーザ面積およびHBM搭載数[クリックで拡大] 出所:K C Yee(TSMC), ” Advanced 3D System Integration Technologies”, IEDM SC1, December 13, 2020加えて、GPUに搭載するHBM数も増大する上、HBM内に積層するDRAMチップ数も増えていった。さらに、そのDRAMは2年で微細化を推進するとともに、HBMも2年周期で高性能化を図るために規格が更新されてきた。このようなことから、最先端のHBMが供給不足となっていた。

そのような中で、TSMCがシリコンインターポーザのキャパシティを、2023年夏頃の月産1.5万枚から、ことし夏ごろに月産3万枚以上に倍増させた。また、SK hynixがリードしていた最先端のHBMについても、Samsung ElectronicsやMicron TechnologyがNVIDIAの認定を取得し、供給を開始し始めた。

以上の効果によって、最も需要が大きいNVIDIAの「H100」のリードタイムが、52週から20週に、大幅に短縮されたわけである。では、それによって、AIサーバの出荷はどのくらい増えたのか?

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか