AIで重要性増す「カスタムHBM」、Marvellが製品群を強化:データセンター事業が好調(1/2 ページ)

Marvell Technologyがデータセンター向け事業で快進撃を続けている。同社は2024年12月に開催されたアナリストデーで、データセンター事業の内容を紹介した他、カスタムHBMの必要性を強調した。

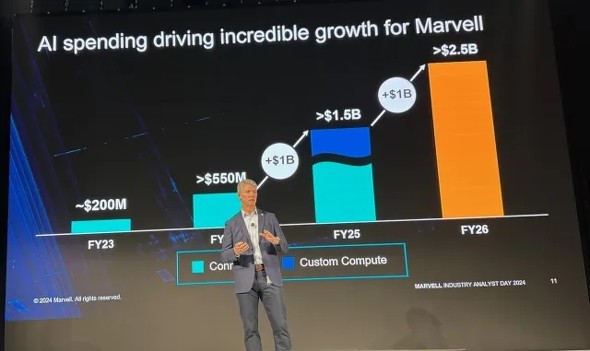

データセンターインフラ市場は、AI(人工知能)/ML(機械学習)のコンピュート需要を支援する必要性を受けて、急成長を遂げている。Marvell Technology(以下、Marvell)のCOO(最高執行責任者)であるChris Koopmans氏によれば、ハイパースケーラー各社の2024年の設備投資額は1000億米ドルを超え、その結果、同社の2025年度第3四半期(2024年11月2日を末日とする)におけるデータセンター市場向けインターコネクト/カスタムシリコンの売上高が前年比成長率98%で10億米ドルを突破し、記録的な業績を達成したという。

Koopmans氏は、2024年12月に米国カリフォルニア州サンタクララで開催された「Marvell Industry Analyst Day」において、「Marvellは今や、売上高全体の70%超をデータセンター関連が占める、データセンター企業となった」と述べている。

同氏は、「データセンターは現在、Marvellにとって最大のチャンスであり、既にカスタムシリコンが売上高をもたらしている」と述べる。さらに、同社のクラウドオプティクスグループを率いるLoi Nguyen氏は、「ハイパースケーラーは、自社サービスの差別化を必要としているため、今後さらに多くのハイパースケールプロバイダーが、独自のカスタムAIインフラを構築するようになるだろう。Marvellは、次の注目の的となるAIチップメーカーだ」と述べている。

MarvellのCEO(最高経営責任者)であるMatt Murphy氏は、「これは大きなチャンスだが、われわれは現在まだAIイノベーションサイクルのほんの初期の段階にある」と付け加えた。

ボトルネックになっているHBM

Analyst Dayのプレゼンテーションの中でMarvellのメッセージの大部分を占めていたのは、AIデータセンター向けのカスタムコンピュートやストレージ、コネクティビティの必要性だ。この点に関して同社はMicron TechnologyやSamsung Electronics、SK Hynixとの協業により、優れたコンピュート/メモリ密度を達成する新しいカスタムHBM(広帯域幅メモリ)コンピュートアーキテクチャを発表している。

Marvellでシニアバイスプレジデント兼カスタムコンピュート/ストレージグループ担当ゼネラルマネジャーを務めるWill Chu氏は、「HBMは現在、多くのAIデータセンターアプリケーションにおいてボトルネックとなっている。このため大手クラウドデータセンターオペレーターは、カスタムインフラで拡張したり、HBMを特定の性能や電力、総費用(TCO:Total Cost of Ownership)に最適化することでXPUを高性能化している。これにより、AIアクセラレーターの設計/提供方法への対応も可能になる見込みだ」と述べている。

これはつまり、HBMは、2.5D(次元)先進パッケージング技術と業界標準の高速インタフェースを使用してXPUに統合される重要なコンポーネントであるということだ。しかし、XPUのスケーリングは、既存の標準インタフェースをベースとしたアーキテクチャによって制約されている。このため、MarvellのカスタムHBMコンピュートアーキテクチャは、特定のXPU設計向けに性能や消費電力、ダイサイズ、コストを最適化することが可能な専用インタフェースを導入しているという。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- ローム、TSMCのライセンス取得し650V GaNパワー半導体を自社生産へ

- 定年間際のエンジニアが博士課程進学を選んだ「本当の理由」

- Intelとソフトバンク子会社が次世代メモリ開発へ 29年度に実用化

- TIがSilicon Labsを75億ドルで買収する理由

- AIは「バブル」ではない――桁違いの計算量が半導体に地殻変動を起こす

- ソシオネクスト増収減益、中国向け車載新規品は順調に増加

- AI時代のニーズ捉え開発加速、キオクシア次期社長の展望

- SAIMEMORYの新構造メモリ 低消費電力に焦点

- 三菱電機の半導体は光デバイス好調 3Q受注高49%増

- TSMCは2nmで主導権維持、SamsungとIntelに勝機はあるか